Взгляд на то, как люди обсуждают ложный контент в Интернете, и как изучение дискурсов в социальных сетях может помочь усилить политические меры реагирования.

В феврале 2024 года вступит в силу Закон Европейского Союза о цифровых услугах (DSA). DSA будет обеспечивать соблюдение стандарта прозрачности на очень крупных платформах социальных сетей, обязывая их объяснять, как работают их сложные, запатентованные алгоритмы рекомендации контента. Этот закон является ответом на многолетнюю дезинформацию, подпитываемую алгоритмами, которая подорвала общественное доверие и привела к реальному вреду (Jolley & Paterson, 2020; Wardle & Singerman, 2021).

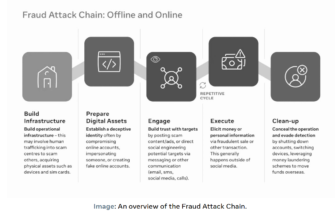

Алгоритмы и распространение дезинформации неразрывно связаны. Алгоритмические рекомендательные системы, которые предлагают пользователям новый контент, могут служить вектором между производителями дезинформации и пользователями социальных сетей, потенциально предоставляя ложный и вредный контент. Понимание этих систем, их последствий и общественного восприятия алгоритмов жизненно важно для формирования законодательства, которое реагирует на такие угрозы.

Общественное восприятие дезинформации

В моем исследовании используются корпусные лингвистические подходы для изучения репликации и восприятия онлайн-дезинформации в социальных сетях. Я сосредотачиваюсь на том, как с лингвистической точки зрения люди делятся ложным контентом в Интернете и как идеи в Интернете распространяются с момента их зарождения до тех пор, пока они не перестанут существовать. Это предполагает изучение метакомментариев к дезинформации или, проще говоря, изучение того, как люди говорят о самой дезинформации.

Понимание того, как публично обсуждаются важные темы, является проверенным методом понимания их с большей детализацией, будь то рассуждения об исламе (Baker et al., 2013), дискуссии о вакцинации (Coltman-Patel et al., 2022). или исследование языка ненависти в Интернете (Hardaker & McGlashan, 2016). Дезинформация представляет угрозу безопасности, затрудняя процесс принятия решений как на индивидуальном, так и на национальном уровне. Понимание того, как общественность воспринимает дезинформацию, имеет решающее значение для смягчения ее последствий.

Алгоритмическая дезинформация — это сложная проблема, которая требует столь же сложного решения, сочетающего в себе регулирование, политику, образование и проверку фактов. Но что, если общественность не всегда воспринимает это как проблему? При анализе почти 40 000 твитов* за первые шесть месяцев 2022 года, содержащих слова «дезинформация», «дезинформация» или «фейковые новости», слово «алгоритм» упоминается всего в 24 твитах. Для сравнения: слово «собака»/«собаки», не имеющее отношения к рассматриваемой теме, упоминается в 31 твите. То есть люди чаще обсуждают собак, чем алгоритмы в отношении дезинформации, дезинформации и фейковых новостей в наборе данных.

…люди обсуждают собак чаще, чем алгоритмы в отношении дезинформации, дезинформации и фейковых новостей…

Это имеет последствия для того, как мы боремся с алгоритмической дезинформацией в Интернете, потому что, если осведомленность низкая, политические меры, такие как DSA, могут рассматриваться как непропорциональные по масштабу с точки зрения общественного восприятия проблемы. Алгоритмы имеют фундаментальное значение для социальных сетей и распространения дезинформации в Интернете. Хотя отсутствие явного упоминания не означает полного отсутствия знаний, похоже, существует пробел в осведомленности. Эти данные дают представление о дискуссиях, и, учитывая обширные политические меры реагирования на дезинформацию, крайне важно извлечь уроки из этих результатов.

Когда общественность действительно обсуждает дезинформацию, она остро осознает ее опасность. Онлайн-дискуссии особо подчеркивают угрозу демократии, вызванную дезинформацией, то, как она нарушает права человека, а также ее непропорциональное влияние на такие вопросы, как репродуктивное здравоохранение. Повсюду дезинформация преподносится как враг, с которым мы должны бороться и бороться. Однако здесь есть парадокс. Исследования показали, что простое обсуждение дезинформации и ее негативных последствий может повлиять на такие ключевые показатели, как доверие и цинизм (Jones-Jang et al., 2020; Vaccari & Chadwick, 2020). Поэтому, борясь с дезинформацией, мы должны осознавать, что чрезмерное внимание к этой теме может принести больше вреда, чем пользы.

…при борьбе с дезинформацией мы должны осознавать, что чрезмерное внимание к этой теме может принести больше вреда, чем пользы.

Информирование политических мер

Общественность осознает вредный потенциал дезинформации, которая может угрожать гражданским свободам и влиять на наши институты, но она не обязательно знакома с нюансами того, как дезинформация распространяется через такие технологии, как алгоритмы. В ответах на дезинформацию приоритет должен отдаваться человеческому аспекту, а технические и социальные аспекты дезинформации следует рассматривать не как отдельные, а скорее как взаимосвязанные элементы. Изучение реальных проблем людей в естественных условиях помогает нам понять, что их беспокоит и как изменения в нашей информационной онлайн-среде могут решить подлинные проблемы, связанные с распространением дезинформации.

Кроме того, для эффективного подхода крайне важно обосновать политические меры реагирования на угрозы безопасности в реальных ситуациях. Политика, направленная на решение подлинных проблем общественности, с большей вероятностью получит общественную поддержку и будет способствовать позитивным изменениям, помогая уменьшить воздействие дезинформации. Это включает в себя борьбу с угрозами здоровью, такими как дезинформация, отвергающая традиционную медицину, и реагирование на информационные операции, использующие дезинформацию в качестве средства для подрыва демократии. Лица, подвергающиеся наибольшему риску дезинформации, — это сама общественность, и именно ее проблемы должны определять нашу реакцию на дезинформацию.

Уильям Дэнс / William Dance — аспирант и старший научный сотрудник Центра корпусных подходов к социальным наукам ESRC при Ланкастерском университете. Его исследования сочетают исторические подходы к изучению языка с анализом современных наборов данных социальных сетей для изучения развития дезинформации на протяжении веков.

*Твиттер теперь называется X, а твиты теперь называются сообщениями.

Источник:

https://crestresearch.ac.uk/comment/addressing-algorithms-in-disinformation/