Оригинальная статья Нильса Ауна, Итая Эпштейна, Сары Паркер и Селлы Уордроп из Encode Justice Canada .

- Введение

- Как работают алгоритмы социальных сетей

- Алгоритм рекомендации TikTok

- Алгоритм рекомендации YouTube

- Почему это должно иметь для меня значение?

- Мониторинг и регулирование социальных сетей

- Модерация разжигания ненависти: мета-кейс

- Регулирование онлайн-контента

- Свобода слова в социальных сетях: постановление правительства Канады

- Билл С-10

- Технический документ

- Заключение

- Примечания

Введение

Сара Паркер

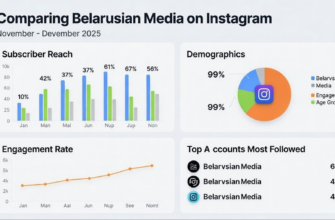

Социальные сети стали важной частью жизни любого молодого канадца. Такие платформы, как Instagram, Facebook и Snapchat, позволяют пользователям общаться друг с другом в любое время и в любом месте, а TikTok и YouTube предоставляют бесконечное количество контента и развлечений. Следовательно, пользователи должны знать, что происходит «за кулисами» их наиболее часто используемых приложений, чтобы понять, какое влияние они могут оказать на их жизнь. Кроме того, опасностей, как и преимуществ, социальных сетей много; поэтому мы изучаем правила, которые могут смягчить некоторые из этих вредностей.

Как работают алгоритмы социальных сетей

Итай Эпштейн

TikTok и Youtube — одни из самых влиятельных и популярных социальных сетей 21 века. Содержание их алгоритмов рекомендаций иногда бывает пугающе точным и заставляет пользователей задуматься о правилах, лежащих в основе этого, и о данных, необходимых для получения таких результатов. [1]

Алгоритм рекомендации TikTok

Большинство пользователей TikTok просматривают видео через страницу приложения «Для вас». Здесь алгоритм рекомендаций TikTok передает видео своим пользователям. Алгоритм TikTok начинает выдавать точные результаты всего через 36 минут просмотра (около 224 видео). [2] К этому моменту алгоритм начинает понимать симпатии и антипатии отдельных пользователей и начинает рекомендовать контент, с которым они, скорее всего, заинтересуются.

Входные данные, которые использует алгоритм, варьируются от видео, которые нравятся пользователям и которыми они делятся, и создателей, на которых они подписаны, до информации о самом видео, такой как хэштеги и используемое аудио. Хотя все они важны для классификации видео, наиболее важной метрикой, которую алгоритм учитывает при рекомендации контента, является взаимодействие с видео — по сути, как долго пользователь смотрит видео. [3]

Если пользователь просматривает видео полностью, он увидит больше похожего на него, тогда как если видео пролистывается или не заканчивается, алгоритм отмечает, что не следует часто показывать подобный контент этому пользователю или полностью блокировать его. Это создает то, что называется «пузырем фильтров», в котором пользователь классифицируется по определенной нише или сообществу видео, которые точно отражают симпатии и антипатии пользователя. [4] В некотором смысле TikTok «кормит» пользователей контентом: в приложении вы можете видеть только то, что, по мнению TikTok, вам нужно.

Алгоритм рекомендации YouTube

Youtube — видеогигант, существующий уже почти 20 лет, и его влияние широко известно. За это время его алгоритм рекомендаций сильно изменился. В настоящее время алгоритм рекомендаций Youtube обеспечивает ежедневное просмотр более 700 000 000 часов контента. Алгоритм управляет более чем 70% общего времени просмотра и, таким образом, является одним из важнейших факторов, определяющих то, что люди видят. [5]

YouTube функционирует так же, как TikTok, в том смысле, что он больше взвешивает время, в течение которого пользователь просматривает видео, чтобы определить, с какими другими видео они, скорее всего, будут больше взаимодействовать и смотреть его полностью. Благодаря этому создается «фильтрующий пузырь». [6[ Эти пузыри показывают пользователям видео, которые более похожи друг на друга, направляя их в кроличью нору похожего контента или видео, с которыми взаимодействовали похожие пользователи.

Почему это должно иметь для меня значение?

В целом алгоритмы рекомендаций Youtube и TikTok работают в основном одинаково. Прежде чем рекомендовать пользователю новые видео, они определяют, с каким контентом они больше всего взаимодействуют, тем самым рекомендуя им более похожий контент. Обе компании также преследуют одну и ту же цель — увеличить время, затрачиваемое на каждую из своих соответствующих платформ, — чего им помогают алгоритмы рекомендаций.

Как пользователь, важно знать силу алгоритмов рекомендаций. Они контролируют то, что видно в Интернете, и знание того, как они работают, может помочь внести ясность и понимание того, что потребляется, а также вернуть некоторое влияние используемых платформ. Попадание в фильтрующие пузыри или «эхо-камеры» может существенно повлиять на то, как вы видите мир, и может вызвать у вас недоверие или гнев по отношению к другим группам людей, которые не видят вещи так, как вы. Эти пузыри также могут быть источником политической поляризации и дезинформации, поэтому важно знать, как распознать, когда вы попали в них.

Мониторинг и регулирование социальных сетей

Нильс Аун

Интернет позволил совершить неописуемый прогресс благодаря своей невиданной ранее способности собирать и связывать людей по всему миру. Социальные сети сыграли большую роль, позволив людям делиться контентом с другими пользователями, позволяя им рассказывать истории, сообщая людям на другом конце земного шара, что происходит в их стране, и многое другое. Не умаляя больших преимуществ, которые дали нам социальные сети, важно учитывать негативные аспекты этой технологии, меняющей мир. Среди прочего, социальные сети упростили распространение вредоносного контента, такого как разжигание ненависти и террористическая пропаганда. [7] Как было замечено в прошлом, кампании по дезинформации, направленные на вмешательство в выборы, а именно в президентские выборы в США 2016 г.,

Модерация разжигания ненависти: мета-кейс

Основное противоречие вокруг регулирования контента заключается в том, чтобы сбалансировать модерацию с основными правами, такими как свобода слова, с правительствами, учеными и другими сторонами, обсуждающими вопрос о том, следует ли и как привлекать технологические компании к ответственности за действия пользователей на их платформах. В следующем разделе будут рассмотрены методы регулирования Meta (Facebook), чтобы понять, как в настоящее время компании социальных сетей регулируют контент.

Meta в основном полагается на свои модели искусственного интеллекта для обнаружения и удаления разжигания ненависти: по данным компании, 97% разжигания ненависти на платформе обнаруживаются автоматизированными системами, прежде чем пользователь отмечает их. [8] Однако, согласно отчетам, полученным Wall Street Journal и получившим название «Файлы Facebook», эти системы способны удалить только 2% разжигающих ненависть высказываний на Facebook. Хотя это серьезное расхождение в результатах, одно можно сказать наверняка: автоматическое распознавание вредоносного контента в Интернете затруднено.

Регулирование онлайн-контента

Несмотря на сложность, мы считаем, что регулирование платформ социальных сетей важно, во многом так же, как писаные и неписаные правила, регулирующие гражданское общество, важны для поддержания мира и безопасности. Для решения проблем, связанных с новой средой, возникшей благодаря новым технологиям, регулирующим органам следует обеспечить стимулы для компаний, чтобы они действовали ответственно, будь то положительные или отрицательные подкрепления — поощрять компании, которые выполняют свою часть работы, и/или наказывать тех, кто этого не делает. Правила должны учитывать глобальный характер Интернета; необходимо международное сотрудничество, поскольку социальные сети предполагают трансграничное общение. Кроме того, хотя регулирующие органы должны учитывать влияние своих решений на свободу выражения мнений, им также следует стремиться углубить свое понимание того, что технологии могут и чего не могут делать в отношении модерации контента, предоставляя компаниям «гибкость для инноваций». Тем не менее, новые правила необходимы не в каждом случае, поскольку то, что происходит в реальной жизни, может найти применение в онлайн-мире: «Регулирующие органы должны учитывать серьезность и распространенность рассматриваемого вредоносного контента, его правовой статус и усилия, уже ведется работа над содержанием». [9] и усилия, которые уже предпринимаются для решения проблемы». [9] и усилия, которые уже предпринимаются для решения проблемы». [9]

В заключение следует отметить, что компании, работающие в социальных сетях, могут отслеживать и регулировать контент на своих платформах многими способами, а правительства — обеспечивать это. Хорошо регулируемая сеть полезна для успеха Интернета, поскольку «сформулирует четкие способы для правительства, компаний и гражданского общества разделить обязанности и работать вместе». [10] Плохо разработанная правовая база по этим вопросам может привести к негативным последствиям и сделать онлайн-среду менее безопасной. Над этими проблемами стоит поработать, так как успешное создание структуры, охватывающей большинство, если не все аспекты потенциального вреда социальных сетей, принесет пользу всем — с безопасным контентом, достоверной информацией и защитой конфиденциальности пользователей.

Свобода слова в социальных сетях: постановление правительства Канады

Селла Уордроп

Являясь соучредителем Коалиции за свободу СМИ, Канада является мировым лидером в продвижении свободы слова. [11] Как написано в конституции Канады, Канада привержена «свободе мысли, убеждений, мнений и выражения». [12] С ростом активности в Интернете Канада стала членом Коалиции за свободу в Интернете, посвятив себя продвижению свободы в Интернете. [13] Тем не менее, Канада, как и многие другие страны, боролась с тем, как регулировать онлайн-активность, не нарушая свободу выражения мнений.

Билл С-10

Правительство Канады представило несколько весьма противоречивых законопроектов, направленных на решение проблем, связанных с интернет-услугами. В попытке распространить влияние Закона о вещании на более современный контекст Палата общин Канады приняла законопроект C-10 в июне 2021 года. [14] Если он станет законом, законопроект C-10 потребует потоковых услуг и платформы социальных сетей для продвижения контента канадских авторов. [15] Однако это предложение вызвало негативную реакцию со стороны правозащитников и интернет-активистов, опасавшихся, что оно даст CRTC слишком большую власть над цифровыми платформами и ущемит свободу выражения мнений. [16]

Технический документ

В июле 2021 года правительство Канады выпустило технический документ, в котором излагаются возможные планы по устранению и мониторингу вредоносного контента в социальных сетях. [17] Предложение направлено на борьбу с «пятью типами вредоносного контента», описываемыми как «сексуальная эксплуатация детей», «террористический контент», «контент, подстрекающий к насилию», «разжигание ненависти» и «обмен информацией без согласия». интимные образы». [18] Это предложение вызвало заметную негативную реакцию со стороны правозащитных и правозащитных групп, которые утверждают, что, среди прочего, такая политика будет угрожать канадским ценностям свободы выражения мнений и либеральной демократии. [19]

Технический документ направлен на регулирование служб онлайн-коммуникаций (OCS), которые определяются как онлайн-службы, «основной целью» которых является «предоставление пользователям службы возможности общаться с другими пользователями службы через Интернет», исключая службы, которые только разрешить пользователям иметь «частное общение». [20] Критики говорят, что это определение является слишком расплывчатым и неточно передает намерение правительства регулировать социальные сети, такие как YouTube и Twitter, и исключать интернет-сервисы, такие как TripAdvisor. [21] Предложение правительства требует от OCS удалять «вредный контент» со своих платформ в течение двадцати четырех часов после определения его как вредного. [22] Это требование перекликается с требованием противоречивого закона Германии о NetzDG, на основе которого многие авторитарные режимы смоделировали свои законы об онлайн-цензуре. [23] Излишне говорить, что возможная интеграция онлайн-политики авторитарного стиля в канадское законодательство беспокоит многих канадцев. Канадская клиника интернет-политики и общественных интересов Самуэльсона-Глушко, базирующаяся в Университете Оттавы, заходит так далеко, что называет эти требования «драконовскими» и утверждает, что они позволят «чрезмерно удалять и подвергать цензуре законные выражения». [24] Клиника утверждает, что для того, чтобы правительство помечало потенциально опасный контент, весь контент должен контролироваться, что дает правительству доступ ко всему пользовательскому контенту. [25] » и утверждает, что они позволят «чрезмерно удалять и подвергать цензуре законные выражения». [24] Клиника утверждает, что для того, чтобы правительство помечало потенциально опасный контент, весь контент должен контролироваться, что дает правительству доступ ко всему пользовательскому контенту. [25] » и утверждает, что они позволят «чрезмерно удалять и подвергать цензуре законные выражения». [24] Клиника утверждает, что для того, чтобы правительство помечало потенциально опасный контент, весь контент должен контролироваться, что дает правительству доступ ко всему пользовательскому контенту. [25]

Предложение правительства также включает отчетность о пользовательских данных, таких как пользовательский контент и активность, в Королевскую канадскую конную полицию и Канадскую службу безопасности и разведки, касающиеся многих правозащитников. [26] Сторонники утверждают, что предоставление правительству и правоохранительным органам доступа к личной информации пользователей несовместимо с канадскими ценностями свободы и демократии. [27]

Еще одним спорным моментом является рекомендация правительства использовать OCS «автоматизированные системы» для выявления «вредоносного контента». [28] Компьютерные алгоритмы могут быть не только предвзятыми, но и неспособными различать незаконный контент и «незаконный» контент, который используется в законном контексте, например, в качестве образовательного или новостного контента. [29] Исследования также показали, что контент из маргинализированных сообществ удаляется платформами социальных сетей с непропорционально высокой скоростью по сравнению с более массовым контентом, что позволяет предположить, что это регулирование может еще больше заставить замолчать маргинализированные голоса. [30] Поскольку одним из заявленных основных направлений онлайн-регулирования правительства Канады является борьба с ненавистью в Интернете, особенно с ее непропорциональным воздействием на маргинализированные группы, такие как женщины и коренные народы, предлагаемый закон может противодействовать его цели. [31]

После публикации предложения правительства по борьбе с распространением вредоносного контента в Интернете многие группы по защите прав человека опубликовали ответы с рекомендациями, как описано выше, о том, как лучше достичь цели правительства при сохранении основных канадских ценностей свободы и демократии. Общественная обратная связь представляет собой большую борьбу правительств за регулирование контента в социальных сетях, но надежду на лучшее регулирование интернета в будущем.

Заключение

Сара Паркер

Как показано в этом отчете, социальные сети предназначены для воздействия на своих пользователей, и поэтому важно обеспечить, чтобы это влияние было положительным. Молодые канадцы, в частности, должны понимать, как приложения на их телефонах могут влиять на них и формировать их мировоззрение, одновременно оказывая давление на представителей своего правительства, чтобы они ввели и обеспечили соблюдение правил, защищающих цифровое пространство. Интернет-мир, несомненно, теперь стал реальным миром: пришло время вести себя как он.

Примечания

[1] Лаура Мацакис, «Как на самом деле работает алгоритм TikTok «для вас»», Wired , опубликовано 18 июня 2020 г.: https://www.wired.com/story/tiktok-finally-explains-for-you-algorithm- работает.

[2] WSJDigitalNetwork, «Как вас вычисляет алгоритм Tiktok | WSJ», YouTube, опубликовано 21 июля 2021 г.: https://www.youtube.com/watch?v=nfczi2cI6Cs&feature=embtitle.

[3] Мацакис, «Как на самом деле работает алгоритм TikTok «для вас»».

[4] Там же.

[5] Wired: «Алгоритм YouTube контролирует нас?» YouTube , опубликовано 19 ноября 2020 г.: https://www.youtube.com/watch?v=XuORTmLhIiU.

[6] Гийом Шасло, «Токсичный потенциал петли обратной связи YouTube», Wired, опубликовано 13 июля 2019 г.: https://www.wired.com/story/the-toxic-potential-of-youtubes-feedback-loop/ .

[7] Моника Бикерт, «Прокладывая путь вперед в области регулирования онлайн-контента», Facebook , опубликовано 17 февраля 2020 г.: https://bit.ly/3CIJb2T.

[8] Майк Шропфер. «Обновленная информация о нашем прогрессе в области ИИ и обнаружения языка ненависти». Мета отдел новостей. 11 февраля 2021 г. https://about.fb.com/news/2021/02/update-on-our-progress-on-ai-and-hate-speech-detection/

[9] Там же.

[10] Там же.

[11] Министерство внутренних дел Канады, «Коммюнике министров Коалиции за свободу СМИ», опубликованное правительством Канады в ноябре 2020 г.: https://www.canada.ca/en/global-affairs/news/2020/11/media-freedom-coalition- министерское коммюнике.html.

[12] Канадская хартия прав и свобод , раздел 2, часть 1 Конституционного акта 1982 г., который является Приложением B к Закону о Канаде 1982 г. (Великобритания), 1982 г., c 11.

[13] Интернет-коалиция за свободу, «СВОБОДНАЯ ОНЛАЙН-КОАЛИЦИЯ: информационный бюллетень», опубликовано в 2021 г.: https://freedomonlinecoalition.com/wp-content/uploads/2021/05/FOC-Factsheet-2021.docx.pdf, и правительство Канады. , «Права человека и включение в онлайн и цифровой контекст», опубликовано в ноябре 2020 г.: https://www.international.gc.ca/world-monde/issues_development-enjeux_developpement/human_rights-droits_homme/internet_freedom-liberte_internet.aspx?lang=eng .

[14] Правительство Канады, «Законопроект C-10: Закон о внесении поправок в Закон о вещании и о внесении последующих поправок в другие законы», опубликованный в сентябре 2021 г.: https://www.justice.gc.ca/eng/csj- sjc/pl/charter-charte/c10.html.

[15] Кейт Болонгаро, «Партия Трюдо принимает законопроект о регулировании социальных сетей и потоковой передачи», Bloomberg.com, опубликовано 22 июня 2021 г.: https://www.bloomberg.com/news/articles/2021-06-22/trudeau. -s-партия-принимает-билль-о-регулировании потоковой передачи в социальных сетях и правительство Канады. «Билл С-10».

[16] Болонгаро, «Партия Трюдо».

[17] Правительство Канады, «Технический документ», опубликованный в июле 2021 г.: https://www.canada.ca/en/canadian-heritage/campaigns/harmful-online-content/technical-paper.html.

[18] Правительство Канады, «Технический документ».

[19] Юан Стивенс и Вивек Кришнамурти, «Пересмотр предложения о вреде в Интернете в Канаде: подход с точки зрения прав человека», Канадская клиника интернет-политики и общественных интересов , 2021 г., и Кара Цвибель, «Представление в связи с консультацией по обращению с вредоносным контентом в Интернете». », Канадская ассоциация гражданских свобод , опубликовано 25 сентября 2021 г.: https://ccla.org/wp-content/uploads/2021/09/CCLA-Submission-to-Heritage-Online-Harms.pdf.

[20] Правительство Канады, «Технический документ».

[21] Стивенс и Кришнамурти, «Пересмотр предложения об онлайн-ущербе в Канаде».

[22] Правительство Канады, «Технический документ».

[23] Стивенс и Кришнамурти, «Пересмотр предложения об онлайн-ущербе в Канаде».

[24] Там же.

[25] Там же.

[26] Правительство Канады, «Технический документ».

[27] Стивенс и Кришнамурти, «Пересмотр предложения об онлайн-ущербе в Канаде», и Майкл Гейст, «Возьмем то, на чем остановился Билл C-10: неконсультация правительства Канады по законодательству об онлайн-ущербе» , michaelgiest.com, опубликовано в июле. 30 сентября 2021 г.: https://www.michaelgeist.ca/2021/07/onlineharmsnonconsult/.

[28] Правительство Канады, «Технический документ».

[29] Дафна Келлер, «Пять больших проблем с предложенной Канадой нормативно-правовой базой для «вредного онлайн-контента», Tech Policy Press , опубликовано 31 августа 2021 г.: https://techpolicy.press/five-big-problems-with-canadas- предлагаемая-нормативная-основа-для-вредного-онлайн-контента/

[30] Анхель Диас и Лаура Хехт-Фелелла, «Двойные стандарты в модерации контента в социальных сетях», Центр правосудия Бреннана , опубликовано 4 августа 2021 г.: https://www.brennancenter.org/sites/default/files/2021 -08/Double_Standards_Content_Moderation.pdf.

[31] Правительство Канады, «Технический документ».

Источник:

https://montrealethics.ai/social-media-algorithms-the-code-behind-your-life/