Многие наблюдатели нынешнего взрыва генеративного искусственного интеллекта обеспокоены его влиянием на нашу информационную среду, при этом высказываются опасения по поводу увеличения количества, качества и персонализации дезинформации. Мы оцениваем эти аргументы с помощью данных исследований в области коммуникации, когнитивной науки и политологии. Мы утверждаем, что нынешние опасения по поводу воздействия генеративного ИИ на ландшафт дезинформации преувеличены.

Недавний прогресс в области генеративного ИИ привел к опасениям, что он «вызовет следующий кошмар дезинформации» (Gold & Fisher, 2023), что люди «больше не смогут знать, что является правдой» (Metz, 2023), и что мы столкнулись с «техническим Армагеддоном» (Скотт, 2023).

Генеративные системы искусственного интеллекта способны генерировать новые формы данных, применяя машинное обучение к большим объемам обучающих данных. Эти новые данные могут включать в себя текст (например, Bard от Google, LLaMa от Meta или ChatGPT от OpenAI), визуальные эффекты (например, Stable Diffusion или DALL-E от OpenAI) или аудио (например, VALL-E от Microsoft). Результаты, которые могут быть созданы с помощью этих систем с большой скоростью и легкостью для большинства пользователей, в зависимости от инструкций являются достаточно сложными, чтобы люди могли воспринимать их как неотличимые от контента, созданного человеком (Groh et al., 2022).

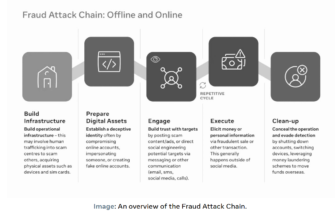

По мнению различных мнений, в том числе некоторых ведущих исследователей ИИ, генеративный ИИ облегчит создание реалистичного, но ложного или вводящего в заблуждение контента в больших масштабах, что может иметь катастрофические последствия для убеждений и поведения людей, общественной арены информации 1 и демократии . Эти опасения можно разделить на четыре категории (таблица 1).

| Аргумент | Пояснение претензии | Предполагаемый эффект | Источник |

| 1. Увеличение количества дезинформации | Благодаря простоте доступа и использования генеративный ИИ может использоваться для создания ложной/дезинформации в больших масштабах практически без затрат для отдельных лиц и организованных субъектов. | Увеличение количества дезинформации позволяет злонамеренным субъектам «наводнять зону» неверной или вводящей в заблуждение информацией, тем самым заглушая фактическое содержание и/или сея путаницу. | Белл (2023 г.), Фрид (2023 г.), Сюй и Томпсон (2023 г.), Маркус (2023 г.), Пастернак (2023 г.), Ордонез и др. (2023), Такер (2023), Загни и Канетта (2023) |

| 2. Повышение качества дезинформации | Благодаря своим техническим возможностям и простоте использования генеративные ИИ могут использоваться для создания дезинформации более высокого качества. | Повышенное качество дезинформации приводит к увеличению ее убедительного потенциала, поскольку она создает более правдоподобный контент, который труднее развенчать или проверить. Это либо приведет к распространению ложной информации, либо будет способствовать (с увеличением количества дезинформации) эпистемическому кризису, общей потере доверия ко всем типам новостей. | Эпштейн и Герцманн (2023 г.), Фрид (2023 г.), Гольдштейн и др. (2023), Сюй и Томпсон (2023), Пастернак (2023), Тику (2022), Такер (2023) |

| 3. Рост персонализации дезинформации | Генеративные ИИ могут генерировать полезный контент (например, чат-боты, генерирующие код). Однако они также могут генерировать правдоподобную информацию, которая является совершенно неточной. Таким образом, пользователи, сами того не желая, могут генерировать дезинформацию, которая потенциально может распространиться. | Увеличение убеждения потребителей в дезинформации с теми же результатами, что и выше. | Бенсон (2023), Фрид (2023), Сюй и Томпсон (2023), Пастернак (2023) |

| 4. Непроизвольное генерирование правдоподобной, но ложной информации. | Генеративные ИИ могут генерировать полезный контент (например, чат-боты, генерирующие код). Однако они также могут генерировать правдоподобную информацию, которая является совершенно неточной. Таким образом, пользователи, сами того не желая, могут генерировать дезинформацию, которая потенциально может распространиться. | Дезинформирование пользователей генеративного ИИ и, возможно, тех, с кем они делятся информацией. | Фрид (2023 г.), Голд и Фишер (2023 г.), Ордонез и др. (2023), Пастернак (2023), Шах и Бендер (2023), Загни и Канетта (2023) |

Мы, в свою очередь, рассматриваем первые три аргумента — количество, качество и персонализация — утверждая, что на данный момент они являются спекулятивными и что существующие исследования предполагают в лучшем случае умеренное влияние генеративного ИИ на ландшафт дезинформации. Рассматривая каждую из этих тем по очереди, мы утверждаем, что нынешние опасения по поводу последствий генеративного ИИ преувеличены.

Мы не рассматриваем здесь подробно четвертый аргумент, поскольку он выходит за рамки данного комментария и слишком характерен для постоянно развивающихся версий обсуждаемых инструментов генеративного ИИ и контекста использования (например, GPT-4 избегает многих из ошибки, допущенные GPT-2 или -3). Люди с низкой онлайн-грамотностью, вероятно, будут введены в заблуждение некоторыми из этих инструментов, но мы не видим четкого пути распространения ошибок, которые совершает генеративный ИИ в руках пользователей с благими намерениями, и создания значительного риска для общества. Аналогичным образом, риск случайного появления в новостном контенте фактически неточной информации, поскольку средства массовой информации все чаще используют генеративный искусственный интеллект (Hanley & Durumeric, 2023), вероятно, будет сокращен за счет усилий издателей по контролю за использованием этой технологии при производстве и распространении новостей (Hanley & Durumeric, 2023). Arguedas & Simon, 2023; Becker et al., 2023), хотя неспособность издателей реализовать такие меры или фундаментальная неосведомленность по этому вопросу по-прежнему вызывают обеспокоенность.

Увеличение количества дезинформации

Генеративный ИИ облегчает создание дезинформации, что может увеличить количество дезинформации. Однако люди обязательно будут потреблять больше дезинформации не потому, что стало больше дезинформации. Вместо этого мы утверждаем, что потребление дезинформации в основном ограничивается спросом, а не предложением.

Увеличение предложения дезинформации должно увеличить распространение дезинформации только в том случае, если в настоящее время существует неудовлетворенный спрос и/или ограниченное предложение дезинформации. Ни одна из возможностей не подтверждается доказательствами. Что касается ограниченного предложения, то и без того низкие затраты на производство и доступ к дезинформации, а также большое количество постов с дезинформацией, которые существуют в настоящее время, но остаются незамеченными, означают, что у генеративного ИИ очень мало возможностей для работы. Что касается неудовлетворенного спроса, то, учитывая креативность, которую люди демонстрировали на протяжении всей истории для создания (ложных) историй, и свободу, которой люди уже обладают, чтобы создавать и распространять дезинформацию по всему миру, маловероятно, что значительная часть населения ищет дезинформацию, которую они хотят. не могу найти ни онлайн, ни офлайн. Более того, как мы утверждаем ниже, спрос на дезинформацию относительно легко удовлетворить, поскольку конкретное содержание дезинформации менее важно, чем широкая версия, которую она поддерживает.

В абсолютном выражении дезинформация уже изобилует в Интернете и, в отличие от высококачественных новостей или научных статей, она редко скрывается за платным доступом. Тем не менее, несмотря на количество и доступность дезинформации, средний пользователь Интернета потребляет ее очень мало (например, Allen et al., 2020; для обзора см. Acerbi et al., 2022). Вместо этого потребление дезинформации в значительной степени сконцентрировано у небольшой части очень активных и громких пользователей (Гринберг и др., 2019). Что делает потребителей дезинформации особенными, так это не то, что они имеют привилегированный доступ к дезинформации, а черты, которые делают их более склонными к поиску дезинформации (Broniatowski et al., 2023; Motta et al., 2023), например, низкое доверие к институтам или сильные сторонники (Осмундсен и др., 2021). Эксперты по дезинформации рассматривают партийную принадлежность и идентичность как ключевые детерминанты убеждений и распространения дезинформации, в то время как они полагают, что отсутствие доступа к достоверной информации играет лишь незначительную роль (Алтай и др., 2023). Проблема не в том, что люди не имеют доступа к качественной информации, а в том, что они отвергают качественную информацию и предпочитают дезинформацию. Точно так же теории заговора существуют повсюду и легко доступны в Интернете по всему миру. Тем не менее, несмотря на сходство предложения, спрос на теории заговора варьируется в зависимости от страны, так что в более коррумпированных странах теории заговора более популярны (Alper, 2023; Cordonier & Cafiero, 2023).

Наконец, (неправильная) информация сама по себе не оказывает причинного воздействия на мир. (Неверная) информация приобретает причинную силу только тогда, когда люди ее видят. Тем не менее, количество вещей, которые становятся вирусными в Интернете и становятся видимыми, конечно, потому что наше внимание ограничено (Jungherr & Schroeder, 2021a; Taylor, 2014). А поскольку генеративный ИИ вряд ли увеличит спрос на дезинформацию и не увеличит количество вещей, на которые люди могут обратить внимание, увеличение предложения дезинформации, вероятно, будет иметь ограниченное влияние на распространение дезинформации.

Повышенное качество дезинформации

Еще один аргумент в пользу того, что генеративный ИИ представляет значительную угрозу для общественной жизни, заключается в том, что генеративный ИИ может помочь создать дезинформацию, которая будет более убедительной, чем та, которая создается нынешними средствами. Например, точно так же, как генеративный ИИ может создавать текст в стиле лимерика или конкретного автора, генеративный ИИ может создавать контент, который выглядит более надежным, профессиональным, научным и точным (за счет использования сложных слов, подходящих слов). тон, научно выглядящие ссылки и т. д.). Экспериментальные исследования показали, что такие особенности могут повлиять на доверие к онлайн-источникам (например, Metzger, 2007), что подтверждает этот аргумент. Однако есть как минимум три причины, по которым это не может быть серьезной причиной для беспокойства.

Во-первых, кажется, что производителям дезинформации уже будет относительно легко повысить воспринимаемую надежность своего контента. В области визуальных эффектов Photoshop уже давно предоставляет плохим актерам возможность придавать искусственно созданному изображению реальный вид (Kapoor & Narayanan, 2023). Если они решат не делать этого, это может быть связано с тем, что придание тексту или изображению более достоверного или реального вида может противоречить другим целям, например, сделать их более доступными, привлекательными или кажущимися аутентичными. Неясно, смогут ли генеративные ИИ повысить качество контента по нескольким направлениям, поскольку могут возникнуть некоторые неизбежные компромиссы.

Во-вторых, даже если генеративному ИИ удалось повысить общую привлекательность дезинформации, большинство людей просто не подвергаются или лишь незначительно подвергаются дезинформации (см. выше и Acerbi et al., 2022). Вместо этого большинство людей в подавляющем большинстве потребляют контент из основных источников, как правило, из одной и той же горстки популярных СМИ (Altay et al., 2022; Guess et al., 2021). В результате любое повышение качества вводящего в заблуждение контента будет практически незаметно для большей части общественности.

В-третьих, генеративный искусственный интеллект также может помочь повысить качество надежных источников новостей, например, облегчая работу журналистов в некоторых областях. Учитывая редкость вводящего в заблуждение контента по сравнению с достоверным контентом, рост привлекательности дезинформации должен быть в 20–100 раз больше, чем рост привлекательности достоверного контента, чтобы эффект генеративного ИИ склонил чашу весов в пользу дезинформации. (Ачерби и др., 2022). Нам не известен ни один аргумент, который позволил бы предположить такой огромный дисбаланс в воздействии генеративного ИИ на дезинформацию и достоверную информацию.

В-четвертых, утверждалось, что генеративный ИИ предоставляет субъектам новый аргумент в пользу правдоподобного отрицания в так называемом «дивиденде лжеца» — когда доступность технологии, создающей высококачественный контент, может использоваться для отклонения компрометирующих доказательств как фальшивых ( Кристофер, 2023). Однако, хотя существуют ограниченные доказательства того, что такая стратегия может иметь какой-то эффект, например, для политиков (Schiff et al., 2023), эта возможность не зависит от самой технологии. Как упоминалось выше, технология, позволяющая создавать правдоподобный фейковый контент, доступна уже (по крайней мере) десятилетия и уже используется в попытках дискредитировать доказательства. 2 Вероятно, основным фактором, определяющим эффективность таких попыток, является не вероятность того, что данная технология способна генерировать некоторый контент, а другие факторы, такие как партийная принадлежность или ранее существовавшее доверие людей к человеку, пытающемуся дискредитировать доказательства (Ecker et al. , 2022).

Повышенная персонализация дезинформации

Последний аргумент заключается в том, что генеративный ИИ облегчит создание и микротаргетирование пользователей с помощью персонализированной дезинформации, которая будет соответствовать их убеждениям и предпочтениям, что облегчит их убеждение или введение в заблуждение. Глядя на способности генеративного ИИ имитировать различные стили и личности, это, безусловно, кажется правдоподобным. Однако с этим аргументом есть и проблемы.

Во-первых, усовершенствования генеративного ИИ напрямую не влияют на технологические инфраструктуры, обеспечивающие микротаргетинг контента на пользователей (хотя они могут улучшиться благодаря достижениям в области ИИ в более широком смысле). 3 В результате генеративный ИИ не должен влиять на эффективность инфраструктуры, посредством которой контент доходит до отдельных лиц. Узким местом остается стоимость распространения дезинформации среди людей, а не стоимость ее создания (см. также Kapoor & Narayanan, 2023). Кроме того, данные свидетельствуют о том, что микротаргетинг, например, со стороны политических деятелей, имеет в основном ограниченный эффект убеждения на большинство получателей (Jungherr et al., 2020; Simon, 2019), не в последнюю очередь потому, что многие люди не обращают внимания на эти сообщения в первую очередь (Kahloon & Ramani, 2023).

Тем не менее, генеративный ИИ может улучшить содержание уже нацеленной дезинформации, сделав ее более подходящей для своей цели. Однако данные об эффективности политической рекламы, персонализированной, например, для людей с разными характерами, неоднозначны, в лучшем случае с небольшим и зависящим от контекста эффектом (Zarouali et al., 2022). Кроме того, предположение о том, что генеративный ИИ сможет создавать более персонализированный и, следовательно, более убедительный контент, пока не доказано. Современные генеративные ИИ обучаются через определенные промежутки времени на большом общем массиве данных, чему способствуют такие подходы, как обучение с подкреплением с обратной связью от человека (RLHF) или генерация с расширенным поиском (RAG), когда система информационного поиска предоставляет более актуальные данные, когда LLM производит продукцию. Однако в настоящее время LLM не могут отражать весь спектр предпочтений и ценностей пользователей (Kirk et al., 2023) и не содержат прямой информации о самих пользователях, что серьезно ограничивает их возможности создавать по-настоящему персонализированный контент, соответствующий предпочтения человека (Ньюпорт, 2023). Даже несмотря на достижения на этих фронтах, имеющиеся данные свидетельствуют о том, что убедительные эффекты микротаргетинга, в том числе с помощью LLM, часто ограничены и сильно зависят от контекста (Hackenburg & Margetts, 2023; Tappin et al., 2023). В целом, эффект от политической рекламы невелик и, скорее всего, таковым и останется, независимо от того, является ли он (микро)целевым или нет, поскольку убедить сложно (Coppock, 2023; Mercier, 2020).

Заключение

Мы утверждали, что опасения по поводу воздействия генеративного ИИ на информационный ландшафт – и, в частности, на распространение дезинформации – преувеличены. Эти опасения являются частью старой и широкой семьи моральной паники вокруг новых технологий (Jungherr & Schroeder, 2021b; Orben, 2020; Simon & Camargo, 2021). Когда дело доходит до новых информационных технологий, такая паника может быть основана на ошибочном предположении, что люди легковерны, отчасти вызванном эффектом третьего лица (Altay & Acerbi, 2023; Mercier, 2020).

Эти опасения также имеют тенденцию упускать из виду тот факт, что мы уже обязаны нашей нынешней информационной средой сложной сети институтов, которая позволила средствам массовой информации предоставлять широко точную информацию, а общественности, в свою очередь, доверять большей части информации, сообщаемой СМИ. Эти институты уже развились, чтобы приспособиться к новым медиа, таким как кино и фотография (Habgood-Cote, 2023; Jurgenson, 2019), хотя манипулировать этими медиа всегда можно было. Более того, далеко не очевидно, что более технологически сложные формы манипуляции являются наиболее эффективными: сегодня журналисты и фактчекеры борются не столько с дипфейками, сколько с визуальными эффектами, вырванными из контекста, или с грубыми манипуляциями, такими как обрезка изображений и т. д. — так называемые «дешевые подделки» (Brennen et al., 2020; Kapoor & Narayanan, 2023; Paris & Donovan, 2019; Weikmann & Lecheler, 2023).

Ограничением нашей аргументации является то, что мы в основном полагаемся на данные о медиа-среде богатых, демократических стран с богатой и конкурентоспособной медиа-экосистемой. В других странах доступно меньше данных, и мы не можем исключать, что генеративный ИИ может иметь больший отрицательный эффект там (хотя, возможно, генеративный ИИ также может иметь больший положительный эффект в этих странах).

Мы не утверждаем, что ничего не нужно делать для регулирования или решения проблемы генеративного ИИ. Если дезинформация настолько редка в информационной среде богатых, демократических стран, то это благодаря напряженной работе профессионалов — журналистов, фактчекеров, экспертов и т. д. — а также нормам и ноу-хау, которые со временем сложились в этих странах. профессии (например, Пэрис и Донован, 2019; Сильверман, 2014). Укрепление этих институтов и доверия к достоверным новостям в целом (Acerbi et al., 2022), вероятно, будет иметь решающее значение. Журналисты, специалисты по проверке фактов, власти и правозащитники также столкнутся с новыми проблемами, и им придется разрабатывать новые нормы и практики, чтобы справиться с генеративным ИИ. 4 Сюда входят, например, нормы и ноу-хау, связанные с раскрытием, «отпечатками пальцев» контента и созданием механизмов происхождения. 5 Образование в области цифровой и медиаграмотности также может помочь смягчить проблемы, возникающие из-за дезинформации, создаваемой ИИ (например, Doss et al., 2023).

Время покажет, были ли паникёрские заголовки о генеративном ИИ оправданы или нет, но независимо от результата, обсуждение влияния генеративного ИИ на дезинформацию выиграло бы, если бы оно было более детальным и основанным на фактических данных, особенно на фоне продолжающихся усилий по регулированию.

Совет Европы (2019), например, подчеркивает, что осуществление и реализация индивидуальных прав человека и «достоинства всех людей как независимых моральных агентов» должны быть защищены от недостаточно изученных форм алгоритмического (с помощью) убеждения, которые «могут иметь значительные последствия». влияние на когнитивную автономию людей и их право формировать мнения и принимать независимые решения» (пункт 9). В других странах предстоящий Закон ЕС об искусственном интеллекте, скорее всего, будет включать в себя положения о том, как лучше всего решать обсуждаемые здесь вопросы, в то время как Соединенные Штаты выпустили проект «Билля о правах искусственного интеллекта» и пытаются регулировать использование искусственного интеллекта в трудных условиях. политическая среда. Кроме того, неправительственные организации, такие как «Репортеры без границ», предпринимают усилия по разработке руководящих принципов, которые «защитят целостность информации» на фоне растущего использования ИИ для производства, распространения, поиска и потребления информации.

Тем не менее, хотя такие усилия похвальны и необходимы, они должны основываться на наилучших имеющихся доказательствах, особенно если эти доказательства ставят под сомнение общепринятую мудрость. Чрезмерные и спекулятивные предупреждения о пагубном влиянии ИИ на общественную арену и демократию, даже если они сделаны из лучших побуждений, также могут иметь негативные внешние последствия, такие как снижение доверия к фактически точным новостям и институтам, которые их производят (Hameleers, 2023) или затмение другие проблемы, создаваемые генеративным ИИ, такие как порнография без согласия, которая непропорционально вредит женщинам, даже если они не расширяются (Kapoor & Narayanan, 2023), или потенциальная возможность кражи личных данных и мошенничества.

Наша цель не состоит в том, чтобы урегулировать или закрыть дискуссию о возможном влиянии генеративного ИИ на нашу информационную среду. Мы также не хотим просто игнорировать опасения по поводу этой технологии. Вместо этого, в духе наблюдения Роберта Мертона о том, что «цель науки состоит в расширении подтвержденных знаний» на основе «организованного скептицизма» (Merton, 1973, стр. 267–278), мы надеемся внести свой вклад в первое, внедрив некоторые из последних включились в текущие дебаты о возможных эффектах генеративного ИИ.

Библиография

Ачерби А., Алтай С. и Мерсье Х. (2022). Примечание к исследованию: Борьба с дезинформацией или борьба за информацию? Обзор дезинформации Гарвардской школы Кеннеди (HKS) , 3 (1) . https://doi.org/10.37016/mr-2020-87

Альпер, С. (2023). В более коррумпированных странах существует более высокий уровень убеждений в заговоре. Европейский журнал социальной психологии , 53 (3), 503–517. https://doi.org/10.1002/ejsp.2919

Алтай С. и Ачерби А. (2023). Люди считают, что дезинформация представляет собой угрозу, потому что они полагают, что другие легковерны. Новые медиа и общество . https://doi.org/10.1177/14614448231153379

Алтай С., Нильсен Р.К. и Флетчер Р. (2022). Количественная оценка «инфодемии»: люди обратились к заслуживающим доверия новостным агентствам во время пандемии коронавируса 2020 года. Журнал количественного описания: Digital Media, 2. https://journalqd.org/article/view/3617/2703 .

Алтай С., Берриш М., Хойер Х., Фаркас Дж. и Ратье С. (2023). Обзор мнений экспертов о дезинформации: определения, определяющие факторы, решения и будущее этой области. Обзор дезинформации Гарвардской школы Кеннеди (HKS) , 4 (4). https://doi.org/10.37016/mr-2020-119

Аллен Дж., Хауленд Б., Мебиус М., Ротшильд Д. и Уоттс DJ (2020). Оценка проблемы фейковых новостей в масштабах информационной экосистемы. Достижения науки , 6 (14). https://doi.org/10.1126/sciadv.aay3539

Аргедас, Арканзас, и Саймон, FM (2023). Автоматизация демократии: генеративный искусственный интеллект, журналистика и будущее демократии . Междисциплинарный институт Баллиола Оксфордского университета. http://dx.doi.org/10.5287/ora-e262xv7no

Беккер, К.Б., Саймон, Ф.М., и Крам, К. (2023). Политика параллельно? Сравнительное исследование журналистской политики в области искусственного интеллекта в 52 мировых новостных организациях. СоцАрXiv. https://doi.org/10.31235/osf.io/c4af9

Белл, Э. (3 марта 2023 г.). Фейковые новости, ChatGPT, правда, журналистика, дезинформация. Хранитель . https://www.theguardian.com/commentisfree/2023/mar/03/fake-news-chatgpt-truth-journalism-disinformation

Бенсон, Т. (1 августа 2023 г.). Эта дезинформация только для вас. Проводной . https://www.wired.com/story/generative-ai-custom-disinformation/

Бреннен, Дж.С., Саймон, Ф.М., и Нильсен, Р.К. (2020). За пределами (неправильного) представления: визуальные эффекты в дезинформации о COVID-19. Международный журнал прессы/политики , 26 (1), 277–299. https://doi.org/10.1177/1940161220964780

Бронятовский Д.А., Саймонс Младший, Гу Дж., Джеймисон А.М. и Абромс Л.К. (2023). Эффективность политики и архитектуры Facebook по дезинформации о вакцинах во время пандемии COVID-19. Достижения науки , 9 (37). https://doi.org/10.1126/sciadv.adh2132

Кристофер, Н. (5 июля 2023 г.). Индийский политик заявил, что скандальные аудиоклипы — это дипфейки, созданные искусственным интеллектом. Мы их протестировали . Остальной мир. https://restofworld.org/2023/indian-politician-leaked-audio-ai-deepfake/

Коппок, А. (2023). Убеждение параллельно: как информация меняет мнение о политике . Издательство Чикагского университета.

Кордонье Л. и Кафьеро Ф. (2023). Коррупция в государственном секторе является благодатной почвой для убеждений в заговоре: сравнение 26 западных и незападных стран. ОСФ. https://doi.org/10.31219/osf.io/b24gk

Комитет министров Совета Европы. (2019, 13 февраля). Декларация Комитета Министров о манипулятивных возможностях алгоритмических процессов (Принята Комитетом Министров 13 февраля 2019 года на 1337-м заседании заместителей Министров). Совет Европы. https://search.coe.int/cm/pages/result_details.aspx?ObjectId=090000168092dd4b#globalcontainer

Досс К., Мондшейн Дж., Шу Д., Вольфсон Т., Копецки Д., Фиттон-Кейн В.А., Буш Л. и Такер К. (2023). Дипфейки и распространение научных знаний. Научные отчеты , 13 (1), 13429. https://doi.org/10.1038/s41598-023-39944-3 .

Экер, УХ, Левандовски, С., Кук, Дж., Шмид, П., Фацио, Л.К., Брашир, Н., Кендеу, П., Врага, Э.К., и Амазин, Массачусетс (2022). Психологические причины убеждения в дезинформации и ее сопротивление исправлению. Nature Reviews Psychology , 1 (1), 13–29. https://doi.org/10.1038/s44159-021-00006-y

Эпштейн З. и Хертманн А. (2023). Искусство и наука генеративного ИИ. Наука , 380 (6650), 1110–1111. https://doi.org/10.1126/science.adh4451

Фрид, И. (10 июля 2023 г.). Как ИИ будет усиливать дезинформацию — и что мы можем с этим поделать. Аксиос. https://www.axios.com/2023/07/10/ai-misinformation-response-measures

Гольдштейн Дж. А., Чао Дж., Гроссман С., Стамос А. и Томз М. (2023). Может ли ИИ писать убедительную пропаганду? СоцАрXiv. https://doi.org/10.31235/osf.io/fp87b

Голд А. и Фишер С. (21 февраля 2023 г.). Чат-боты вызывают очередной кошмар дезинформации. Аксиос. https://www.axios.com/2023/02/21/chatbots-misinformation-nightmare-chatgpt-ai

Грегори, С. (2023). Укрепляйте правду: как защитить права человека в эпоху дипфейков и генеративного искусственного интеллекта. Журнал практики прав человека , huad035. https://doi.org/10.1093/jhuman/huad035

Гринберг Н., Джозеф К., Фридланд Л., Свайр-Томпсон Б. и Лазер Д. (2019). Фейковые новости в Твиттере во время президентских выборов в США в 2016 году. Наука , 363 (6425), 374–378. https://doi.org/10.1126/science.aau2706

Гро М., Шанкаранараянан А., Липпман А. и Пикард Р. (2022). Человеческое обнаружение политических дипфейков в стенограммах, аудио и видео. arXiv. https://doi.org/10.48550/arXiv.2202.12883

Угадай, AM (2021). (Почти) всего в меру: новые данные о диетах американцев в интернет-СМИ. Американский журнал политической науки , 65 (4), 1007–1022. https://doi.org/10.1111/ajps.12589

Хабгуд-Кут, Дж. (2023). Дипфейки и эпистемический апокалипсис. Синтез , 201 (103). https://doi.org/10.1007/s11229-023-04097-3

Хакенбург К. и Маргеттс Х. (2023). Оценка убедительного влияния политического микротаргетинга с помощью больших языковых моделей. ОСФ. https://doi.org/10.31219/osf.io/wnt8b

Хамелеерс, М. (2023). (Не)преднамеренные последствия подчеркивания угроз дезинформации. СМИ и коммуникация , 11 (2), 5–14. https://doi.org/10.17645/mac.v11i2.6301

Хэнли, Х.В., и Дурумерик, З. (2023). Машинные СМИ: мониторинг распространения машинных статей на дезинформационных и основных новостных сайтах. arXiv. https://doi.org/10.48550/arXiv.2305.09820

Сюй, Т., и Томпсон, С.А. (8 февраля 2023 г.). Эксперты предупреждают, что чат-боты с искусственным интеллектом могут распространять дезинформацию. Нью-Йорк Таймс. https://www.nytimes.com/2023/02/08/technology/ai-chatbots-disinformation.html

Юнгхерр А. и Шредер Р. (2021a). Цифровые трансформации общественной арены . Издательство Кембриджского университета.

Юнгхерр А. и Шредер Р. (2021b). Дезинформация и структурные преобразования общественной арены: решение реальных проблем демократии. Социальные сети + Общество , 7 (1). https://doi.org/10.1177/2056305121988928

Юнгхерр А., Риверо Г. и Гайо-Авелло Д. (2020). Переоснащение политики: как цифровые медиа формируют демократию . Издательство Кембриджского университета.

Юргенсон, Н. (2019). Социальное фото: О фотографии и социальных сетях . Версо.

Калун И. и Рамани А. (31 августа 2023 г.). ИИ изменит американские выборы, но не очевидным образом. Экономист . https://www.economist.com/united-states/2023/08/31/ai-will-change-american-elections-but-not-in-the-obvious-way

Капур С. и Нараянан А. (2023). Как подготовиться к потоку генеративного ИИ в социальных сетях. Институт Первой поправки Найта, Колумбийский университет. https://knightcolumbia.org/content/how-to-prepare-for-the-deluge-of-generative-ai-on-social-media

Кирк, Х.Р., Виджен, Б., Реттгер, П. и Хейл, С.А. (2023). Персонализация в пределах границ: таксономия рисков и политическая основа для согласования больших языковых моделей с персонализированной обратной связью. arXiv. https://doi.org/10.48550/arXiv.2303.05453

Маркус, Г. (8 февраля 2023 г.). Момент из Парка Юрского периода от ИИ. Коммуникации АКМ. https://cacm.acm.org/blogs/blog-cacm/267674-ais-jurassic-park-moment/fulltext

Мерсье, Х. (2020). Не рождены вчера: наука о том, кому мы доверяем и во что верим . Издательство Принстонского университета.

Мертон, РК (1973). Социология науки: Теоретические и эмпирические исследования . Издательство Чикагского университета.

Мец, К. (1 мая 2023 г.). «Крестный отец искусственного интеллекта» покидает Google и предупреждает о грядущей опасности. Нью-Йорк Таймс. https://www.nytimes.com/2023/05/01/technology/ai-google-chatbot-engineer-quits-hinton

Мецгер, MJ (2007). Осмысление доверия в Интернете: модели оценки онлайн-информации и рекомендации для будущих исследований. Журнал Американского общества информационных наук и технологий , 58 (13), 2078–2091. https://doi.org/10.1002/asi.20672

Мотта М., Хван Дж. и Стекула Д. (2023). То, что идет вниз, должно подняться? Поведение при поиске дезинформации, связанной с пандемией, во время незапланированного отключения Facebook. Общение о здоровье . https://doi.org/10.1080/10410236.2023.2254583

Ньюпорт, К. (13 апреля 2023 г.). Какой ум у ChatGPT? Житель Нью-Йорка . https://www.newyorker.com/science/annals-of-artificial-intelligence/what-kind-of-mind-does-chatgpt-have

Ордонес В., Данн Т. и Нолл Э. (19 мая 2023 г.). Генеральный директор OpenAI Сэм Альтман говорит, что ИИ изменит общество, признает риски: «Немного боюсь этого». Новости Эй-Би-Си. https://abcnews.go.com/Technology/openai-ceo-sam-altman-ai-reshape-society-acknowledges/story?id=97897122

Орбен, А. (2020). Сизифов цикл технологической паники. Перспективы психологической науки , 15 (5), 1143–1157. https://doi.org/10.1177/1745691620919372

Осмундсен М., Бор А., Вальструп П.Б., Бехманн А. и Петерсен М.Б. (2021). Партийная поляризация является основной психологической мотивацией распространения политических фейковых новостей в Твиттере. Американский обзор политической науки , 115 (3), 999–1015. https://doi.org/10.1017/S0003055421000290

Пэрис Б. и Донован Дж. (2019). Дипфейки и дешевые фейки. Манипулирование аудио- и визуальными доказательствами. Институт исследований данных и общества. https://datasociety.net/library/deepfakes-and-cheap-fakes/

Пастернак А. (17 марта 2023 г.). Дипфейки становятся умнее благодаря GPT. ФастКомпани. https://www.fastcompany.com/90853542/deepfakes-getting-smarter-thanks-to-gpt

Скотт, Л. (5 сентября 2023 г.). Мир сталкивается с «техническим армагедоном», говорит Мария Ресса . Голос Америки. https://www.voanews.com/a/world-faces-tech-enabled-armageddon-maria-ressa-says-/7256196.html

Шах К. и Бендер Э. (2023). Представление о системах доступа к информации: что нужно для хороших инструментов и здорового Интернета? Неопубликованная рукопись. https://faculty.washington.edu/ebender/papers/Envisioning_IAS_preprint.pdf

Шифф, К.Дж., Шифф, Д.С., и Буэно, Н. (11 мая 2022 г.). Дивиденд лжеца: могут ли политики использовать дипфейки и фейковые новости, чтобы избежать ответственности? СоцАрXiv. https://doi.org/10.31235/osf.io/q6mwn

Сильверман, К. (ред.). (2014). Справочник по проверке: полное руководство по поиску источников информации в эпоху цифровых технологий для экстренного покрытия . Европейский центр журналистики. https://datajournalism.com/read/handbook/verification-3

Саймон, FM (2019). «Мы обеспечиваем демократию»: изучение перспектив индустрии анализа политических данных. Информационное общество , 53 (3), 158–169. https://doi.org/10.1080/01972243.2019.1582570

Саймон, FM, и Камарго, CQ (2021). Вскрытие метафоры: истоки, использование и слепые пятна «инфодемии». Новые медиа и общество, 25 (8), 2219–2240. https://doi.org/10.1177/14614448211031908

Таппин, Б.М., Виттенберг, К., Хьюитт, Л.Б., Беринский, А.Дж., и Рэнд, Д.Г. (2023). Количественная оценка потенциальной убедительной отдачи от политического микротаргетинга. Труды Национальной академии наук , 120 (25), e2216261120. https://doi.org/10.1073/pnas.2216261120

Тейлор, Г. (2014). Недостаток внимания к среде изобилия. Экономическая перспектива. В книге М. Грэма и У.Х. Даттона (ред.), Общество и Интернет (стр. 257–271). Издательство Оксфордского университета.

Тику, С. (21 июня 2022 г.). Изображения искусственного интеллекта, которые выглядят как настоящие фотографии, находятся здесь. Вашингтон Пост . https://www.washingtonpost.com/technology/interactive/2022/artificial-intelligence-images-dall-e/

Такер, Дж. (14 июля 2023 г.). ИИ может создать кошмар дезинформации на выборах 2023 года. Холм . https://thehill.com/opinion/4096006-ai-could-create-a-disinformation-nightmare-in-the-2024-election/

Вейкманн Т. и Лехелер С. (2023). Разрушение ажиотажа: понимание последствий дипфейков для сети акторов, проверяющих факты. Цифровая журналистика . https://doi.org/10.1080/21670811.2023.2194665

Загни Г. и Канетта Т. (5 апреля 2023 г.). Генеративный ИИ знаменует начало новой эры дезинформации. Европейская обсерватория цифровых медиа. https://edmo.eu/2023/04/05/generative-ai-marks-the-beginning-of-a-new-era-for-disinformation/

Заруали Б., Доббер Т., Де Пау Г. и де Вриз К. (2022). Использование алгоритма профилирования личности для исследования политического микротаргетинга: оценка эффекта убеждения индивидуальной рекламы в социальных сетях. Коммуникационные исследования, 49 (8), 1066–1091. https://doi.org/10.1177/0093650220961965