Opus 4.6 коренным образом изменил свой алгоритм работы . А это, в свою очередь, меняет подход к разработке приложений с его использованием.

- Вкратце:

- Смена парадигмы: адаптивное мышление

- Регулятор усилий

- Важные цифры

- 1M Контекст и компактизация: история долгоиграющего агента

- Сжатие контекста: Бесконечный Агент

- Что означает Opus 4.6 для Agentic Systems

- Улучшения на уровне модели (доступны везде)

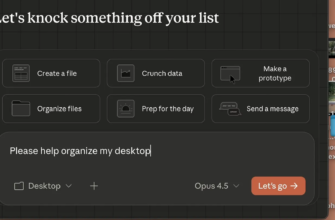

- На уровне продукта: Команды агентов в Claude Code

- Быстрый режим для циклов агентов

- Контрольный список для миграции: Преодоление трудностей на пути к переменам

- Когда НЕ следует использовать Opus 4.6

- Благодарности и дополнительная литература

Вкратце:

Если у вас мало времени, вот что действительно важно:

- Адаптивное мышление заменяет расширенное мышление. Теперь модель сама решает, когда и насколько глубоко нужно рассуждать. Вы перестаёте гадать

budget_tokens. Это самое значительное архитектурное изменение. - Четыре уровня сложности обеспечивают реальный контроль затрат: низкий, средний, высокий (по умолчанию) и максимальный. Одна и та же модель, разные точки соотношения цены и качества. Маршрутизация по сложности, а не по модели.

- Окно контекста в 1 миллион токенов действительно работает. Точность поиска иголки в стоге сена составляет 76% при 1 миллионе токенов, по сравнению с 18,5% для Sonnet 4.5. Проблема устаревания контекста фактически решена.

- Сжатие контекста позволяет создавать неограниченное количество сессий агентов. Серверное суммирование означает, что ваши агенты, работающие длительное время, перестанут сталкиваться с ограничениями контекста.

- Внесение критических изменений может иметь негативные последствия. Функция предварительного заполнения сообщений помощником возвращает ошибку 400.

budget_tokensЭта функция устарела. Контрольный список миграции находится в последних разделах. - Честное замечание: Opus 4.6 слишком тщательно анализирует простые задачи, GPT-5.2 всё ещё немного превосходит его по уровню логического мышления, необходимого для аспирантов, а Gemini 3 Pro имеет вдвое большее контекстное окно при 2 миллионах токенов. Знайте, когда следует использовать что-то другое.

Смена парадигмы: адаптивное мышление

Каждый релиз модели сопровождается увеличением показателей. В Opus 4.6 они тоже есть, и мы к ним ещё вернёмся. Но изменение, которое действительно перекроит подход к проектированию приложений на основе Claude, — это не результат бенчмарка. Это фундаментальный сдвиг в том, как модель обрабатывает логические рассуждения.

Старый мир был бинарным. С появлением расширенного мышления у вас было два варианта: думать или не думать. Когда вы включали его, вам нужно было установить budget_tokensжесткий потолок на количество токенов, которые модель могла потратить на рассуждения, прежде чем дать ответ. Если установить слишком низкий потолок, модель сокращала свои рассуждения на сложных задачах. Если установить слишком высокий, вы тратили токены на вопросы, которые не требовали глубокого обдумывания. По сути, вы угадывали сложность каждой задачи еще до того, как модель ее распознала .

Этого больше нет.

Адаптивное мышление позволяет модели сначала оценить сложность, а затем решить, сколько рассуждений требуется для решения задачи. Простая классификация? Она полностью пропускает этап мышления и реагирует быстро. Многоэтапная задача отладки большого объема кода? Она глубоко анализирует ситуацию, чередуя рассуждения между вызовами инструментов без необходимости что-либо настраивать.

Вот как выглядит миграция на практике:

# До (Opus 4.5) - вы сами догадываетесь о бюджете мышления

response = client.messages.create(

model= "claude-opus-4-5-20251101" ,

max_tokens=16000,

thinking={

"type" : "enabled" ,

"budget_tokens" : 10000 # Надеюсь, этого достаточно?

},

messages=[{ "role" : "user" , "content" : prompt}]

)

# После (Opus 4.6) - модель принимает решение

response = client.messages.create(

model= "claude-opus-4-6" ,

max_tokens=16000,

thinking={

"type" : "adaptive" # Клод обрабатывает остальное

},

messages=[{ "role" : "user" , "content" : prompt}]

)

Чисто. Но настоящая мощь заключается в effortпараметрах, которые представляют собой не переключатель, а регулятор.

Регулятор усилий

В Opus 4.6 введены четыре уровня усилий, которые регулируют интенсивность использования токенов моделью для рассуждений. Представьте это как формирование организационной культуры для вашего ИИ: «действуй быстро и выпускай» против «тщательно обдумывай и делай все правильно».

Низкие затраты усилий позволяют полностью отказаться от глубокого анализа простых задач. Ваш маршрутный агент, классифицирующий входящие запросы? Ему не требуется глубокого логического мышления. Низкие затраты усилий обеспечивают быстроту и экономичность.

Модель средней сложности — ваш сбалансированный «рабочий конь». Стандартные запросы, умеренная сложность. Модель думает, когда это полезно, и пропускает, когда это не нужно.

Высокая интенсивность работы — это норма, и на то есть веские причины. Клод почти всегда здесь задействует мыслительный процесс. Именно здесь вам понадобятся большинство производственных нагрузок, требующих надежности.

Режим «Максимальные усилия» — это новая функция, эксклюзивная для Opus 4.6. Нет ограничений на глубину рассуждений. Это ваш режим «не жалеть средств» для решения самых сложных задач: комплексная отладка огромных кодовых баз, новые исследовательские вопросы, многоэтапный финансовый анализ, где точность имеет первостепенное значение. Он будет медленнее. Он будет стоить дороже. Но он позволяет достичь такой глубины рассуждений, которой не может достичь ни один другой режим.

# Маршрутизация усилий в зависимости от сложности задачи - одна и та же модель, разный показатель соотношения цены и производительности

response = client.messages.create (

model= " claude-opus-4-6" ,

max_tokens= 16000 ,

thinking={ "type" : "adaptive" },

output_config={

"effort" : "low" # или "medium" , "high" , "max"

},

messages=[{ "role" : "user" , "content" : prompt}]

)

Вот архитектурная особенность, которую упускает большинство обзоров: уровни сложности позволяют заменить маршрутизацию на основе нескольких моделей маршрутизацией на основе одной модели. Вместо того чтобы поддерживать отдельные конвейеры для Haiku (простые задачи), Sonnet (средние задачи) и Opus (сложные задачи), вы можете маршрутизировать все через Opus 4.6 с разными уровнями сложности. Ваша логика маршрутизации становится проще. Разработка подсказок остается согласованной. Ваша поверхность оценки сужается.

Всегда ли это правильное решение? Нет. Haiku и Sonnet по-прежнему дешевле в пересчете на токен, и для действительно простых задач вы платите по ценам Opus за токены класса Opus даже при низких затратах усилий. Но для команд, которые утопают в сложности маршрутизации моделей, уровни усилий предлагают существенное упрощение.

Ещё один важный для производства момент: адаптивное мышление поддаётся подсказкам. Если модель думает больше или меньше, чем вам нужно, вы можете направлять её с помощью системных подсказок. Например, фраза «Расширенное мышление увеличивает задержку и должно использоваться только тогда, когда это существенно улучшит ваш ответ» подтолкнет модель к уменьшению количества размышлений. Это обеспечивает мягкий уровень контроля поверх параметра «жёсткие усилия».

Теперь интерлидерное мышление — когда модель рассуждает между вызовами инструментов в рабочих процессах агентов — работает автоматически. Не требуется бета-заголовок. Не нужна специальная настройка. Если вы используете адаптивное мышление, интерлидерное мышление просто работает. Для тех, кто боролся с interleaved-thinking-2025-05-14бета-флагом, это на одну проблему меньше.

Важные цифры

При запуске каждой модели сопровождается множеством тестов производительности. Большинство из них не повлияют на ваши архитектурные решения. Вот те, которые повлияют.

Программирование с использованием агентных алгоритмов: Opus 4.6 немного опережает конкурентов. Terminal-Bench 2.0 измеряет реальную работу по программированию с использованием агентных алгоритмов — планирование, выполнение команд оболочки, отладку файлов. Opus 4.6 набирает 65,4%, что выше показателя Opus 4.5 (59,8%). Это существенный скачок в семействе Claude. Но GPT-5.2 с Codex CLI показывает результат 64,7%, отставая всего на 0,7 балла. Если вы выбираете между Claude и OpenAI исключительно по результатам тестов программирования, разрыв слишком мал, чтобы быть решающим. Выбирайте, исходя из инструментов, цены и соответствия рабочему процессу.

Революционный подход к решению задач: настоящий сюрприз. ARC AGI 2 проверяет способность модели к рассуждениям на задачах, с которыми она никогда раньше не сталкивалась — без сопоставления с обучающими данными, без заученных решений. Opus 4.6 показывает результат 68,8%, что почти вдвое превышает показатель Opus 4.5 (37,6%) и значительно опережает GPT-5.2 Pro (54,2%). Это бенчмарк, который лучше всего показывает, способна ли модель справляться с действительно новыми задачами в вашем коде или предметной области. Скачок здесь не постепенный, а поколенческий.

Работа с интеллектуальным трудом: корпоративный сигнал. GDPval-AA оценивает экономически ценную работу в финансовой, юридической и профессиональной сферах — например, презентации, электронные таблицы, финансовый анализ, юридические документы. Opus 4.6 достигает 1606 баллов по шкале Эло, опережая GPT-5.2 на 144 балла и Opus 4.5 на 190. В прямом сравнении это означает, что Opus 4.6 обеспечивает более высокое качество результатов примерно в 70% случаев. Если ваша команда использует Claude для чего-либо, кроме кода — исследований, анализа, создания документов — этот показатель имеет значение.

Поиск в длинном контексте: средство для устранения «порчи контекста». MRCR v2 скрывает 8 фактов внутри 1 миллиона текстовых токенов и просит модель найти их. Opus 4.6 правильно находит 76% информации. Sonnet 4.5 — 18,5%. Gemini 3 Pro, у которого контекстное окно в 2 миллиона слов, набирает 26,3%. Окно полезно только в том случае, если модель действительно может обращать внимание на то, что находится внутри него. Opus 4.6 может.

Где произошел регресс или застой. Показатель SWE-bench Verified фактически снизился с 80,9% у Opus 4.5 до 80,8%. Незначительное снижение, вероятно, в пределах допустимого отклонения, но стоит отметить: антропогенная оптимизация в других областях. GPT-5.2 по-прежнему лидирует в GPQA Diamond по уровню научного мышления на уровне аспирантуры. Gemini 3 Pro выигрывает в MMMU Pro по визуальному мышлению и предлагает контекстное окно с 2 миллионами токенов — вдвое больше, чем у Opus 4.6. Ни одна модель не выигрывает везде. Вопрос в том, какие преимущества важны для вашей рабочей нагрузки.

Диагностика программного обеспечения: неожиданный успех. OpenRCA измеряет способность модели диагностировать реальные сбои в программном обеспечении. Opus 4.6 показывает результат 34,9%, что выше, чем 26,9% у Opus 4.5 и 12,9% у Sonnet 4.5. Если вы разрабатываете системы реагирования на инциденты с использованием ИИ или отлаживаете конвейеры, это 30-процентное улучшение по сравнению с предыдущим поколением более актуально, чем любой тест производительности кода.

1M Контекст и компактизация: история долгоиграющего агента

Большие контекстные окна уже более года являются неотъемлемой частью маркетинга. Проблема заключалась не в размере окна, а в том, что происходило внутри него. Модели принимали 200 000 токенов, но незаметно теряли информацию, скрытую за отметкой в 50 000. Инженеры называли это «контекстной деградацией», и это превращало большие контекстные окна из преимущества в недостаток. Вы вставляли документы, получали уверенные ответы и упускали из виду, что модель незаметно отбросила критически важное ограничение со страницы 47.

В Opus 4.6 ситуация меняется таким образом, что это действительно отражается на результатах бенчмарков. В MRCR v2, где скрываются 8 конкретных фактов среди 1 миллиона текстовых токенов, и модели предлагается их извлечь, Opus 4.6 набирает 76%. Sonnet 4.5 набирает 18,5%. Gemini 3 Pro — с контекстным окном размером 2 миллиона — набирает 26,3%. Окно полезно только в том случае, если модель может действительно обращать внимание на то, что находится внутри него. Opus 4.6 может.

Практические последствия важнее, чем результаты тестирования. Если вы работаете с большими кодовыми базами, многодокументными исследованиями или нормативными документами, занимающими сотни страниц, вам больше не нужно агрессивно разбивать и извлекать данные на части. Вы можете загружать весь исходный материал и быть уверенными, что модель отслеживает детали по всему объему. Тем не менее, контекст 1M находится в стадии бета-тестирования, и существует ценовая надбавка: при объеме более 200 000 токенов стоимость ввода удваивается до 10 долларов за MTok, а стоимость вывода возрастает до 37,50 долларов за MTok.

Вопрос стоимости: 1 миллион контекстов против RAG. Если у вас уже используется конвейер RAG, стоит ли его демонтировать и перенести все в контекст? Вероятно, нет. RAG по-прежнему выигрывает по стоимости для больших, относительно статичных корпусов — вы платите за встраивание один раз, а за извлечение — за каждый запрос. Полный контекст выигрывает, когда вам нужно, чтобы модель рассуждала по всему набору документов, а не только извлекала из него информацию. 500-страничный юридический договор, где пункты ссылаются друг на друга в разных разделах? Полный контекст. База знаний с 10 000 статей поддержки, где любой отдельный запрос затрагивает 3–5 из них? RAG по-прежнему дешевле и практичнее.

Простые расчеты: запрос на 1 миллион токенов по премиум-цене обходится примерно в 10 долларов за запрос только на ввод. Если ваш агент совершает 50 звонков в день с таким контекстом, то затраты составят 500 долларов в день только на ввод токенов. Сравните это с настройкой RAG, где вы получаете 5000-10000 токенов за запрос по стандартной цене — примерно 0,05-0,10 доллара за звонок, или 2,50-5,00 долларов в день за те же 50 запросов. Разница составляет 100 раз. Полный контекст — это высокоточный инструмент для выполнения важных задач, а не замена инфраструктуре получения данных.

Сжатие контекста: Бесконечный Агент

Более революционной функцией может стать компактизация, которая решает совершенно другую проблему. Агенты, работающие длительное время — те, которые отлаживают код в течение часа или управляют многоэтапным исследовательским процессом — неизбежно достигают предела контекста. До сих пор приходилось создавать собственную логику усечения, решать, что сохранить, а что удалить, и надеяться, что ничего важного не потеряешь.

Сжатие данных обрабатывает это на стороне сервера. Когда разговор приближается к настраиваемому пороговому значению, API автоматически суммирует более старые части разговора и заменяет их сжатой версией. Ваш агент продолжает работать. Никаких сбоев. Никакого пользовательского кода. Никакой потери контекста (точнее, суммированного контекста — это компромисс, который вы должны понимать).

# Включить компактирование для длительно работающих агентов

response = client.messages.create (

model = "claude-opus-4-6" ,

max_tokens = 16000 ,

thinking = { "type" : "adaptive" } ,

context = {

"compaction" : {

"enabled" : True ,

"trigger_tokens" : 150000

}

} ,

messages = conversation_history

)

Компромисс реален: обобщенный контекст теряет детализацию. Если вашему агенту необходимо сослаться на конкретное имя переменной из сообщений, которым уже 200, то сжатие может это скрыть. Для большинства рабочих процессов агентов — где наиболее важен недавний контекст, а более старый контекст служит фоном — этот компромисс превосходен. Для рабочих процессов, требующих точного воспроизведения отдаленных деталей, вам потребуется дополнить данные внешней памятью.

В сочетании с максимальным количеством выходных токенов в 128 000 (удвоенным с 64 000), Opus 4.6 — первая модель, которая может реально поддерживать многочасовые агентские сессии без архитектурных ухищрений. Адаптивное мышление позволяет поддерживать разумные затраты, избегая излишнего анализа простых вызовов инструментов в рамках этих сессий. Сжатие поддерживает диалог. Окно в 1 миллион токенов дает вам пространство для маневра.

Что означает Opus 4.6 для Agentic Systems

Возникает соблазн смешать возможности модели с продуктами, построенными на её основе. Давайте разделим эти два понятия, поскольку это различие имеет значение для проектирования архитектуры.

Улучшения на уровне модели (доступны везде)

Независимо от того, используете ли вы Claude Code, Cursor, Windsurf, собственную интеграцию API или любой другой инструмент, модель Opus 4.6 предлагает ряд улучшений в работе агентов, которые проявляются везде, где вы ее развертываете:

Улучшенное планирование и декомпозиция. Opus 4.6 разбивает сложные задачи на подзадачи более надежно, чем его предшественник. Он фокусируется на самых сложных частях в первую очередь, быстро переходит к простым и более взвешенно обрабатывает неоднозначные требования. Внутренние тесты Anthropic показывают, что модель «думает глубже и тщательнее, пересматривая свои рассуждения, прежде чем прийти к решению». На практике это означает меньшее количество потраченных впустую циклов на неправильно понятые инструкции.

Устойчивая концентрация внимания в течение длительных сессий. На тесте Vending-Bench 2, измеряющем долговременную согласованность в течение продолжительных взаимодействий, Opus 4.6 зарабатывает на 3050 долларов больше, чем Opus 4.5. Модель поддерживает продуктивную производительность в течение длительных сессий без ухудшения качества, которое было характерно для более ранних версий. В сочетании с компактизацией можно создавать агентов, которые остаются сосредоточенными на задаче в течение нескольких часов.

Самокоррекция во время проверки кода. Одно из наиболее практичных улучшений: модель чаще обнаруживает собственные ошибки. Более ранние модели Claude генерировали код, проверяли его и пропускали очевидные проблемы. Opus 4.6 заметно лучше выявляет ошибки, состояния гонки и граничные случаи в только что написанном коде. Это снижает нагрузку на человека при проверке кода в рабочих процессах разработки с использованием ИИ.

Адаптивный подход к управлению усилиями естественным образом вписывается в циклы работы агентов. В типичном цикле работы агентов большинство вызовов инструментов просты — чтение файла, выполнение команды, отправка запроса к API. Иногда агент сталкивается с действительно сложным этапом логического мышления. Адаптивное мышление означает, что Opus 4.6 не тратит максимальное количество токенов логического мышления на каждый вызов инструмента. Он сохраняет глубокое мышление для моментов, когда это необходимо. Это делает длительные циклы работы агентов значительно дешевле без ущерба для качества на сложных этапах.

На уровне продукта: Команды агентов в Claude Code

В собственном продукте Anthropic для реализации работы с несколькими агентами используются «команды агентов» в Claude Code, в настоящее время находящиеся на стадии предварительного тестирования. Важно понимать, что это функция продукта , а не возможность модели. Cursor, Windsurf, GitHub Copilot Agent HQ и Codex CLI имеют свои собственные шаблоны работы с несколькими агентами.

В Claude Code команды агентов работают посредством оркестровки на естественном языке. Вы описываете структуру команды, а инструмент занимается созданием и координацией групп:

> Создайте команду агентов для проверки этого кода.

Назначьте 3 члена команды:

1. "security-reviewer" — сосредоточьтесь на процессах аутентификации в src/auth/; 2.

" perf-reviewer" — проанализируйте наиболее часто используемые пути и запросы к базе данных ;

3. "test-reviewer" — оцените пробелы в покрытии тестов. Пусть

они поделятся своими выводами и бросят друг другу вызов .

Ведущая сессия координирует действия, запускает независимые сессии коллег (каждая со своим контекстным окном) и управляет общим списком задач. Коллеги общаются друг с другом напрямую — в отличие от субагентов, которые только отчитываются перед вызывающей стороной. Вы можете взаимодействовать с любым коллегой через Shift+Up/Downразделенные окна tmux.

Стоит знать о практических ограничениях: участники команды не наследуют историю переписки лидера, конфликты файлов между участниками команды являются основной причиной сбоев, а стоимость токенов возрастает примерно в 5 раз по сравнению с одной сессией. Сегодня оптимальным вариантом является параллельная работа с большим объемом чтения — проверка кода, исследования, анализ — а не параллельная реализация с большим объемом записи, где несколько агентов редактируют одни и те же файлы.

Быстрый режим для циклов агентов

Ещё одна важная функция на уровне API: быстрый режим обеспечивает до 2,5 раз более быструю генерацию выходных токенов по премиум-цене (30/150 долларов за MTok). Та же модель, тот же интеллект, просто более быстрое выполнение. Для циклов работы агентов, где задержка увеличивается на протяжении сотен последовательных вызовов инструментов, это может стать разницей между задачей, выполняемой за 10 минут, и задачей, выполняемой за 25 минут. Оправдывает ли это увеличение генерации выходных токенов в 6 раз, зависит от ваших требований к пропускной способности.

Контрольный список для миграции: Преодоление трудностей на пути к переменам

Если вы сейчас используете Opus 4.5 в рабочей среде, вот что сломается при переходе на эту версию claude-opus-4-6:

Предварительное заполнение устарело. Предварительное заполнение сообщений помощника — когда вы начинаете ответ Клода с определенного текста — возвращает ошибку 400 в Opus 4.6. Нет предупреждения об устаревании, нет корректного резервного варианта. Если ваши подсказки полагаются на предварительное заполнение для управления форматом вывода, вам необходимо перейти к структурированному выводу или системным инструкциям подсказок, прежде чем менять модель.

# До (Opus 4.5) - предварительное заполнение работало

messages =[

{ "role" : "user" , "content" : "Classify this ticket" },

{ "role" : "assistant" , "content" : '{"category": ' } # Предварительное заполнение

]

# После (Opus 4.6) - используйте структурированные выходные данные вместо

response = client.messages.create(

model= "claude-opus-4-6" ,

max_tokens=1000,

output_config={

"format" : {

"type" : "json_schema" ,

"schema" : {

"type" : "object" ,

"properties" : {

"category" : { "type" : "string" }

}

}

}

},

messages=[{ "role" : "user" , "content" : "Classify this ticket" }]

)

Эта конфигурация, по-видимому, устарела. thinking: {type: "enabled", budget_tokens: N} Она по-прежнему работает, но устарела и будет удалена. Перейдите на другую конфигурацию thinking: {type: "adaptive"}с этим effortпараметром.

Формат вывода изменен. output_format Теперь он такой-то output_config.format. Старый параметр по-прежнему работает, но устарел.

# Перед

выводом output_format ={ "type" : "json_schema" , "schema" : {...}}

# После

output_config ={ "format" : { "type" : "json_schema" , "schema" : {...}}}

Заголовки бета-версии очищены. В Opus 4.6 заголовок interleaved-thinking-2025-05-14бета-версии игнорируется. Адаптивное мышление автоматически включает чередование задач. Удалите заголовок, чтобы ваши запросы оставались чистыми.

Идентификатор модели упрощен. Идентификатор claude-opus-4-6— без суффикса даты. Это отступление от предыдущей системы именования ( claude-opus-4-5-20251101).

Различия в экранировании JSON. Opus 4.6 может воспроизводить несколько иное экранирование строк JSON в аргументах вызова инструмента (экранирование в Unicode, обработка косой черты). Стандартные парсеры справляются с этим без проблем. Если вы анализируете входные данные вызова инструмента как необработанные строки, а не используете json.loads()или JSON.parse(), протестируйте свою логику анализа.

Доступна обработка данных только для США. Если местонахождение данных имеет значение, теперь вы можете запросить обработку данных только для США с inference_geoпараметром по цене токена 1,1x.

Когда НЕ следует использовать Opus 4.6

Завоевание доверия означает честное признание того, что тот или иной инструмент не является правильным выбором. Вот где Opus 4.6 оказывается избыточным или уступает конкурентам:

Простые задачи классификации и маршрутизации. Opus 4.6 будет их чрезмерно усложнять. Даже при минимальных усилиях вы платите за токен по ценам уровня Opus. Если ваша задача — «классифицировать этот запрос в службу поддержки по 5 категориям», Haiku или Sonnet справятся с ней быстрее, дешевле и с той же точностью. Оставьте Opus для задач, которые действительно выигрывают от глубокого анализа.

Большие объемы данных, низкая сложность. При стоимости 25 долларов за МТок на выходе затраты быстро накапливаются при обработке тысяч простых запросов. Конвейер обработки 100 000 запросов в день по 500 токенов на выходе каждый будет стоить примерно 1250 долларов в день на Opus против около 100 долларов в день на Sonnet 4.5. Это в 12 раз больше для задач, не требующих применения передовых методов.

Задачи визуального мышления. Gemini 3 Pro по-прежнему превосходит MMMU Pro в плане визуального восприятия. Если ваше приложение требует сложного анализа изображений, понимания структуры документов или визуального мышления, сравните результаты с Gemini, прежде чем принимать решение об использовании Opus.

Когда вам требуется более 2 миллионов контекстных данных, Gemini 3 Pro предлагает вдвое большее окно контекста. Если вашей рабочей нагрузке действительно требуется более 1 миллиона контекстных токенов, и вы не можете использовать RAG для уменьшения окна, Gemini — это практичный выбор.

Прототипирование с учетом затрат. При итеративном улучшении условий и архитектуры сжигание токенов Opus при каждом тестовом запуске обходится дорого. Создавайте прототипы на Sonnet 4.5, а затем проверяйте их на Opus, когда ваш подход стабилизируется. Это особенно важно на ранних этапах разработки, когда вы часто вносите изменения.

Если ваш код в значительной степени полагается на предварительное заполнение, переход от предварительного заполнения к структурированному выводу может оказаться нетривиальной задачей для некоторых архитектур. Если предварительное заполнение глубоко интегрировано в вашу систему, оцените трудозатраты на переход, прежде чем переключаться. Возможно, это не стоит того ради улучшения результатов SWE-bench на 0,1%.

Благодарности и дополнительная литература

- Представляем Claude Opus 4.6 — официальное объявление от Anthropic с полными данными бенчмарка и отзывами партнеров.

- Что нового в Claude 4.6 — Официальная документация по API, охватывающая адаптивное мышление, сжатие, быстрый режим и изменения, нарушающие обратную совместимость.

- Документация по адаптивному мышлению — Подробный анализ настройки адаптивного мышления и возможности получения подсказок.

- Документация по параметрам усилий — Полное руководство по уровням усилий и их взаимодействию с расширенным мышлением.

- Создание компилятора C с помощью команд агентов Клода — пример из практики, когда 16 агентов написали 100 000 строк кода на Rust, с практическими уроками по координации действий нескольких агентов.

- Системная карта Claude Opus 4.6 — Подробные оценки безопасности, оценки возможностей и методические указания.