Оригинальное название: Countering Misinformation

Evidence, Knowledge Gaps, and Implications of Current Interventions

Доказательства, пробелы в знаниях и последствия текущих вмешательств

Разработка эффективных мер противодействия дезинформации является неотложной задачей, но она также сопряжена с концептуальными, эмпирическими и практическими трудностями, усугубляемыми тем фактом, что исследования дезинформации находятся в зачаточном состоянии. Этот документ предоставляет исследователям и политикам обзор того, какие вмешательства на индивидуальном уровне могут повлиять на распространение, восприимчивость к дезинформации или влияние дезинформации. Мы рассматриваем доказательства эффективности четырех категорий вмешательств: усиление (психологическая прививка, критическое мышление, медийная и информационная грамотность); подталкивание (подталкивание к точности и подталкивание к социальным нормам); разоблачение (проверка фактов); и автоматическая маркировка контента. В каждой области мы оцениваем эмпирические данные, ключевые пробелы в знаниях и практические соображения.

Дезинформация является серьезной социальной проблемой, которая становится все более популярной темой среди исследователей, политиков, журналистов и широкой общественности. Мы определяем дезинформацию как любую ложную или вводящую в заблуждение информацию. Последнее не обязательно должно быть фактически неверным, но вместо этого может искажать факты, быть лишенным соответствующего контекста или использовать логическую ошибку ( Roozenbeek & van der Linden, 2022 ). В онлайн-среде дезинформация может появляться в виде новостей и контента в социальных сетях и может распространяться преднамеренно, случайно или без злого умысла. 1

Распространение дезинформации связано с возрождением болезней, которые можно предотвратить с помощью вакцин, подрывом политических норм и усилением социальных разногласий ( Au et al., 2021 ; Azzimonti & Fernandes, 2018 ; Loomba et al., 2021 ). В рамках каждой предметной области существуют поразительные пробелы в понимании этих вопросов общественностью и согласованные усилия по манипулированию общественным мнением ( Lewandowsky et al., 2017 ). Поэтому распространенность дезинформации, особенно в Интернете, все чаще рассматривается как кризис, требующий срочных действий ( Farkas & Schou, 2020 ).

Однако исследования того, как дезинформация распространяется от человека к человеку ( Cinelli et al., 2020; Del Vicario et al., 2016 ; Zollo et al., 2015 ), детерминант восприимчивости к дезинформации ( Ecker, Lewandowsky et al., 2022 ; Pennycook & Rand, 2019 ; Roozenbeek , Maertens, et al., 2022 ; Van Bavel et al., 2021), а также разработка и тестирование мер по противодействию дезинформации (Cook et al., 2017; Guess et al., 2020 ; Lee , 2018 ) быстро развиваются , но остаются в зачаточном состоянии. Сеть науки ( https://webofscience.com/) поиск «дезинформации» показывает, что популярность этой темы среди исследователей резко возросла только после президентских выборов в США в 2016 г., увеличившись с 43 академических публикаций в год в 2000 г. до 231 в 2015 г. и до 1925 в 2021 г.

Поскольку политикам, технологическим компаниям, поставщикам новостей, преподавателям и другим субъектам поручено разработать меры для решения этой проблемы, крайне важно оценить доказательную базу для существующих типов вмешательств по борьбе с дезинформацией. Однако существуют пробелы в знаниях об их влиянии, воздействии и эффективности. Эти пробелы в знаниях усугубляются тем фактом, что большая часть исследований сосредоточена в Европе и Северной Америке, а также более широкими проблемами исследования дезинформации в Интернете ( Badrithan, 2021 ; van der Linden, 2022 ). Например, существуют концептуальные проблемы, связанные с определением проблемы ( Freelon & Wells, 2020 ; Kapantai et al., 2021 ; Traberg, 2022).), практические проблемы, возникающие из-за масштабов распространения онлайн-контента ( Traberg et al., 2022 ), и этические проблемы, связанные с вмешательством в законную свободу слова ( Nunez, 2020 ).

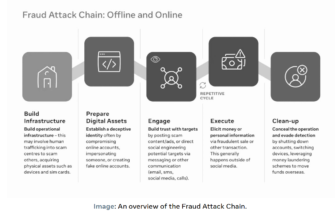

Вмешательства могут осуществляться на системном или индивидуальном уровне ( Chater & Loewenstein, 2022 ; Kozyreva et al., 2020 ). Реакции системного уровня на борьбу с дезинформацией варьируются от предложений по обмену данными между технологическими компаниями и исследователями до законов, запрещающих распространение дезинформации ( Nunez, 2020 ), и нормативных предложений по алгоритмам платформ социальных сетей ( Khan, 2021 ; Ulbricht & Yeung, 2022 ). Это, пожалуй, самая противоречивая форма вмешательства, учитывая потенциально неблагоприятные последствия для свободы выражения мнений и свободы СМИ ( Бончева и др., 2020 г.).). Проблематично, что авторитарные и протоавторитарные государства ввели в действие законы, запрещающие распространение «ложной» информации, которая часто используется для преследования лиц, критически настроенных по отношению к властям (International Press Institute, 2022 ). Обзор действий, предпринятых правительствами разных стран для борьбы с дезинформацией, см. в Funke and Flamini (2018) .

Этот документ призван предоставить исследователям, технологическим компаниям и политикам понимание того, в какой степени вмешательство на индивидуальном уровне может повлиять на распространение дезинформации, восприимчивость к ней или ее воздействие. Козырева и др. (2020) определяют четыре точки входа для политических вмешательств, направленных на решение цифровых проблем: законы и этика (такие как правила и этические принципы); технологии (например, автоматическое обнаружение вредоносного контента); образование (например, медийная и информационная грамотность); и психология / поведенческие науки (стимулирование, подталкивание и технопознание). Здесь мы используем модифицированную версию Козыревой и др. (2020).Классификация образовательных, психологических и поведенческих вмешательств. Мы обсуждаем четыре категории вмешательств: стимулирующие вмешательства (психологическая прививка, критическое мышление и обучение медийной/цифровой грамотности), направленные на улучшение соответствующих компетенций и повышение когнитивной устойчивости; подталкивающие вмешательства (подсказки о точности и вмешательства в социальные нормы), которые направлены на то, чтобы направлять поведение людей посредством проектирования архитектур выбора; разоблачение (включая проверку фактов); и автоматическая маркировка контента . Для каждой категории мы оцениваем эмпирические данные, выявляем ключевые пробелы в знаниях и, при необходимости, подчеркиваем практические и этические последствия. См. рисунок 1.для блок-схемы различных типов вмешательств по борьбе с дезинформацией на системном и индивидуальном уровне.

- Усиление интервенций

- «Предобучение» и психологическая прививка

- Критическое мышление

- Медийная и информационная грамотность

- Подталкивающие вмешательства

- Точность простых чисел

- Социальные нормы подталкивают

- Разоблачение

- Автоматическая маркировка контента

- Рекомендации для политиков и технологических компаний

- Заключение

Усиление интервенций

Согласно Хертвигу и Грюне-Яноффу (2017, стр. 974) , целью стимулирования является «повышение способности людей делать собственный выбор», а основное внимание при стимулировании уделяется «вмешательствам, которые облегчают людям реализацию их собственной свободы воли путем развития существующих компетенций или привития новых», например, путем улучшения способности людей распознавать микротаргетированную рекламу (Lorenz-Spreen et al., 2021 ) . Люди могут решить отказаться от поощрений или не обращать на них внимания (поскольку они по своей природе необязательны и не требуют внесения изменений в среду выбора людей), что делает их маловероятными для создания серьезных этических проблем или серьезных рисков для демократического процесса. Для обзора см. https://scienceofboosting.org/.

В контексте дезинформации стимулирующие вмешательства, как правило, направлены на снижение индивидуальной восприимчивости к дезинформации ( van der Linden et al., 2021 ). Усиливающие вмешательства не всегда могут быть эффективными, например, потому, что они не достигают нужных людей ( Zollo et al., 2017 ). Кроме того, хотя в последние годы было опубликовано большое количество лабораторных исследований, посвященных изучению эффективности различных типов стимулирующих вмешательств (см. Kozyreva et al., 2020 ; Lorenz-Spreen et al., 2021 ), ключевые открытые вопросы заключаются в том, в какой степени эффективность в лаборатории переносится в реальный мир ( Roozenbeek, van der Linden, et al., 2022).), и как повышение компетенций приводит к изменениям в поведении людей. Мы обсуждаем три типа вмешательств, направленных на улучшение способности людей выявлять дезинформацию и, следовательно, можно сказать, что они подпадают под знамя повышения: предварительная обработка (с упором на психологическую прививку), критическое мышление и медийная и информационная грамотность.

«Предобучение» и психологическая прививка

Проблемы, связанные с исправлением дезинформации после ее распространения (см. раздел «Опровержение» ниже), побудили исследователей изучить, как в первую очередь предотвратить попадание людей в заблуждение и распространение дезинформации ( van der Linden et al., 2021 ). Такие упреждающие подходы к борьбе с дезинформацией обычно называют упреждающим опровержением или «предварительным опровержением» ( Cook et al., 2017 ; Traberg et al., 2022 ).

Хотя существует несколько подходов к предварительному заполнению ( Brashier et al., 2021 ; Cook et al., 2017 ; Lewandowsky & van der Linden, 2021 ; Tay et al., 2021 ), наиболее распространенной основой для предварительного размещения является теория прививки ( Comton, 2013 ; McGuire, 1961 ). Люди могут создать установочное сопротивление будущим нежелательным попыткам убеждения, заблаговременно подвергая их «ослабленной» дозе нежелательных убедительных аргументов ( Compton et al., 2021).). Лечение прививками состоит из двух основных компонентов: (1) предупреждение о надвигающейся атаке на чьи-то убеждения или отношения (т. е. предупреждение о надвигающейся манипуляции) и (2) упреждающее опровержение этой предстоящей попытки манипуляции (Compton, 2013 ) . Мета-анализ ( Banas & Rains, 2010 ) показал, что прививки, как правило, эффективны для повышения устойчивости отношения к нежелательным убеждениям со средней величиной эффекта d = 0,43 (считается умеренной величиной эффекта).

Есть два важных различия в контексте интервенций прививки. Первый находится между активными и пассивными прививками ( McGuire & Papageorgis, 1961 ; Traberg et al., 2022 ). При пассивной прививке людям предоставляются контраргументы против нежелательной попытки убеждения, обычно в виде короткого фрагмента текста или видеоролика. При активной прививке люди генерируют собственные контраргументы, например, играя в игру.

Второе различие заключается в прививках , основанных на проблеме, и прививках , основанных на технике . Прививки, основанные на проблеме, направлены на то, чтобы защитить людей от индивидуальных убедительных атак или примеров дезинформации, например, о справедливой торговле ( Tay et al., 2021 ) или изменении климата ( van der Linden et al., 2017 ; Maertens et al., 2020 ; Williams & Bond, 2020 ). Напротив, основанные на технике (также называемые логическими) прививки придают устойчивость к стратегиям или тактикам манипулирования, таким как логические заблуждения, эмоциональные манипуляции или теории заговора ( Cook et al., 2017 , 2018 ; Lewandowsky & Yesilada, 2021 ;Розенбек, ван дер Линден и др., 2022 г. ). Оба подхода имеют свои преимущества: прививки, основанные на проблеме, могут быть более эффективными, чем прививки, основанные на методах, когда известно, какой дезинформации люди могут подвергнуться в ближайшем будущем ( Zerback et al., 2021 ). С другой стороны, прививки на основе техники имеют то преимущество, что применяются к более широкому спектру дезинформации за счет специфичности ( Кук и др., 2017 ; 2018 ).

В последние годы для противодействия дезинформации был разработан ряд прививочных вмешательств ( van der Linden, 2022 ). Было обнаружено, что пассивные прививочные вмешательства успешно обеспечивают психологическую устойчивость к дезинформации об изменении климата ( van der Linden et al., 2017 ; Williams & Bond, 2020 ) и COVID-19 ( Basol et al., 2021 ), комментариям об астротурфинге ( Zerback et al., 2021 ), заговорам о вакцинах ( Jolley & Douglas, 2017 ; Wong) & Harrison, 2014 ), экстремистской пропаганды ( Braddock, 2019 ; Hughes et al., 2021 ) и «фейковых экспертов» ( Cook et al., 2017 ). 2

В одном из направлений исследований изучалось использование коротких информативных видеороликов в качестве прививочных вмешательств. Левандовски и Есилада (2021) обнаружили, что короткое видео привило людям как исламско-экстремистский, так и исламофобский контент. Точно так же Хьюз и соавт. (2021) и Piltch-Loeb et al. (2022) разработали и протестировали эффективные видеоролики о прививках для противодействия экстремистской пропаганде и дезинформации о вакцинах, соответственно (см. плейлист на YouTube для видеороликов, разработанных Piltch-Loeb et al. [2022] : https://www.youtube.com/watch?v=zlfd_N_Bm0Y&list=PLYPI-AWCOGj6oNUfi7ddbBEglL56h8I2C). ). Розенбек, ван дер Линден и др. (2022)разработал пять видеороликов, в каждом из которых люди прививались от разных методов манипулирования. Они обнаружили, что просмотр такого видео значительно снижает последующую восприимчивость к использованию этих методов в контенте социальных сетей, в том числе в экологически обоснованном полевом исследовании на YouTube. Видео можно посмотреть на сайте, созданном исследователями: https://www.inoculation.science/ .

Что касается активных вмешательств по прививкам, недавние исследования были сосредоточены в первую очередь на играх с прививками. Такие игры, как правило, прививают людей против набора методов манипулирования, обычно используемых в определенной области, где распространена дезинформация. Кук и др. (2022) , например, создали Cranky Uncle ( https://www.crankyuncle.com/ ), бесплатную игру (и приложение для телефона), в которой используются мультфильмы и юмор для развития критического мышления и борьбы с дезинформацией об изменении климата. Для дальнейшего чтения см. Cook (2021) и Cook et al. (2022) . Другим примером активной вакцинации являются «Плохие новости» ( https://www.getbadnews.com ).), браузерная игра, в которой игроки стремятся стать «магнатом фейковых новостей», изучая шесть распространенных методов манипулирования, таких как троллинг и атаки на основе личных данных. В ряде исследований было показано, что «Плохие новости» значительно улучшают способность людей выявлять методы дезинформации и повышают их уверенность в своей способности это делать ( Basol et al., 2020 ; Roozenbeek et al., 2020 ; Roozenbeek, Maertens, et al., 2022 ; Roozenbeek & van der Linden, 2019 ). Кроме того, эти эффекты оставались значительными в течение нескольких месяцев после игры, если участникам периодически давали напоминания или «бустерные уколы» ( Maertens et al., 2021 ). Другие игры с прививками включаютHarmony Square ( https://harmonysquare.game ), политическая дезинформация, межгрупповая поляризация ( Roozenbeek & van der Linden, 2020 ), Go Viral! ( https://goviralgame.com ) о дезинформации о COVID-19 ( Basol et al., 2021 ) и Radicalise о стратегиях манипулирования, используемых экстремистскими организациями ( Saleh et al., 2021 ).

Несмотря на то, что прививочные вмешательства имеют ряд преимуществ, они также имеют множество недостатков. Во-первых, прививки, как правило, несколько длительны, требуют как предварительного предупреждения, так и превентивного опровержения. Таким образом, эффективность прививок зависит от добровольного принятия (например, не все хотят играть в игру). Во-вторых, не всегда возможно предсказать, какой дезинформации подвергнутся люди, а также потому, что для эффективности прививок обычно требуется определенная степень специфичности ( Roozenbeek, Traberg, et al., 2022 ; Zerback et al., 2021).), они могут работать не очень хорошо, если расхождение между прививкой и дезинформацией слишком велико. В-третьих, в настоящее время имеется не так много данных о том, как прививки эффективны в дикой природе, например, в социальных сетях (но см. полевое исследование на YouTube, проведенное Roozenbeek, van der Linden, et al., 2022 ). В частности, когда речь идет о поведении (например, о том, как люди делятся новостями), необходимы дополнительные исследования, чтобы выяснить, насколько эффективны прививочные вмешательства в реальных условиях. В-четвертых, некоторые интервенции с прививками (в частности, «игры с фейковыми новостями», см. Modirrousta-Galian & Higham, 2022 г.) не только снижают веру в дезинформацию, но и уменьшают воспринимаемую достоверность «настоящих новостей». Это, по-видимому, довольно распространенный побочный эффект дезинформационных вмешательств в целом (например, советы по медиаграмотности от Guess et al., 2020 и предупреждающие ярлыки от Clayton et al., 2020 ). Возможно, некоторые вмешательства вызывают более общий скептицизм по отношению ко всей информации, хотя это явление, по-видимому, не распространяется на информацию, которая явно верна ( Basol et al., 2021 ; Modirrousta-Galian & Higham, 2022 ; Roozenbeek & van der Linden, 2019).). Наконец, если «прививка» воспринимается как ненадежный субъект, люди могут игнорировать вмешательство по прививке. Как и любое вмешательство, прививки рискуют стать политизированными ( Traberg et al., 2022 ).

Критическое мышление

Критическое мышление обычно определяется как навык более высокого порядка, который влияет на способность человека подвергать сомнению предположения, анализировать аргументы и оценивать качество информации, с которой он сталкивается (Duron et al., 2006 ) . Существуют разногласия по поводу того, является ли критическое мышление передаваемым навыком, который применяется в разных областях, или навыком, специфичным для предметной области ( Axelsson et al., 2021 ; Moore, 2014 ), и является ли критическое мышление навыком ( способностью критически мыслить) или предрасположенностью ( готовность мыслить критически).

Были опробованы различные вмешательства для улучшения критического мышления. Луцке и др. (2019) , например, нашли некоторые доказательства эффективности чтения ряда руководств по оценке онлайн-новостей, которые улучшили способность людей правильно оценивать достоверность реальных и фальшивых новостей об изменении климата на Facebook. Мета-анализ, проведенный Хубером и Кунцелем (2016), пришел к выводу, что, хотя университеты, по-видимому, способствуют развитию критического мышления, конкретные меры по улучшению критического мышления не обязательно приводят к долгосрочным дополнительным выгодам. Однако многие исследования являются мелкомасштабными или проблематичными с методологической точки зрения; поэтому доказательства недостаточно убедительны, чтобы быть окончательными ( El Soufi & See, 2019 ; Todd & O’Brien, 2016).). Для продвижения в этой области необходимы более крупномасштабные, воспроизводимые и надежные исследования.

С этической точки зрения Бойд (2018) утверждает, что критическое мышление может быть бесполезным, если оно поощряет критическую позицию по умолчанию. Однако эта точка зрения не различает здоровый скептицизм и дисфункциональный цинизм, поскольку последний в целом связан с более низким доверием к средствам массовой информации ( Quiring et al., 2021 ). Более того, риторика критического мышления может быть принята теми, кто пропагандирует конспирологические убеждения, которые побуждают людей «проводить собственные исследования» и «задавать вопросы», например, о легитимности научных доказательств (Beene & Greer, 2021 ) .

Медийная и информационная грамотность

С 2007 года ЮНЕСКО выступает за «медийную и информационную грамотность» ( https://www.unesco.org/en/communication-information/media-information-literacy ) как общую концепцию, которая включает в себя компетенции, связанные с медиаграмотностью, информационной грамотностью, новостной грамотностью и цифровой грамотностью. Каждая из этих грамотностей изначально развивалась как отдельная область, но грань между ними становится все более размытой. Уделяя особое внимание молодежи, медиаграмотность преследует две цели: защиту (от влияния рекламы в СМИ, стереотипов и предвзятости) и расширение прав и возможностей (участие в создании СМИ и самовыражении; Hobbs, 2021 ) . Напротив, информационная грамотностьделает акцент на компетенциях по поиску и оценке информации и традиционно преподается библиотекарями. Подобно медиаграмотности, новостная грамотность основана на предположении, что знание методов производства новостей позволит людям более точно оценивать контент ( Tully et al., 2020 ). Наконец, цифровая грамотность включает в себя «необходимые навыки и компетенции для выполнения задач и решения проблем в цифровой среде» ( Reddy et al., 2020 ). В контексте дезинформации эти области часто пересекаются.

Вмешательства в области медийной и информационной грамотности часто разрабатываются в рамках формального образования путем проведения подготовки учителей и уроков медийной и информационной грамотности ( Nygren & Guath, 2021 ). Например, исследователи из Университета Упсалы разработали проект News Evaluator Project ( https://nyhetsvarderaren.se/in-english/ ), серию бесплатных учебных материалов, направленных на стимулирование критики студентами цифровых источников. Другим примером является инициатива Стэнфордского университета Civic Online Reasoning ( https://cor.stanford.edu/) .), который предоставляет бесплатные готовые уроки и учебные программы по таким темам, как боковое чтение (поиск информации на других веб-сайтах о конкретном источнике), сдержанность при нажатии и оценка доказательств. Растущее количество исследований показало, что такие образовательные программы эффективны для расширения бокового чтения и других стратегий навигации в среде цифровых новостей ( Axelsson et al., 2021 ; Breakstone et al., 2021 ; Craft et al., 2017 ; McGrew et al., 2019 ; Wineburg et al., 2022 ).

Чтобы повысить масштабируемость мероприятий по повышению медийной и информационной грамотности за пределами классной комнаты, исследователи изучили, как применять медийную и информационную грамотность в социальных сетях ( Tully et al., 2020 ). Например, Panizza et al. (2022)обнаружили, что предоставление пользователям социальных сетей всплывающего окна с советами о том, как использовать методы бокового чтения, впоследствии увеличило использование таких стратегий. Еще один метод повышения медиаграмотности в социальных сетях — советы по грамотности. Крупномасштабное исследование, оценивающее эффективность вмешательств в области медиаграмотности в Соединенных Штатах и Индии, показало, что предоставление людям советов по медиаграмотности для выявления ложного и вводящего в заблуждение контента улучшило различение правдивых и ложных новостей, хотя вмешательство было успешным только в Индии для высокообразованной выборки, но не для респондентов, проживающих в основном в сельской местности (Guess et al., 2020 ) .

Есть некоторые заметные проблемы, связанные с вмешательствами, основанными на грамотности (некоторые из которых являются общими с вмешательствами, ориентированными на критическое мышление, которые обсуждались выше). Во-первых, такие вмешательства в первую очередь были сосредоточены на детях и молодежи через учреждения формального образования ( Petranová et al., 2017 ). Меньше внимания уделяется потребностям взрослых в медийной и информационной грамотности, а также видам вмешательств, которые могут быть эффективными для старших возрастных групп ( Lee, 2018 ).

Во-вторых, хотя некоторые исследования, например, из Индии ( Badrinathan, 2021 ; Guess et al., 2020 ) и Пакистана ( Ali & Qazi, 2021 ) доступны, исследований по проверке медиаграмотности за пределами западного мира остается мало. Это важно, потому что эффективные вмешательства в развитых странах могут оказаться неэффективными в других странах. Бадринатан (2021) , например, обнаружил, что часовой тренинг по медиаграмотности, проведенный в Индии, существенно не улучшил способность участников выявлять дезинформацию.

В-третьих, дизайн мероприятий по повышению медийной и информационной грамотности значительно различается. Они используют разные концепции обучения грамоте, и вмешательство варьируется от одноразового знакомства до модуля уроков в течение многих месяцев. Более того, исследователи используют широкий набор показателей, что затрудняет сравнение исследований ( Potter & Thai, 2016 ; Roozenbeek, Maertens, et al., 2022 ). Такие концептуальные различия, по-видимому, имеют значение. Недавнее исследование, основанное на национальной выборке граждан США, показывает, что информационная грамотность, но не медийная, новостная или цифровая грамотность, значительно повышает вероятность выявления дезинформационных историй ( Jones-Jang et al., 2019 ).

В-четвертых, влияние медийной и информационной грамотности не всегда ясно. В целом не хватает всесторонних данных об оценке, и «продольный характер как оценки, так и обновления программ медиаграмотности делает эту проблему вечной борьбой» ( Bulger & Davison, 2018, стр. 1 ). Что касается конкретно дезинформации, некоторые исследования показывают, что знакомство с медийной и информационной грамотностью предсказывает устойчивость к политической дезинформации ( Kahne & Bowyer, 2017 ), но другие исследования предупреждают, что медийная грамотность наделяет людей ложным чувством уверенности ( Bulger & Davison, 2018 ). Со своей стороны, платформы социальных сетей уже предоставляют пользователям услуги по повышению медиаграмотности (см., например, Библиотеку цифровой грамотности Facebook,https://www.facebook.com/safety/educators и продолжающееся сотрудничество Twitter с ЮНЕСКО в области медиаграмотности, https://blog.twitter.com/en_sea/topics/events/2019/Media-and-information-literacy ), но они, как правило, не предоставляют никакой информации об их внедрении или воздействии ( Culloty et al., 2021 ).

Подталкивающие вмешательства

Талер и Санстейн (2008, стр. 6) определяют подталкивание как «любой аспект архитектуры выбора, который изменяет поведение людей предсказуемым образом, не запрещая какие-либо варианты или существенно меняя их экономические стимулы». В отличие от бустов, которые нацелены на компетенции, подталкивает, таким образом, целевое поведение. Некоторые ученые утверждают, что люди делятся дезинформацией в социальных сетях в первую очередь потому, что не уделяют достаточного внимания точности, например, потому что среда социальных сетей может отвлекать ( Pennycook & Rand, 2019 , 2021 ). Поэтому исследователи предложили ряд подталкивающих вмешательств, так называемых «подталкиваний к точности» (или подсказок о точности), которые призваны переключить внимание людей наточность, тем самым уменьшая их склонность делиться дезинформацией с другими. Фацио (2020) , например, обнаружил, что просьба к людям сделать паузу на несколько секунд, чтобы оценить точность заголовков новостей, значительно снижает их готовность делиться ложными новостями. Ратье, Ван Бавел и др. (2022) обнаружили, что мотивация людей быть как можно более точными повышает точность и снижает предвзятость при обнаружении ложных заголовков.

Действительно, потенциальные преимущества подхода подталкивания многочисленны: подталкивание легко внедрить в социальных сетях (например, Twitter теперь спрашивает людей, уверены ли они, что хотят ретвитнуть статью, если они еще не прочитали ее), рентабельно и в основном ненавязчиво. Кроме того, подталкивание к точности не требует от людей «согласия» на вмешательство, что делает его легко масштабируемым.

Потенциальные недостатки подталкивания включают реакцию на вмешательство (например, Mosleh et al., 2021 , обнаружили, что исправление людей, которые ранее делились ложными новостями в Твиттере, снижало качество и повышало токсичность последующих ретвитов этих пользователей; эффект непреднамеренного обратного эффекта) и меньший размер эффекта при реализации в реальных условиях по сравнению с лабораторией (DellaVigna & Linos, 2022 ) . С этической точки зрения Козырева и соавт. (2020) отмечают, что низкозатратные подталкивания могут вытеснить поддержку дорогостоящих (или требующих больших усилий) мер (возможно, это относится и к активизации вмешательств, и вмешательств на индивидуальном уровне в более общем плане; см. Chater & Loewenstein, 2022) .). В контексте дезинформации в последние годы получили распространение различные виды подталкивания. В нашем обсуждении мы сосредоточимся на двух наиболее заметных из них: простых правилах точности и вмешательстве социальных норм.

Точность простых чисел

Самый известный тип подталкивания к точности — это «прайм точности», который заключается в том, чтобы попросить людей оценить, является ли точным отдельный (обычно неполитический и беспристрастный) заголовок. 3 Это ненавязчиво напоминает им о важности обмена точным контентом, что должно повысить качество их последующих решений по обмену новостями. Несколько экспериментальных исследований показали, что простые числа точности улучшают последующее распознавание совместного использования. Недавний метаанализ 14 лабораторных основных исследований точности ( Pennycook & Rand, 2022 ) показал, что подталкивания к точности значительно улучшают «различение при совместном использовании» (показатель качества решений о совместном использовании; Epstein et al., 2021 ; Pennycook et al., 2020 , 2021 ).), хотя размер эффекта считается небольшим в рамках психологических исследований. 4 Что касается полевых исследований, Pennycook et al. (2021) обнаружили, что отправка группе пользователей Twitter, которые ранее делились некачественными, консервативными источниками, такими как Breitbart , прямого сообщения, в котором их просили оценить точность (неполитического) заголовка, впоследствии повышала качество контента, которым они делились в Twitter, в первую очередь побуждая их делиться более качественными источниками, такими как New York Times и CNN .

Однако несколько повторений и повторных анализов основных исследований точности добавили нюансов этим выводам ( Pennycook & Rand, 2022 ; Pretus et al., 2021 ; Rathje, Roozenbeek, et al., 2022 ; Roozenbeek, Freeman, et al., 2021 ). Pennycook and Rand (2022) сообщают, что простые числа точности не влияли на качество решений, принимаемых людьми в отношении обмена информацией, в 4 из 14 исследований, включенных в их метаанализ. Розенбек, Фриман и др. (2021) также изначально не удалось воспроизвести эффект, о котором сообщалось в более раннем исследовании ( Pennycook et al., 2020), обнаружив небольшой эффект только после сбора второго раунда данных, примерно на 50% от размера эффекта исходного исследования. Они также отметили первоначальные признаки быстрого затухания в том смысле, что влияние прайма точности происходило в основном вскоре после воздействия и, по-видимому, быстро стиралось после этого. Быстрое затухание эффекта является известным явлением в литературе по праймерам ( Branigan et al., 1999 ; Trammell & Valdes, 1992 ), но требует дальнейшего изучения в контексте прайминга точности.

Простые числа точности также, по-видимому, сдерживаются политическими пристрастиями. Претус и др. (2021) не обнаружили влияния простых чисел точности на две выборки, одну из консерваторов США и одну из крайне правых избирателей Испании. Этот вывод был дополнительно подтвержден Rathje, Roozenbeek и соавт. (2022) , которые повторно проанализировали шесть ранее опубликованных исследований прайм-фактора точности и обнаружили, что эффект прайминга был намного меньше для консерваторов (США), чем для либералов. Этот очевидный эффект сдерживания особенно важен в свете хорошо известного вывода о том, что (США) консерваторы и сторонники ультраправых, по-видимому, чаще делятся дезинформацией ( Garrett & Bond, 2021 ; Grinberg et al., 2019 ). Стоит отметить, что Pennycook и соавт. (2021)действительно обнаружили влияние простых чисел точности на преимущественно консервативную выборку в своем полевом исследовании в Твиттере. 5

Почему существует этот эффект модерации (и по этому поводу ведутся споры, см. Pennycook & Rand, 2022 ), менее ясно, но, возможно, это связано с тем, что эффект прайминга точности меньше для более убедительной дезинформации и для людей, которые обычно оценивают дезинформацию как более точную. В исследовании, проведенном в 16 странах, Arechar et al. (2022)обнаружили, что влияние прайма точности на качество решений людей об обмене в данной стране сильно коррелирует с разрывом между воспринимаемой точностью заголовков и намерениями делиться в этой стране; другими словами, прайминг-эффект был меньше (или незначителен) в странах, где люди обычно оценивали дезинформацию как более точную. В Соединенных Штатах консерваторы, как правило, оценивают дезинформацию как более точную, чем либералы (см. Roozenbeek, Maertens, et al., 2022 ), что может означать меньший разрыв между точностью и обменом, тем самым уменьшая эффект подготовки.

Социальные нормы подталкивают

Вместо того, чтобы подчеркивать точность, подталкивание социальных норм привлекает внимание к партийным или общественным нормам, связанным с поведением при обмене новостями, чтобы улучшить качество решений людей об обмене новостями. Подталкивание социальных норм относительно мало изучено по сравнению с праймами точности и другими типами подталкивающих вмешательств. Некоторые подталкивания к социальным нормам сосредоточены на подчеркивании норм, касающихся обмена дезинформацией в общем смысле. Например, Andı and Akesson (2021) обнаружили, что предупреждение людей об обилии ложной информации и сообщение им о том, что «наиболее ответственные люди дважды подумают, прежде чем делиться статьями со своей сетью», значительно сократили долю людей, готовых поделиться ложной новостной статьей с другими. Гимпель и др. (2021)отчет о том, что подвергание людей запретительным (какое поведение большинство людей одобряет или не одобряет), но не описательным (что другие люди делают в определенных ситуациях) социальным нормам, увеличивает вероятность того, что участники будут сообщать о фальшивых новостных сообщениях в социальных сетях как о дезинформации; комбинированный подход (как с предписывающими, так и с описательными нормами) имел наиболее существенный эффект.

Другие подталкивания социальных норм направлены на противодействие конкретным ложным или двусмысленным убеждениям. Куксон и др. (2021) обнаружили, что вмешательство в социальные нормы (предоставление людям отзывов о вере участников в теории заговора против вакцин, о том, насколько, по их мнению, другие люди, в данном случае, родители из Великобритании, верили в такие заговоры, и фактический уровень веры родителей из Великобритании в заговор) значительно снизил личную веру в заговоры против вакцин . Экер, Сандерсон и др. (2022) сообщают, что описательные нормы снижали веру в совпадающие с мировоззрением двусмысленные утверждения (например, об экономическом влиянии беженцев), хотя описательная норма плюс конкретное опровержение оказались наиболее эффективными.

Эпштейн и др. (2021) , с другой стороны, не обнаружили влияния подчеркивания партийных или социальных норм на намерения делиться новостями. Однако они обнаружили, что комбинированное вмешательство (социальные нормы + советы по грамотности или социальные нормы + приоритет важности, т. е. информирование людей о важности обмена точными новостями) положительно повлияло на качество обмена намерениями. В целом, вмешательство в социальные нормы, таким образом, дало многообещающие, хотя и предварительные результаты (и, что важно, их так же легко реализовать в социальных сетях, как и точность), но их еще предстоит изучить в реальных социальных сетях.

Разоблачение

Разоблачение заблуждений после того, как они распространились, является популярным подходом к борьбе с дезинформацией. Инициатив, таких как Snopes, FullFact и StopFake, предостаточно, а некоторые из них имеют большое количество подписчиков в социальных сетях. Развенчание может быть основано на фактах (т. е. на исправлении конкретного неправильного восприятия) или на логике, фокусируясь на эпистемологическом качестве дезинформации или методах манипулирования, используемых для введения в заблуждение (Cook et al., 2017; Vraga & Bode, 2020; Vraga et al . , 2020 ) . Некоторые технологические компании, в частности Meta (ранее Facebook), используют разоблачение, используя как автоматизированные методы ( Guo et al., 2022 ; Thorne & Vlachos, 2018) и ориентированные на человека методологии для модерации контента на своих платформах. Разоблачение — это почти синоним проверки фактов, но не совсем: можно проверить историю и оценить ее как правдивую, тогда как развенчание относится только к дезинформации.

В последние годы было разработано несколько разоблачающих ресурсов. Например, исследователи из JITSUVAX ( https://jitsuvax.info/ ) создали бесплатный ресурс для опровержения как конкретных аргументов, обычно используемых в дезинформации о вакцинах, так и установочных корней, лежащих в основе этих аргументов. В 2020 году группа исследователей опубликовала « Руководство по разоблачению» , в котором обобщается текущее состояние исследований по разоблачению ( Lewandowsky et al., 2020 ). В Справочнике отмечается, что разоблачение наиболее эффективно, если следовать следующей процедуре:

-

(1)Свинец с фактом 6 ; сделайте его простым, конкретным и правдоподобным и убедитесь, что он соответствует развенчиваемой истории.

-

(2)Предупредите аудиторию, что она вот-вот увидит дезинформацию, и упомяните об этом только один раз.

-

(3)Объясните, как дезинформация вводит в заблуждение.

-

(4)Закончите, подкрепив факт и убедившись, что факт дает правдоподобное альтернативное объяснение дезинформации.

Несколько лет назад исследователи выразили обеспокоенность потенциальными «обратными эффектами» (исправления, по иронии судьбы укрепляющие веру людей в первоначальную дезинформацию, см. Nyhan & Reifler, 2010 ). «Эффект иллюзорной правды» гласит, что дезинформация воспринимается как более точная при многократном воздействии ( Ecker, Lewandowsky, et al., 2020 ; Fazio et al., 2015 ). Это открытие вызвало обеспокоенность тем, что повторение дезинформации при ее исправлении может непреднамеренно усилить веру людей в нее (так называемый «обратный эффект фамильярности»). Однако более поздние исследования показали, что такие обратные эффекты не наблюдаются надежно, и поэтому риск разоблачения «побочных эффектов» представляется низким ( Swire-Thompson et al., 2020 ,2022 ; Вуд и Портер, 2019 ). В целом, метаанализы пришли к выводу, что корректирующие сообщения, как правило, эффективны для снижения веры в дезинформацию, хотя исправить дезинформацию о политике и маркетинге труднее, чем о здоровье (Chan et al., 2017; Walter & Murphy, 2018; Walter et al . , 2020 ) . Кроме того, сообщения развенчания кажутся менее эффективными, когда они менее детализированы ( Ecker, O’Reilly, et al., 2020 ; Paynter et al., 2019 ), а политические убеждения и знания также ослабляют эффект ( Walter & Murphy, 2018 ).

Тем не менее, есть несколько факторов, которые ограничивают эффективность разоблачения. Во-первых, большое значение имеет то, кто занимается разоблачением. Воспринимаемый опыт и надежность источника влияют на то, насколько вероятно, что кто-то примет исправление ( Benegal & Scruggs, 2018 ; Ecker & Antonio, 2021 ; Guillory & Geraci, 2013 ; Vraga & Bode, 2017 ). Кроме того, Марголин и соавт. (2017) обнаружили, что пользователи Twitter с большей вероятностью примут исправление от учетной записи, на которую они подписаны, чем исправление от незнакомца, что указывает на то, что тесные связи между фактчекерами и распространителями дезинформации являются ключевыми для эффективности разоблачения.

Во-вторых, опровержения, похоже, не достигают тех же людей, что и исходная дезинформация. Золло и др. (2017) , например, обнаружили, что посты с разоблачениями редко проникают в эхо-камеры заговоров в Facebook, а вместо этого в основном достигают пользователей, которые предпочитают потреблять научно-ориентированный контент (которые изначально вряд ли поверят дезинформации). Hameleers and van der Meer (2019) показали, что люди больше участвуют в проверках фактов, когда они соответствуют прежним установкам, и избегают, когда они несовместимы, что указывает на то, что люди имеют предвзятость подтверждения при принятии решения о том, какие проверки фактов использовать. Кроме того, Vosoughi et al. (2018) обнаружили, что контент, который специалисты по проверке фактов оценили как истинный, достиг гораздо меньшего числа людей, чем контент, который они оценили как ложный.

В-третьих, даже если корректирующие сообщения доходят до людей, подвергшихся воздействию исходной дезинформации, исправление дезинформации не всегда полностью отменяет веру людей в нее, явление, известное как «эффект продолжающегося влияния» (Ecker, Lewandowsky, et al., 2020; Walter & Tukachinsky , 2020 ) . Считается, что это происходит потому, что информация, ранее закодированная в памяти, может влиять на суждения, даже если более свежая информация опровергает ее ( Johnson & Seifert, 1994 ).

В-четвертых, фактчекеры сталкиваются с рядом политических проблем. Многие из наиболее спорных политических аргументов носят субъективный и этический характер и, как таковые, не сводятся к объективным фактам ( Коулман, 2018 ). Грейвс (2016 , 2018 ) утверждает, что сами фактчекеры рискуют стать политизированными. Например, решение проверить утверждение политика может быть воспринято как выбор стороны и помещение проверки фактов в центр политических дебатов. Есть также предположение, что люди, склонные к конспирологическому мышлению, могут сопротивляться разоблачению, что затрудняет использование основных источников доказательств для опровержения конспирологических убеждений ( Hayes, 2006, стр. 13).). Таким образом, меры, направленные на делегитимацию источников дезинформации, являются ключом к уменьшению их воздействия ( Ahmed et al., 2020 ). Еще одна проблема — зависимость некоторых фактчекеров от крупных доноров. Meta, например, финансирует крупномасштабную стороннюю программу проверки фактов, которую критикуют за отсутствие прозрачности и чрезмерное влияние на то, какой контент блокируется в социальных сетях (BMJ, 2021; Nyhan , 2017 ) . Таким образом, эффективность проверки фактов частично зависит от сотрудничества крупных социальных сетей.

Наконец, литература несколько неоднозначна, когда речь заходит об относительной эффективности предварительного и разоблачения. Брашир и др. (2021) 7 и Tay et al. (2021) , например, оба сообщают об описательной разнице в размере эффекта в пользу разоблачения при сравнении упреждающих и постфактум исправлений дезинформации (хотя следует отметить, что эта разница не была значимой в обоих исследованиях). Джолли и Дуглас (2017) , напротив, обнаружили, что только предварительная оценка была эффективной (а развенчание — нет) в противодействии неблагоприятным последствиям воздействия теорий заговора против вакцин. Точно так же Грейди и соавт. (2021)обнаружили, что предварительные предупреждения были описательно более эффективными, чем опровержение в обескураживающей вере в ложные заголовки политических новостей. Однако прямое сравнение разоблачения и предварительного разоблачения, хотя и интересное с научной точки зрения, имеет ограничения. Поскольку предварительное информирование носит превентивный характер (т. е. оно происходит до того, как будет раскрыта дезинформация), обычно невозможно точно знать, какую дезинформацию следует предварительно опровергнуть (поскольку вы не можете знать, с какой дезинформацией люди столкнутся в будущем или в какой форме). Другими словами, предварительная информация и опровержение одной и той же дезинформации редко (если вообще когда-либо) будут выглядеть одинаково и, более того, не будут иметь одной и той же цели (исправить неправильное восприятие или предотвратить его распространение).

Автоматическая маркировка контента

Онлайн-платформы выступают за использование автоматизации для быстрой маркировки контента в масштабе, все чаще полагаются на автоматизированные вмешательства для модерации больших объемов контента, загружаемого в их системы, и предоставления пользователям информации для оценки достоверности информации или источников (Alaphilippe et al., 2019 ) . Существуют различные типы ярлыков контента, например проверки фактов (например, «эта статья была признана ложной независимыми экспертами по проверке фактов»; см. Brashier et al., 2021), предупреждения общего или конкретного содержания ( Clayton et al., 2020 ; Mena, 2019 ) и ярлыки достоверности новостей ( Aslett et al., 2022).). Автоматизированная маркировка контента обычно опирается на модели машинного обучения и нейронных сетей для автоматизации процесса модерации контента ( Alaphilippe et al., 2019 ; Gorwa et al., 2020 ). Хотя конкретные методы значительно различаются, общая цель состоит в том, чтобы классифицировать контент по проблемным категориям (например, возможная дезинформация) или сопоставлять загружаемые материалы с базой данных проблемного контента (например, известные случаи дезинформации); см. Thorne and Vlachos (2018) и Guo et al. (2022) для обзора. Исследования эффективности ярлыков контента, таких как предупреждения о курении и алкоголе, выявили несколько необходимых шагов обработки информации ( Conzola & Wogalter, 2001).). Этикетка должна привлекать внимание и удерживать внимание достаточно долго, чтобы была замечена вся необходимая информация. Ярлык должен быть понят, и убеждения и установки получателя могут повлиять на это понимание. Наконец, метка должна мотивировать получателя предпринять предлагаемое действие. В целом Боде и Врага (2018) обнаружили, что автоматические исправления и социальные исправления, предоставляемые сверстниками, были одинаково эффективны в ограничении неверных восприятий, что предполагает, что человеческое общение не обязательно для принятия исправлений.

Тем не менее, в то время как автоматическая маркировка контента предлагает преимущества с точки зрения скорости и масштаба реализации, существуют недостатки в отношении согласованности, надежности и доказанной эффективности. Во-первых, алгоритмы классификации разрабатываются как платформами социальных сетей, так и независимыми исследователями, но последние находятся в невыгодном положении из-за своей зависимости от общедоступных данных и ограниченного доступа к API, предлагаемого некоторыми платформами ( Freelon, 2018 ). Алгоритмы также обычно остаются в секрете, в то время как независимые исследователи обычно открывают свои методы и результаты для проверки.

Во-вторых, автоматическая маркировка может быть ненадежной. Без человеческого интеллекта для проверки алгоритмических суждений существуют значительные риски чрезмерно усердной и подверженной ошибкам модерации ( Banchik, 2021 ; Mühlhoff, 2019 ). Более того, платформы, как правило, не предоставляют адекватной информации о своих собственных усилиях по измерению эффективности технологических вмешательств или не позволяют независимым исследователям проверять заявления об эффективности. Обзор вмешательств в связи с COVID-19, о которых платформы сообщили Европейской комиссии, показал, что применение технологических вмешательств было крайне непоследовательным. Например, в некоторых случаях к достоверному контенту применялись общие предупреждающие метки, а к дезинформационному контенту не применялись предупредительные метки ( Culloty et al., 2021).). Такие несоответствия вызывают озабоченность, поскольку общественное понимание алгоритмов платформы, процедур модерации контента и применения меток контента ограничено.

В-третьих, независимые исследования эффективности (автоматизированной) маркировки контента неоднозначны. В некоторых исследованиях было отмечено, что маркировка контента снижает намерения поделиться помеченным контентом ( Mena, 2019 ), в то время как в других исследованиях не наблюдалось влияния на воспринимаемую точность помеченного контента ( Oeldorf-Hirsch et al., 2020 ). Аслетт и др. (2022) обнаружили, что ярлыки достоверности новостей не смогли уменьшить неправильное восприятие и оказали ограниченное влияние на качество новостной диеты людей. Ярлыки контента, применяемые платформами социальных сетей, как правило, являются общими предупреждениями, которые предупреждают людей о «спорном» характере утверждений или содержат общие напоминания о необходимости поиска достоверной информации. Однако предыдущие исследования показали, что общие предупреждения менее эффективны, чем конкретные предупреждения.Клейтон и др., 2020 г .; Экер и др., 2010 ).

Наконец, ученые отмечают, что на понимание, вероятно, будет влиять дизайн ярлыков контента, и что требуется гораздо больше исследований, чтобы понять эффективный кросс-культурный дизайн для онлайн-платформ (Saltz et al., 2021 ) . Такие платформы, конечно, способны ответить на эти вопросы, но на сегодняшний день они отказываются делиться соответствующей информацией о том, кто занимается их вмешательством, при каких обстоятельствах и с какими результатами.

Рекомендации для политиков и технологических компаний

В этой статье мы рассмотрели доказательства, пробелы в знаниях и практические последствия четырех категорий дезинформационных вмешательств: продвижение, подталкивание, опровержение и (автоматическая) маркировка контента. Особое внимание мы уделили вмешательствам на индивидуальном уровне, основанным на психологических исследованиях. Эта категоризация неизбежно несколько искусственна. Вмешательства в каждой области пересекаются, и не всегда ясно, какие вмешательства относятся к какой категории.

С 2016 года исследования дезинформации пережили массовый бум, и было показано, что многие вмешательства эффективны в борьбе как с верой в дезинформацию, так и с распространением дезинформации, особенно в лабораторных условиях. Однако в отношении этого растущего объема исследований остается несколько открытых вопросов, которые мы переводим в конкретные рекомендации для политиков и технологических компаний.

Во-первых, большая часть доступных исследований в значительной степени сосредоточена на Западной Европе, Северной Америке и Австралии. Тестирование вмешательств, разработанных для незападных и неанглоязычных стран, остается сложным; например, использование онлайн-платформ для набора участников, таких как Prolific Academic, Lucid или Respondi, в развивающихся странах может не дать достаточно репрезентативных данных, поскольку выборки перекошены в сторону высокообразованных городских жителей ( Badrithan, 2021 ). Альтернативные методы сбора данных, такие как телефонные опросы, гораздо сложнее проводить и могут быть дорогостоящими. Важно отметить, что то, что работает на Западе, может не работать где-либо еще: вмешательства, эффективность которых была доказана в западных странах, не дали таких же результатов в таких странах, как Индия ( Badrinathan, 2021 ;Guess et al., 2020 ) и Пакистане ( Ali & Qazi, 2021 ). Как отмечают Али и Кази (2021) : эффективность вмешательств «в решающей степени зависит от того, насколько хорошо их функции и способы доставки адаптированы для изучаемой группы населения». Точно так же автоматизированные решения могут хорошо работать на английском языке, но, как правило, не очень продвинуты на других языках. Мы призываем переосмыслить, как сделать проведение исследований по дезинформации за пределами западных и развитых стран более доступным и доступным, например, инвестируя в репрезентативность онлайн-выборок и облегчая исследователям набор участников через платформы социальных сетей.

Во-вторых, эффективность в лаборатории не приводит автоматически к реальной эффективности. ДеллаВигна и Линос (2022) , например, обнаружили, что подталкивающие вмешательства (например, сообщения, такие как письма или электронные письма, предназначенные для увеличения использования вакцины или сокращения количества пропущенных визитов) были примерно в 6 раз менее эффективными (с точки зрения размера эффекта) при их применении в полевых условиях по сравнению с лабораторией. Если эта сниженная эффективность распространяется на вмешательства по дезинформации (а есть основания ожидать этого; см. Roozenbeek, van der Linden, et al., 2022 ; Pennycook et al., 2021 ), важно убедиться, что вмешательства имеют надежные размеры эффекта в лабораторных исследованиях, прежде чем внедрять их в полевых условиях. Однако проведение полевых исследований может быть непомерно дорогим.Розенбек, ван дер Линден и др. (2022) , например, запустили рекламную кампанию на YouTube, чтобы проверить эффективность серии видеороликов о прививках в экологически приемлемой обстановке при поддержке Google Jigsaw. В настоящее время затраты на такие исследования просто не по карману без сотрудничества с донорами. Поэтому мы рекомендуем демократизировать тестирование эффективности дезинформационных вмешательств в реальных условиях, например, предоставляя исследователям бесплатные (или сильно скидочные) кредиты на рекламу и доступ к API для платформ социальных сетей, таких как TikTok, Twitter, Facebook и YouTube.

В-третьих, для выявления причинных последствий вмешательств по дезинформации исследования обычно сосредотачиваются на одном типе вмешательств. В этой статье мы обсудили данные, лежащие в основе того, как эти вмешательства работают изолированно. На практике, однако, вмешательства сосуществуют в сложной медийно-информационной среде. То, как эти вмешательства работают параллельно друг с другом, почти невозможно оценить без сотрудничества с платформами, на которых они реализуются, и существует очевидная потребность в дальнейшем междисциплинарном и кросс-платформенном сотрудничестве.

В-четвертых, существует большая потребность в большем количестве данных в открытом доступе. После пандемии COVID-19 политики стали более настойчиво призывать платформы ограничить распространение дезинформации. Европейская комиссия признала необходимость более широкого доступа к данным, что позволит независимым исследователям лучше понять роль, которую платформы играют в различных областях, включая недостоверную и дезинформацию. Закон о цифровых услугах ( Европейская комиссия, 2022 г.)) вводит обязательства для платформ предоставлять данные «проверенным исследователям» (статья 31), и это положение отражено в Руководстве по усилению Кодекса (статья 8.1). Некоторые платформы социальных сетей предоставили доступ к своим данным либо через API (например, Twitter), либо через специальные сервисы (например, CrowdTangle Facebook). Однако часто доступ к данным остается проблематичным, и мы призываем платформы повысить прозрачность и обмен данными с исследователями ( Culloty et al., 2021 ). Более широкий доступ к данным платформ может обеспечить более глубокое понимание природы дезинформации и воздействия вмешательств в реальных условиях, а также решить отмеченные выше проблемы, касающиеся географических пробелов в исследованиях и непомерно высоких затрат.

В-пятых, в этой статье мы сосредоточились в первую очередь на решениях, которые реализуются на уровне личности. Как справедливо отмечают Chater and Loewenstein (2022) , это ставит проблему дезинформации в индивидуальном, а не в системном плане. Это рискует отвлечь внимание от политики, направленной на системные изменения. Мы утверждаем, что ни одно из мер, обсуждаемых в этой статье, ни по отдельности, ни вместе взятые, не является достаточным для комплексного решения проблемы дезинформации и противодействия ей. Решения на системном уровне, такие как требование к компаниям социальных сетей давать представление об алгоритмах рекомендаций их платформ (Alfano et al., 2021), не менее, если не более важны, чем вмешательства на индивидуальном уровне.

В-шестых, вне сферы регулирования такие компании, как Google и Twitter, также инвестировали в разработку и тестирование средств дезинформации. Твиттер, например, запустил «предварительную» кампанию по противодействию дезинформации о фальсификациях выборов в преддверии президентских выборов в США в 2020 году. Проверка эффективности этой кампании проводилась внутри компании без участия независимых исследователей. В какой степени кампания способствовала сокращению распространения предвыборной дезинформации, поэтому неизвестно. Кроме того, такие эксперименты часто проводятся без информированного согласия участников ( Grimmelmann, 2015).). Поэтому мы рекомендуем повысить прозрачность усилий технологических компаний по измерению эффективности вмешательств и предоставить независимым исследователям возможность проверить их заявления об эффективности ( Culloty et al., 2021 ). См. Паскетто и др. (2020) для всестороннего обзора того, как исследователи и платформы могут сотрудничать для противодействия дезинформации.

Важным шагом вперед стало бы требование к платформам гарантировать, что независимые эксперты проверяют меры по дезинформации, которые они принимают, и что их методы, данные (если позволяют соображения конфиденциальности) и выводы обнародуются. Однако в идеале независимые эксперты должны не только информировать об анализе данных, собранных платформами, но и играть важную роль в разработке и реализации тестирования эффективности. Поэтому мы утверждаем, что все вмешательства должны разрабатываться и осуществляться с учетом эффективности. Для этого недостаточно сотрудничества между академическими кругами и платформами: требуется подотчетность.

Заключение

Дезинформация существует в развивающейся среде, которая требует постоянного мониторинга. В этой статье мы обсудили доказательства, лежащие в основе четырех категорий вмешательств по борьбе с дезинформацией, которые осуществляются на индивидуальном уровне: продвижение, подталкивание, опровержение и автоматическая маркировка контента. Решения, которые эффективны сегодня, завтра могут оказаться менее эффективными, и деятели, которые сознательно стремятся распространять дезинформацию, также адаптируются к изменяющейся среде. Таким образом, комплексный подход к борьбе с дезинформацией включает (1) подотчетность и прозрачность со стороны технологических компаний и регулирующих органов в отношении того, как разрабатываются и тестируются меры вмешательства; (2) сотрудничество между исследователями (академическими и неакадемическими) и технологическими компаниями не только с точки зрения обмена данными и доступа к API, но и всего процесса разработки вмешательства, тестирование эффективности и внедрение; (3) обеспечение того, чтобы создание и тестирование вмешательств в реальных условиях и в незападных условиях стало более доступным и доступным; (4) развитие дальнейшего понимания того, как различные вмешательства работают параллельно друг с другом в реальном мире; и (5) включение как индивидуального уровня (который мы обсуждали в этой статье), так и подходов системного уровня.

Эйлин Каллоти (доктор философии) — доцент Школы коммуникаций Дублинского городского университета и заместитель директора Института будущих медиа, демократии и общества DCU. Ее исследования посвящены дезинформации, управлению цифровыми технологиями и средствам массовой информации.

Джейн Суитер (доктор философии) — профессор Школы коммуникаций Дублинского городского университета и директор Института будущих медиа, демократии и общества DCU. Ее исследования сосредоточены на информационной среде в публичной сфере и, в частности, на расширении дискуссий и борьбе с дезинформацией.

1 Мы признаем разнообразие различных определений «дезинформации», «дезинформации», «дезинформации», «фейковых новостей», «ложных новостей», «пропаганды» и других подобных терминов (Allcott & Gentzkow, 2017; Krause et al., 2020; Lazer et al., 2018; Roozenbeek & van der Linden, 2022; Tandoc ) . и др . , 2018 ) . Наше определение дезинформации преднамеренно широкое, чтобы включить в себя эти различные термины и включить не только ложный, но и вводящий в заблуждение/манипулятивный контент ( Altay et al., 2021 ). См. Freelon and Wells (2020) и Kapantai et al. (2021) для дальнейшего обсуждения.

2 Мы отмечаем, что выводы Cook et al. (2017) не были воспроизведены в недавней репликации с использованием выборки из Германии ( Schmid-Petri & Bürger, 2021 ) в том смысле, что, в отличие от исходного исследования, прививка не повлияла на отношение участников к климату, возможно, из-за более низких исходных убеждений в дезинформации о климате.

3 Хотя для этого конкретного типа вмешательства существуют различные названия (например, «подталкивание к точности», «подсказка к точности» и «оценочное лечение»; см. Pennycook & Rand, 2022), мы здесь используем «основную точность», чтобы отличить оценочное лечение с одним заголовком от других подобных вмешательств с подталкиванием, которые подпадают под знамя подсказок/подталкивания к точности (см. Epstein et al., 2021; Pennycook & Rand , 20 22 ) . При этом мы следуем Pennycook et al. (2020, стр. 777) , которые отмечают, что этот тип точности «незаметно подталкивает [участников] к размышлению о точности, когда их просят оценить точность одного […] заголовка новостей».

4 Pennycook and Rand (2022) сообщают о коэффициенте метааналитической регрессии (скорее всего, нестандартизированном) b = 0,034, 95% ДИ [0,026, 0,043]. Метааналитический показатель Коэна d не сообщался.

5 Пенникук и др. (2021) обнаружили, что наибольшей разницей в поведении при обмене новостями до публикации было увеличение после обработки основных/высококачественных источников новостей, таких как New York Times и CNN , в большей степени, чем уменьшение после обработки дезинформации/некачественного контента. На теоретическом уровне вопрос о том, почему простые числа точности могут побудить консервативных американских пользователей Твиттера публиковать большезаголовков New York Times, требует дальнейшего изучения.

6 Свайр-Томпсон и др. (2021) утверждают, что конкретный формат исправления может играть ограниченную роль при исправлении дезинформации, а в Справочнике по разоблачению также говорится, что в случаях, когда факты очень неоднозначны, может быть лучше сначала объяснить, почему миф является ложным, а не сначала объяснить факт.

7 Как отмечают Lewandowsky и Yesilada (2021) , исследование Brashier et al. (2021) отклонились от общепринятых правил де- и предварительной укладки; в этом исследовании участникам показывали ярлык (с надписью «проверено фактами и оценивали как ложь/правда») либо до, либо после ложного или истинного заголовка новостей. Однако, в отличие от других исследований ( Cook et al., 2017 ; Jolley & Douglas, 2017 ) и руководств по передовой практике ( Lewandowsky et al., 2020 ), опровержение дезинформации представлено не было (т. е. участникам не было дано объяснений того, почему заголовок может быть правдой или ложью).

Источник:

https://econtent.hogrefe.com/doi/10.1027/1016-9040/a000492