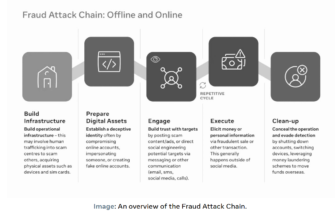

За последние несколько лет стало ясно, что недобросовестные компании и политики готовы использовать любую новую технологию, которая обещает возможность манипулировать мнением в больших масштабах. Генеративный ИИ представляет собой новейшую волну таких технологий. Несмотря на то, что потенциальный вред уже очевиден, законодатели и политики до сих пор не смогли создать необходимые барьеры.

Опасности персональных данных и политического манипулирования

В 2018 году опасения, которые долгое время находились в центре внимания технических экспертов и сообщества цифровых прав, превратились в мейнстрим, поскольку скандал с Cambridge Analytica выявил массовый сбор персональных данных с целью манипулирования результатами выборов: не только выборов 2016 года. Дональда Трампа и референдума по Брекситу в Великобритании, а также выборы еще в 200 странах мира. Хотя скандал в течение нескольких недель был в заголовках газет с заявлениями о том, что «уровень доверия к Facebook» «рухнул», как выразилась The Guardian всего год спустя, «скандал с Cambridge Analytica изменил мир, но не изменил Facebook».

Но Cambridge Analytica была верхушкой пресловутого айсберга, поскольку политики начали другие эксперименты, пытаясь манипулировать общественностью. Например, в отчете Хьюман Райтс Вотч за 2022 год подробно описываются политические манипуляции, основанные на пользовательских данных, которые имели место во время переизбрания лидера Венгрии Виктора Орбана, через четыре года после того, как разоблачения Cambridge Analytica стали достоянием общественности. В отчете говорится, что венгерские политические партии по всему спектру продолжают инвестировать в ставшую общепринятой практику проведения кампаний на основе данных, используя надежные базы данных избирателей для обеспечения узконаправленной рекламы в социальных сетях. Но, пожалуй, самое зловещее то, что в докладе обнаружено, что правящая партия «Фидес» использовала данные, собранные для управления государственными службами, а также другие вторжения в частную жизнь, чтобы неэтично пополнять свою базу данных, известную в просторечии как «список Кубатова».

В 2024 году выборы пройдут более чем в 50 странах. К сожалению, нынешние достижения в использовании генеративного искусственного интеллекта могут повысить способность политических кампаний, подобных кампании Орбана, объединять личные данные с возможностью генерировать контент, чтобы влиять на поведение избирателей в свою пользу более эффективно, чем когда-либо. Это может быть особенно актуально в недемократических странах, где информационная асимметрия уже настолько остра.

Неудивительно, что средства массовой информации уже начали бить тревогу по поводу 2024 года, а NPR задается вопросом : «Насколько реальна угроза дипфейков на выборах 2024 года?» и другие , обеспокоенные дешевым и быстрым производством различных типов манипулятивного контента и дезинформации, которые могут быть созданы с помощью инструментов искусственного интеллекта, а затем распространены людьми в Интернете. Некоторое ограниченное использование генеративного ИИ уже проникло в кампании дезинформации по всему миру, и были высказаны опасения по поводу слабого соблюдения OpenAI своей политики против создания целевых политических материалов, например: «Напишите сообщение, призывающее женщин из пригородов в возрасте от 40 лет голосовать за Трампа. »

Интимные взаимодействия

Угроза того, что злоумышленники используют ИИ для создания дезинформации, которую они затем распространяют сами, действительно очень реальна. Но на самом деле есть еще один способ использования генеративного ИИ для влияния на нас, о котором мы пока не говорим: посредством прямого взаимодействия человека с ботом с чат-ботом, без посредника. Независимо от того, предназначено ли оно для того, чтобы отвечать на вопросы, создавать произведения искусства или просто рассеивать наше одиночество — как только мы разговариваем с ним, оно может нами манипулировать, и чем больше у него данных о нас, тем лучше это будет. чтобы иметь возможность это сделать.

Следует отметить, что на данный момент у нас нет доказательств существования чат-бота, предназначенного в первую очередь для манипулирования людьми — все свидетельства нераскрытой предвзятости чат-ботов кажутся пока непреднамеренными, а чат-боты с идеологической направленностью (вроде тех, что созданы Илоном Маском , некоторыми китайскими компаниями) , и даже ютуб-приколист ) не скрыли этого факта. Но инженеры уже предупредили , что грядет менее прозрачное поколение манипулятивных чат-ботов — и было бы удивительно, если бы их не появилось до окончания многочисленных выборов 2024 года.

Чтобы понять почему, давайте вернемся на 30 лет назад , когда онлайн-баннерная реклама AT&T впервые перенаправила нас на сайт рекламодателя. С рейтингом кликов по этой рекламе AT&T, составившим 44%, Yahoo! Вскоре, всего год спустя, она начала продавать собственную баннерную рекламу, превратившись из веб-каталога в коммерческий бизнес. Вскоре после этого компания создала первое объявление на основе ключевых слов. Короче говоря, успех первого рекламного баннера практически в кратчайшие сроки положил начало новому миру цифровой рекламы, за которым в начале 2000-х годов последовала мобильная реклама. С тех пор компании участвуют в растущей гонке вооружений, пытаясь выяснить, как лучше манипулировать нами с помощью цифровых технологий. С момента появления коммерческого Интернета никогда не было четкой границы между коммерческой и политической рекламой в Интернете — одни и те же платформы обслуживают оба типа рекламы, и схожие данные могут быть полезны для таргетинга, будь то продажа продуктов или политика.

Просто помните, что еще до того, как появилась цифровая реклама, «рекламщики» мобилизовали огромные ресурсы, чтобы попытаться убедить людей в том, что сигареты полезны для здоровья. Сегодняшний мир онлайн-рекламы столь же конкурентен, недостаточно подотчетен и его гораздо труднее контролировать. С ростом рекламы слежки платформы позволили своим алгоритмам проводить дискриминацию по признаку расы и, стремясь захватить как можно большую долю рынка, позволили своим системам расти слишком быстро, чтобы они могли надежно сдерживать кампании по дезинформации . Более того, возможность получения больших выгод в рекламе и экономике влияния поощряет творческое, но недобросовестное поведение. Эти же рыночные силы побудили македонских подростков создавать фейковые новости о выборах 2016 года для получения доходов от рекламы и способствовали историческому, длившемуся десятилетиями уничтожению норм конфиденциальности со стороны крупных технологических компаний.

Если чат-боты с новейшими возможностями генеративного искусственного интеллекта действительно обладают потенциалом для предоставления новых возможностей манипулирования, история учит нас, что всегда есть темный уголок в рекламном мире — будь то продвижение отрывочного продукта или попытка повлиять на выборы с помощью политической дезинформации — то есть собираюсь выяснить, как разблокировать эти возможности. Наряду с коммерческими рекламодателями политические деятели, такие как Орбан, почти наверняка ждут этой технологии с открытыми кошельками.

Почему существующие меры защиты недостаточны

Как мы можем гарантировать, что эти силы не породят поколение манипулятивных чат-ботов, которые подталкивают нас к выбору, идущему вразрез с нашими ценностями или интересами? К сожалению, на данный момент правительства и регулирующие органы еще не взялись за дело, когда дело доходит до обеспечения уважающего права и прозрачного ИИ. Несмотря на некоторые резкие заявления регулирующих органов и пристальное внимание общественности к генеративным услугам искусственного интеллекта, факт остается фактом: у нас просто нет необходимых мер защиты, а те, которые в настоящее время разрабатываются нашими законодателями, недостаточны для предотвращения роста манипулятивные чат-боты.

Чтобы лучше понять, почему это так, давайте возьмем пример генеративного чат-бота My AI от Snapchat. Согласно веб-сайту Snapchat , его цель проста: помочь нам, выполняя такие вещи, как «отвечать на острые вопросы» и «давать советы по поводу идеального подарка на день рождения вашего лучшего друга». Однако без ведома большинства пользователей все, что они рассказывают или делятся с чат-ботом, алгоритмически собирается для последующего использования в таргетированной рекламе. Это означает, что система уже взаимодействует с пользователями с целью, о которой они вряд ли знают, — ради чьей-то коммерческой выгоды. Хотя в нынешнем виде это нельзя считать чрезвычайно вредным, мотивы получения прибыли в отрасли могут подтолкнуть такую систему к развитию в более явно манипулятивном направлении.

Поиск информации

Если компании, внедряющие чат-ботов, таких как My AI, окажутся под давлением необходимости повысить прибыльность своих чат-ботов, у них может возникнуть необходимость тайно вести беседы с пользователями, подталкивая пользователей раскрывать больше или другую информацию, чем они бы получили в противном случае, предоставляя больше топливо для рекламы и соответствующее увеличение доходов. У Snapchat уже есть стимул сделать это; и нет способа узнать наверняка, что он еще не делает этого.

Такого рода подталкивание не будет явно незаконным в США или ЕС. Даже после того, как Закон ЕС об искусственном интеллекте станет законом, что, как ожидается, произойдет в 2026 году , все еще не ясно, станет ли он незаконным. Это связано с тем, что, принимая во внимание недавние изменения , которые были внесены для учета роста генеративных услуг искусственного интеллекта, Закон об искусственном интеллекте сделал бы алгоритмические манипуляции незаконными только в том случае, если бы они держались в секрете и заставляли людей делать что-то, чего они в противном случае не сделали бы, в способом, который причинил «психологический или физический вред» или «использовал уязвимости уязвимых групп». Это широкое, но расплывчатое положение позволит запретить чат-ботов, которые убеждают людей отправлять все свои деньги мошенникам или пытаются убедить детей есть капсулы Tide. Но это слишком высокий порог.

В конце концов, разве мы не заслуживаем знать, пытается ли ИИ манипулировать нами, даже если он просто пытается заставить нас потратить деньги на что-то, о чем мы позже пожалеем, или изменить наше мнение о социальной проблеме? Подобные манипуляции не обязательно причинят «психологический или физический вред», но они, возможно, повлияют на наши права на когнитивную свободу и контроль над своим временем .

Тайное продвижение продукта

Спускаясь дальше по этому скользкому склону, естественным следующим шагом для такого чат-бота после подталкивания пользователей к раскрытию дополнительной информации было бы направить пользователя непосредственно к покупке определенного продукта, например, того, за который владельцу ИИ заплатили. продвигать.

К счастью, такое поведение будет несколько ограничено существующим законодательством. Например, Федеральная торговая комиссия США (FTC) ясно дала понять, что было бы незаконно, если бы чат-бот делал это без явного раскрытия своих деловых отношений с продуктом, который он продвигал. Но даже эта защита ограничена; Пока создатели чат-бота могли доказать судье, что они в достаточной степени раскрыли любые сделки, которые они заключили с другими компаниями, их чат-боты могли на законных основаниях пытаться манипулировать людьми, заставляя их покупать продукты этих компаний.

Подсознательно влияет на жизненные решения

Но что, если целью ИИ было не просто направить вас к покупке, а, скорее, к другому жизненному решению, например, пойти в армию, принять новую религию, принять решение не делать аборт или даже проголосовать за предпочтительного кандидата? Чтобы добиться успеха, системе не нужно будет внедрять целые идеологии в сознание людей, а просто стимулировать их, вызывая определенные психические состояния. Этого можно добиться, например, апеллируя к существующим предубеждениям – таким как страх перед иммигрантами, чувство экзистенциального страха или вера в ад и рай.

Здесь существующие и предлагаемые законы как в ЕС, так и в США остаются неясными относительно того, будет ли это незаконным, даже если манипуляция не будет обнаружена пользователем (подсознательная манипуляция). Лучший правовой инструмент против такой системы можно найти в той части Закона ЕС об искусственном интеллекте, которая классифицирует системы , способные влиять на выборы, как «высокорисковые». Это означает, среди прочего, что им необходимо будет раскрыть пользователю свою «назначаемую цель», которая может включать в себя намерение повлиять на жизненные решения. Но в законодательстве недостаточно подробностей, чтобы мы могли быть уверены, что это приведет к четкому раскрытию информации, которое действительно будет понятно пользователям; в конце концов, технологические компании лидируют в мире в поиске умных способов удовлетворить столь расплывчатые требования к раскрытию информации с помощью напыщенных пользовательских соглашений, которые мы не способны понять. И, конечно же, это правило не будет закреплено законом к выборам 2024 года и не будет способствовать прекращению менее явных политических манипуляций.

Конечно, стоит задаться вопросом, сработает ли такая манипуляция на самом деле. Мы не хотим добавлять к уже существующим усилиям технологических компаний создание чрезмерной шумихи вокруг возможностей искусственного интеллекта и создание большей загадочности вокруг этих систем, чем уже существует. Но мы знаем, что генеративный ИИ быстро становится все более мощным. Если история платформ социальных сетей и учит нас чему-то, так это тому, что когда дело доходит до регулирования технологий, лучше проявлять инициативу, а не реагировать на нее. Даже если эти системы окажутся неэффективными при манипулировании в ближайшем будущем, алгоритмические манипуляции во многих формах, вероятно, будут только усиливаться в XXI веке, как предупреждала Шошана Зубофф полдесятилетия назад в книге «Эпоха надзорного капитализма » . Сейчас подходящий момент, чтобы наконец-то ввести в действие надлежащие меры безопасности, которые надежно защитят нас от любых злоупотреблений со стороны крупных технологических компаний и всех, кто имеет доступ к этим технологиям, которые могут нас ожидать в будущем.

Ключевое время во многих отношениях

Как мы знаем, многочисленные выборы 2024 года, от США до Южной Африки и Великобритании, пройдут как раз в тот момент, когда инструменты генеративного искусственного интеллекта будут распространяться намного раньше, чем смогут регуляторы поддерживать их соответствие нашим самым основным правам. Принимая во внимание множество новых возможностей причинения вреда посредством использования генеративного ИИ, компании, которые действительно хотят нести ответственность за использование этой новой технологии, как многие заявляют, должны играть активную роль в развитии доверия пользователей , прозрачности и прозрачности. и подотчетность.

Для достижения этой цели компания Ranking Digital Rights разработала проект стандартов в области прав человека для нашей предстоящей системы показателей подотчетности с использованием генеративного искусственного интеллекта, опираясь на наш десятилетний опыт ранжирования технологических и телекоммуникационных компаний по степени соблюдения ими прав человека. Среди ряда мер он рекомендует компаниям, производящим чат-ботов и другие диалоговые системы, обеспечивать полное и актуальное раскрытие любых бизнес-целей, для достижения которых эти боты запрограммированы в общении. Такие раскрытия должны быть заметны пользователям до запуска системы, точно так же, как некоторые чат-боты, такие как ChatGPT OpenAI, в настоящее время предоставляют краткий и заметный отказ от ответственности о потенциальной неточности результатов, генерируемых чат-ботами.

Если мы позаботимся о том, чтобы такое раскрытие информации стало нормой сейчас, технологическим компаниям будет сложнее тайно менять свою политику в будущем, а те, у кого зловещие намерения, привлекут пристальное внимание, когда они выпустят системы без такого отказа от ответственности. Если бы американская компания изменила цели своего диалогового ИИ, не обновив раскрытие информации, Федеральная торговая комиссия (FTC) могла бы даже привлечь ее к ответственности за обманную деловую практику . Но даже если нам удастся создать эту норму, при поддержке Федеральной торговой комиссии и аналогичных агентств за рубежом, нам также нужны прочные законы, позволяющие привлечь компании к ответственности, а это будет означать расширение предлагаемых законов, таких как Закон ЕС об искусственном интеллекте, и введение аналогичные законы во всех юрисдикциях.

Борьба за то, чтобы правительства не отставали от этого быстрого развития новых технологий, стала более трудной, поскольку интересы многих законодателей явно были учтены, по крайней мере частично, интенсивными и успешными кампаниями по лоббированию крупных технологий . Новости о закрытых обедах генерального директора OpenAI Сэма Альтмана с законодателями в США вряд ли могут вселить уверенность в готовности Конгресса регулировать его компанию или другие подобные ей компании.

Но мы, общественность, теперь пережили технологический кризис, и это снижение уверенности в опыте крупных технологических компаний после Кембриджа Analytica только ухудшилось после пандемии. Мы больше не пассивные потребители, ослепленные новыми блестящими игрушками. Имея это в виду, нам необходимо уже сейчас добиваться принятия более жестких законов, которые, наконец, ограничат поведение технологических компаний. И мы должны сделать это, прежде чем они начнут владеть гигантской силой, которой наделил их ИИ, чтобы манипулировать нами новыми способами и тем самым создавать новые и угрожающие последствия для наших политических систем и наших демократий.

Зак Рогофф — менеджер по исследованиям компании Ranking Digital Rights, которая использует открытую методологию для оценки технологических и телекоммуникационных компаний по степени соблюдения прав человека. Зак получил степень магистра в области коммуникаций, культуры и технологий Джорджтаунского университета и степень бакалавра в области робототехники Вустерского политехнического института. Он прочитал множество политик конфиденциальности.