Чтобы препятствовать вводящим в заблуждение новостям, которые с безрассудной энергией распространяются через социальные сети, может потребоваться новый подход – или несколько из них.

У этой проблемы было много названий с тех пор, как президентские выборы в США в 2016 году впервые привлекли к ней широкое внимание — от «фейковых новостей» до «инфодемии» во время пандемии Covid-19 и «дезинформации»/ «недостоверной информации» (misinformation) во множестве научных исследований. Несмотря на это, эта токсичная смесь путаницы, неверного направления, манипуляций и откровенной лжи теперь угрожает как общественному здравоохранению, так и нашей коллективной вере в демократические выборы, не говоря уже о каком-либо общем понимании истины.

Однако когда дело доходит до решений, «это очень сложная проблема», — говорит Джевин Уэст, биолог, ставший ученым-информатиком из Вашингтонского университета в Сиэтле и соавтор широко используемого курса по информационной грамотности «Назовем чушь» (Calling Bullshit)(1). Это особенно сложно, если учесть, что большая часть борьбы с дезинформацией приходится вести на платформах социальных сетей, таких как Facebook, YouTube и X (ранее известный как Twitter), которые находятся в частных руках.

Обычно эти компании решают проблему с помощью проверки фактов в наиболее широко распространяемых сообщениях. Но чрезвычайно сложно контролировать миллиарды постов в день, когда они сталкиваются с злоумышленниками, которые стали опытными во всех видах высокотехнологичных фальсификаций. Набор инструментов варьируется от программных «ботов», которые могут генерировать миллионы фальшивых профилей пользователей и фальшивых новостных сообщений, до новейших чат-ботов на базе искусственного интеллекта (ИИ), которые могут обмануть людей, заставив их думать, что они разговаривают с другим человеком. И, конечно же, платформам приходится осуществлять свою охрану в сегодняшней среде культурной войны, где любая попытка проверить факты или модерировать дискуссию мгновенно осуждается как заговор с целью навязать какую-то идеологическую программу.

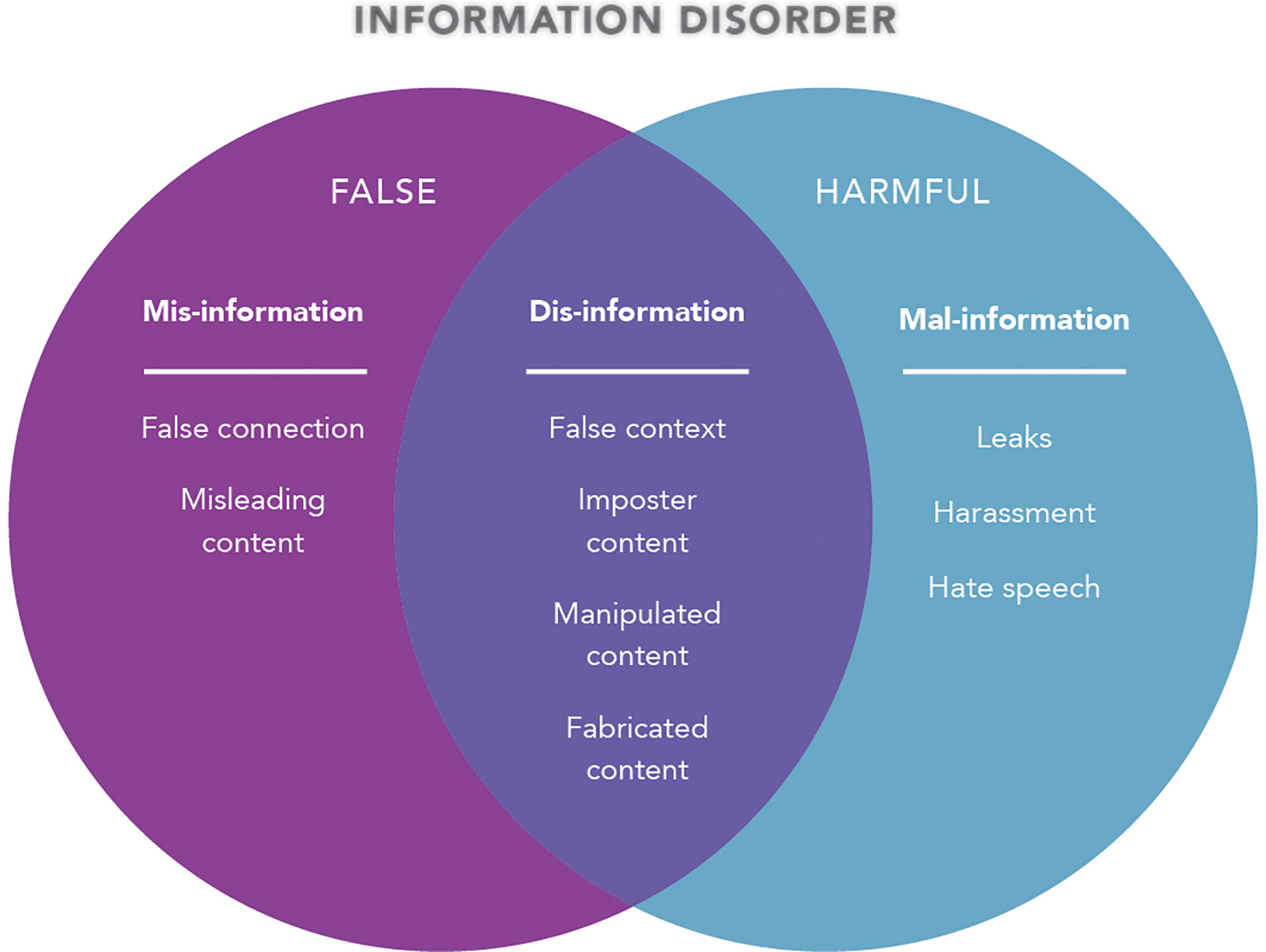

Существуют тонкие различия между типами распространяемой вводящей в заблуждение информации. Изображение предоставлено: Люси Ридинг-Икканда (художник), изменено с https://rm.coe.int/information-disorder-toward-an-interdisciplinary-framework-for-researc/168076277c.

Хорошей новостью является то, что в последние годы наблюдается огромный поток исследований по проблеме дезинформации. «Это очень быстро меняющееся пространство», — говорит психолог Нью-Йоркского университета Джей Ван Бавел. «Каждую неделю или две выходит еще одна большая газета». И по мере того, как исследователи начинают лучше понимать, почему люди верят и делятся дезинформацией, они начали придумывать решения следующего поколения, которые платформы могут развертывать в больших масштабах, и которые не говорят людям, что им думать (2, 3). Примеры включают краудсорсинговые рейтинги точности, подсказки, которые побуждают пользователей больше думать о точности, прежде чем делиться чем-либо, и даже своего рода мысленную прививку от распространенных методов обмана. Пока никто не претендует на полное решение. Но исследователи начали экспериментировать с комбинациями этих методов, позволяя вмешательствам усиливать друг друга и становиться более эффективными, чем любой из них по отдельности. И в этой работе мы можем начать видеть очертания масштабируемой, основанной на фактических данных системы «общественного здравоохранения», которая могла бы предотвратить безудержное распространение чумы дезинформации.

Ваш мозг в социальных сетях

На первый взгляд можно задаться вопросом: «Зачем вообще беспокоиться о полиции?» Почему бы просто не позволить всем увидеть все, чтобы они могли принять собственное решение? Распространенный ответ: ни у кого нет времени, опыта или смелости разобраться в бесконечном потоке токсичности, преследований и чепухи. Если платформа не приложит никаких усилий для модерации дискуссии – как это делают практически все авторитетные платформы – разумные пользователи уйдут. Но еще одна часть ответа заключается в том, что сегодняшняя среда социальных сетей редко является нейтральным форумом для дискуссий. Часто платформы активно поощряют распространение дезинформации — настолько сильно, что некоторые пользователи регулярно делятся сообщениями, которые на самом деле противоречат их политическим взглядам. Например, в ходе одного недавнего лабораторного эксперимента было обнаружено, что самопровозглашенные постоянные пользователи социальных сетей делятся в восемь раз больше дезинформации, чем самопровозглашенные случайные пользователи (4). По словам руководителя группы Гизема Джейлана, постдока Йельской школы менеджмента, в ходе эксперимента (всего включавшего четыре исследования) более внимательно изучили этих привычных пользователей и обнаружили, что все лайки, репосты и комментарии их посты, казалось, вызывали у них прилив эмоционального подтверждения, сродни перекусу с высоким содержанием сахара. И их жажда к этим психическим вознаграждениям уже давно научила их делиться такими публикациями, которые получили самый сильный отклик, и которые, вероятно, не были тщательно проверенными фактами статьями из The New York Times. Вместо этого они научились публиковать неожиданные, эмоционально заряженные, привлекательные или раздражающие материалы против людей, которых они и их друзья презирают: «контент, который точно отражает характеристики ложной информации», — говорит Джейлан, и что показали другие исследователи. распространится дальше и быстрее, чем правда (5). Платформы социальных сетей действительно пытаются помешать по крайней мере некоторым мошенникам, теоретикам заговора и демагогам, которые поставляют эти очень кликабельные фейки. По словам ученого-компьютерщика из Университета Индианы Филиппо Менцера, который последнее десятилетие посвятил разработке инструментов для обнаружения и картирования активности ботов и других технологий онлайн-обмана, крупные платформы, такие как Facebook, YouTube и (до Илона Маска) Twitter, регулярно разрушают сотни секретных, но хорошо скоординированных «информационных операций», которые часто используются политиками, правозащитными группами и иностранными игроками для посеяния разногласий и дезинформации. К сожалению, добавляет Менцер, платформы не так жестко относятся к «суперраспространителям», которые даже не пытаются спрятаться. «Много вреда и много дезинформации распространяют не неизвестные боты, а известные, даже проверенные пользователи», — объясняет он. Часто это влиятельные лица, представители элиты, политики или знаменитости, которые зарабатывают деньги, продвигают политическую повестку дня, борются за какое-то дело или выступают против вакцин. «И платформы очень неохотно их удаляют, потому что у этих людей много подписчиков, а это значит, что они привлекают много внимания, а платформы зарабатывают на них много денег от рекламы», — говорит Менцер. Вместо этого большинство крупных платформ социальных сетей в значительной степени полагаются на проверку фактов, которая превратилась в глобальную индустрию с профессиональными стандартами беспристрастности, а также прозрачности источников, методологии и финансирования. Facebook, например, отправит свои самые популярные и широко распространенные публикации на оценку одному из своих 90 международных партнеров по проверке фактов. Сообщения, которые эти фирмы считают ложными или вводящими в заблуждение, затем помечаются как таковые и понижаются в ленте новостей Facebook, чтобы их могло видеть меньшее количество пользователей.

Но проверка фактов имеет свои пределы и должна проводиться осторожно, отмечает Менцер. Если вы не будете подчеркивать то, что верно, вместо того, чтобы повторять ложное утверждение, говорит он, «тогда люди будут помнить это утверждение, а не то, что оно было ложным», и усилия будут иметь неприятные последствия. Тем не менее, независимые исследователи подтвердили, что осторожность

Созданные вами разоблачающие ярлыки оказывают реальный и продолжительный эффект (6). «Просто навешивать на что-то ярлык «неправда» — это очень важно», — говорит Дэвид Рэнд, ученый-когнитивист из Массачусетского технологического института в Кембридже, штат Массачусетс. «Это действительно снижает веру и распространение этого поста». В одном недавнем эксперименте по проверке фактов, проведенном с пользователями в Аргентине, Нигерии, Южной Африке и Великобритании, это снижение убеждений составило как минимум 0,59 балла по 5-балльной шкале — даже через 2 недели или более (7). Несмотря на это, в мире недостаточно профессиональных фактчекеров, чтобы проверять миллиарды сообщений в день. И даже если бы они были, — отмечает Гордон Пенникук, психолог из Университета Реджайны в Саскачеване, Канада, — «вы всегда заклеиваете вещи: разоблачить что-то можно только тогда, когда оно уже распространилось и стало известно».

Когнитивная прививка

Чтобы ограничить это распространение, некоторые исследователи пытаются помочь пользователям самостоятельно распознавать дезинформацию. Как минимум, говорит Сандер ван дер Линден, психолог из Кембриджского университета в Соединенном Королевстве, «нам необходимо дать людям возможность выявлять манипуляции по мере их возникновения, чтобы они могли принимать действительно обоснованные решения» о том, чем делиться, чем купить или даже чему верить. Хотя курсы цифровой грамотности, такие как «Призывная чушь» Вашингтонского университета, справляются с этой задачей хорошо, говорит ван дер Линден, он и его коллеги работают над более быстрыми и более широко применимыми методами, вдохновленными десятилетиями исследований психологической формы прививки. Эта когнитивная прививка, также известная как упреждающее разоблачение или «предварительное разоблачение», действует как настоящая вакцина, говорит он: «Вы подвергаете людей ослабленной дозе лжи или методам, которые используются для создания лжи, чтобы люди могли выработать ментальные антитела для нейтрализации дезинформации в будущем» (8). А поскольку невозможно заранее опровергнуть каждую ложь, распространяющуюся, скажем, об изменении климата или иммиграции, и поскольку (авторитетные) платформы социальных сетей не хотят выступать в роли арбитров истины, лучшая стратегия, утверждает он, — это пойти на широкую Вакцина -спектра — предварительная вакцинация, в которой основное внимание уделяется методам манипуляции. «Мы знаем о любимых трюках плохих парней еще со времен Аристотеля», — говорит ван дер Линден. Фальшивые эксперты, ложные дилеммы, нападки ad hominem, фальшивые дергания за струны сердца, нагнетание страха против удобных козлов отпущения — «все это вводит в заблуждение как левые, так и правые». В 2019 году ван дер Линден и психолог из Кембриджа Джон Рузенбек проверили предварительную дезинформацию с помощью Bad News — ролевой игры, в которой игроки знакомились с этими методами манипуляции, а затем получали баллы за создание убедительной кампании по дезинформации и привлечение последователей (9 ). Тесты «до» и «после» показали, что игра дала игрокам возможность распознавать дезинформацию в реальной жизни на 20–25%, говорит ван дер Линден, причем эффект длился как минимум 7–10 дней. По его словам, как только эксперименты были завершены, команда сделала игру бесплатной и общедоступной в Интернете, «и она стала вирусной на Reddit. К нему пришло так много пользователей, что нам пришлось покупать больше облачного пространства». «Если вы сможете просто заставить людей задуматься о точности, они с меньшей вероятностью будут делиться плохим контентом». Когда разразилась пандемия, команда запустила аналогичную игру Go Viral, предназначенную специально для прививки игроков от дезинформации о COVID-19, говорит ван дер Линден. По словам ван дер Линдена, при поддержке правительства Великобритании, Всемирной организации здравоохранения и ООН игра получила более 200 миллионов просмотров в социальных сетях. Однако каким бы обнадеживающим ни был этот ответ, на создание игр уходило как минимум 5–20 минут (вечность в социальных сетях), и как только игры выходили из лаборатории, они в основном привлекали людей, которые уже были открыты для их сообщений. Поэтому Рузенбек, ван дер Линден и другие разработали вмешательство с более широким охватом (10). Сотрудничая с Google, они создали серию двухминутных видеороликов, в которых используются юмор и отсылки к поп-культуре, чтобы проиллюстрировать шесть наиболее распространенных техник манипуляции. В одном примере они изображают своего рода ложную дихотомию, часто используемую для подталкивания людей к экстремизму. В отрывке из «Звездных войн: Эпизод III: Месть ситхов» Энакин говорит: «Если ты не со мной, то ты мой враг!» Оби-Ван отвечает, что «только ситхи имеют дело с абсолютами!» Рассказчик видео завершает словами: «Никто не хочет быть ситхом». По словам ван дер Линдена, после тщательной доработки в лаборатории видео были протестированы в полевых условиях, поместив их во временные интервалы, которые обычно используются для рекламы на платформе Google YouTube. По его словам, эта кампания была адресована миллионам реальных пользователей YouTube, «и мы смогли случайным образом выбрать около 30%, которым будет показано либо наше видео о лечении, либо контрольное видео об ожоге морозом». Затем, примерно через 18 часов, люди, просмотревшие видео о лечении, на 5–10% лучше, чем контрольная группа, распознавали эту технику манипуляции в тесте.

Это не преобразующее изменение. Но хорошо, что YouTube широко распространил эти видео в некоторых частях Европы и других странах. И хотя это правда, что эффект со временем ослабевает, говорит ван дер Линден, команда подтвердила, что предоставление людям «ускоренной прививки» в виде короткого видео-напоминания может поддерживать когнитивный иммунитет как минимум на 3 месяца (самый длительный период). период времени, который они тестировали). Думайте больше, делитесь меньше Тем не менее, прививка сама по себе окажет лишь ограниченное влияние на проблему дезинформации. Во всяком случае, говорит Джейлан, «это возлагает на человека большую ответственность» в отличие от алгоритмов социальных сетей, которые обеспечивают психическое вознаграждение, когда пользователи делятся дезинформацией. «Я не думаю, что поведение пользователей действительно изменится, если мы не внесем структурные изменения в этот механизм вознаграждения», — говорит она. Вот почему другое направление исследований дезинформации пытается подтолкнуть пользователей социальных сетей к тому, чтобы они меньше сосредотачивались на вовлеченности, когда они чем-то делятся, и больше на точности — или, как Уэст выразил это в наклейке, которую он раздает своим студентам: «Думайте больше, делитесь меньше». » Когда вы просите пользователей остановиться и подумать, как это сделали Рэнд и Пенникук в 2019 году, они на удивление хорошо оценивают точность публикации — независимо от принадлежности к политической партии. Рэнд говорит: «Если вы спросите 15–20 случайных пользователей Facebook: «Насколько это кажется точным?», а затем усредним их ответы, они хорошо справятся с воспроизведением того, что придумал бы профессиональный фактчекер» (11). По словам Рэнд, это согласуется с обширной литературой о мудрости толпы и предполагает, что краудсорсинг может стать для платформ надежным способом маркировать неточный контент и преодолеть проблему масштабирования до профессиональной проверки фактов. В 2021 году Рэнд, Пенникук и их коллеги расширили этот образ мышления до подсказок, которые они называют «подсказками о точности» (12). Опять же, говорит Рэнд, эта идея согласуется с предыдущими исследованиями в области психологии об эффекте прайминга: «Если вы можете просто заставить людей задуматься о точности, то они с меньшей вероятностью будут делиться плохим контентом». И это даже не сложно, говорит он: все, что вам нужно, это всплывающее окно с просьбой, скажем, оценить точность случайного заголовка или указать, важна ли для них точность – все, что заставит их задуматься об истине. Группа подтвердила результаты своей лабораторной работы с помощью реального исследования, в ходе которого более 5300 пользователей Твиттера (до Маска) попросили оценить точность одного неполитического заголовка. В последующие 24 часа твиты, которыми поделились эти пользователи, демонстрировали определенный перекос в сторону источников, которые независимые специалисты по проверке фактов уже оценили как более надежные, таких как CNN и The New York Times, и в сторону от тех, которые считаются менее надежными, таких как Breitbart. и The Daily Caller. Последующие эксперименты подтвердили, что точные подсказки сокращают распространение плохого контента примерно на 10 % — не так уж и драматично, говорит Рэнд, но это того стоит, и платформы легко реализуют на регулярной основе (13). Тем временем в Научно-исследовательском институте Госпиталя дель Мар в Барселоне нейробиолог Клара Претус вместе с Ван Бавелем из Нью-Йоркского университета и другими провели предварительные испытания более прямого стимула к точности: предоставление пользователям кнопки для пометки сообщений как «вводящих в заблуждение» (14). По словам Претуса, в лабораторном эксперименте с примерно 2500 пользователями из США и Великобритании 25% сообщили, что большое количество вводящих в заблуждение людей снизит вероятность того, что они поделятся публикацией — с одной важной оговоркой. «Вероятно, это очень хорошо работает для населения в целом», — говорит она, но может легко иметь неприятные последствия для пользователей, находящихся на крайних концах политического спектра. По словам Претус, в более раннем исследовании более 1600 пользователей социальных сетей в США и Испании (15) она и ее соавторы обнаружили, что эти крайне политизированные люди были одними из самых активных распространителей дезинформации. «Это вопрос идентичности», — говорит она. «Они используют это не только как способ агитировать за свое дело, но и чтобы показать, что они являются частью своей группы». Но это также делает их самыми недоверчивыми из неверующих. «Поэтому важным аспектом нашего текущего вмешательства является то, что пользователи видят только «вводящие в заблуждение» теги от других людей в своей группе», — говорит она. По ее словам, с учетом этого ограничения теги кажутся весьма эффективными. Сейчас она и ее коллеги работают над следующим шагом: тестированием метода на реальных пользователях в реальной среде социальных сетей.

Глубокая защита

Широко распространено мнение, что ни одно из этих вмешательств само по себе не является панацеей от дезинформации. Путь вперед — найти методы, сочетающие разоблачение, предварительное разоблачение, повышение точности и многое другое. Один предварительный пример можно найти в неопубликованном исследовании, совместно финансируемом Google, говорит ван дер Линден: «Оно предполагает, что, когда видео о прививках чередуются с подсказками точности, эффекты обоих вмешательств усиливаются. Другой пример: Уэст недавно объединился с коллегами из Вашингтонского университета для разработки компьютерного моделирования, которое рассматривает распространение дезинформации как своего рода заразу и калибрует реальные данные на расстоянии 10,5 миль.

миллионов дезинформационных твитов во время выборов 2020 года. «Это очень простая модель», — говорит Уэст. «Но он отлично справляется с задачей улавливания динамики, которую мы видим в реальных данных», например, всплеска активности, когда сообщение становится вирусным. После этого он и его коллеги использовали симуляцию для моделирования эффекта потенциальных вмешательств, таких как проверка фактов, подталкивание к точности или полная приостановка наиболее активных суперраспространителей, и обнаружили, что при использовании в комбинации эти вмешательства могут усиливать друг друга. и сократить общий объем дезинформации на 50% и более (16). Но эта скоординированная защита не является чем-то, что люди могут сделать сами по себе, говорит Уэст: необходимость в каких-то скоординированных действиях со стороны правительств, компаний и других институтов уже давно стала неизбежной. Это особенно актуально, учитывая поразительные достижения в области генеративного искусственного интеллекта. Эта категория алгоритмов включает в себя невероятно реалистичные «дипфейки» — изображения, видео и аудиофайлы, которые практически невозможно отличить от реальных, — а также столь же реалистичный текст и разговоры, основанные на ChatGPT. «ИИ сейчас демократизирует создание пропаганды», — говорит ван дер Линден. «Любой, у кого есть доступ к Интернету, может использовать ChatGPT для автоматизации кампании по масштабному обману людей», — говорит он, — и даже осуществлять массовый микротаргетинг, передавая ИИ легкодоступные данные о просмотрах и приказывая ему адаптировать манипулятивное сообщение для каждого человека. Крупные социальные сети действуют осторожно, не желая делать ничего, что могло бы повредить их вовлеченности (и, следовательно, их доходам от рекламы), говорит Джейлан. Но у авторитетных компаний все еще есть сильный стимул держать ситуацию под контролем, отмечает она. Согласно ее исследованию, большинство людей говорят, что они не решаются делиться публикациями или делиться ими, и что становится все труднее понять, какая информация является правдивой, а какая ложной. «Если мы сможем создать среду, в которой люди смогут быть уверены в том, что информация, которую они видят, будет точной, — говорит Джейлан, — я думаю, это повлияет на взаимодействие скорее положительно, чем отрицательно».