Распространение дезинформации представляет собой серьезную проблему для общества во всем мире. Например, известно, что злонамеренные слухи иногда приводят к беспорядкам со смертельным исходом, а вера в дезинформацию связана с уменьшением вероятности вакцинации (например, против COVID-19). Поэтому исследователи искали эффективные способы противодействия вере людей в дезинформацию и обмену ею. В дополнение к развенчанию дезинформации после ее распространения новое направление исследований направлено на то, как мы можем в первую очередь предотвратить попадание пользователей социальных сетей на дезинформацию: подход, известный как предварительное разоблачение (prebunking).

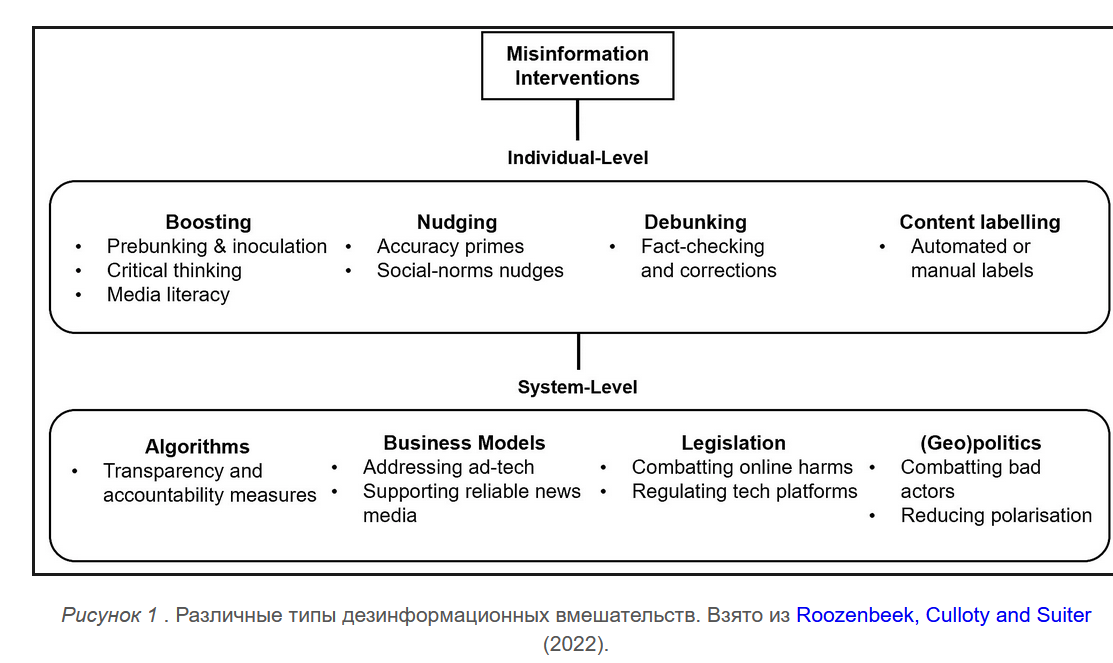

В недавней статье мы рассмотрели доказательства, лежащие в основе вмешательств, направленных на противодействие дезинформации. Мы разделяем их на две широкие категории: вмешательства на индивидуальном уровне и на уровне системы .

Эти категории вмешательств работают параллельно друг с другом в сложной новостной среде, и у каждой есть свои плюсы и минусы. Вмешательства на системном уровне, как правило, наиболее эффективны; например, немецкий NetzDG (или Закон о защите прав в сети) обязывает платформы социальных сетей удалять «явно незаконный» онлайн-контент. Однако, хотя вмешательства на системном уровне могут быть эффективными в борьбе с дезинформацией и разжиганием ненависти, они также сопряжены со значительными рисками. Немецкий закон подвергся критике за то, что социальные сети стали арбитрами того, какой контент разрешен, а какой должен быть удален. Уравновешивание эффективности с демократическими идеалами остается важной задачей для вмешательств на системном уровне.

Хотя вмешательства на индивидуальном уровне вряд ли нанесут вред, не всегда ясно, насколько хорошо они работают в реальном мире.

Вмешательства на индивидуальном уровне не имеют этой проблемы. Например, сообщение кому-либо о том, что новость является ложной, не нарушает его право на самовыражение. Верно и то, что среди педагогов, активистов, регулирующих органов и широкой общественности существует значительный спрос на материалы, помогающие людям ориентироваться в онлайн-пространстве. С другой стороны, такие вмешательства, как правило, менее эффективны и дают относительно небольшой размер эффекта (см., например, недавнее повторение ОЭСР вмешательства «подталкивания к точности») . внимание от вмешательств на системном уровне (таких как критический взгляд на алгоритмы рекомендаций платформ социальных сетей).). Хотя вмешательства на индивидуальном уровне вряд ли нанесут вред, не всегда ясно, насколько хорошо они работают в реальном мире.

Подробнее читайте в сети форумов: «Цифровой базар: как школы могут помочь учащимся справляться с непониманием и двусмысленностью в век информации », автор Андреас Шлейхер , директор по вопросам образования и навыков, ОЭСР .

|

Prebunking: снижение восприимчивости к дезинформации

Тем не менее, как психологи, мы сосредоточены на разработке вмешательств на индивидуальном уровне. Распространенным подходом к борьбе с дезинформацией на индивидуальном уровне является разоблачение (или проверка фактов). Хотя мы думаем, что этот подход оправдан — и исследования в целом показывают, что он эффективен при исправлении неправильных представлений, — у него также есть некоторые ограничения. Например, исправление неправильного восприятия не полностью стирает память людей о нем, явление, известное как « эффект продолжающегося влияния ». Еще одна проблема заключается в том, что проверки фактов часто не достигают людей, подвергшихся первоначальной дезинформации.

Поэтому полезно также изучить, как можно предотвратить попадание людей на дезинформацию в первую очередь. Обобщающим термином для таких подходов является предварительное разоблачение или упреждающее разоблачение. Несмотря на то, что существует множество различных методов предварительного укрытия, мы предпочитаем подход, известный как теория прививки . Теория прививки, первоначально разработанная в 1960-х годах, утверждает, что люди могут выработать психологическую устойчивость к будущим попыткам манипуляции, упреждающе подвергая их «ослабленной дозе» дезинформации.

Хотя было показано, что теория прививки в целом эффективна , одним ограничением является ее масштабируемость. Прививка людей от каждого отдельного примера дезинформации невозможна, потому что вы не всегда можете заранее знать, с каким конкретным контентом люди столкнутся. Вместо этого, чтобы смягчить эту проблему, исследователи решили привить людей от методов и приемов , которые лежат в основе дезинформации, которую мы видим в Интернете (например, эмоциональное манипулирование или конспирологические рассуждения). Преимущество этого подхода заключается в том, что вы можете разработать меры, применимые к гораздо более широкому спектру дезинформации.

Мы разработали серию таких интервенций прививки на основе техники . К ним относятся такие игры, как Bad News (где вы играете за владельца веб-сайта с фальшивыми новостями), Harmony Square (где вы проводите кампанию по дезинформации, чтобы разбить мирное сообщество) и Go Viral! (где вы погружаетесь в эхо-камеру COVID-19). Исследователь Джон Кук разработал Cranky Uncle , игру, в которой вы узнаете о различных тактиках, используемых для дезинформации о климате.

Рисунок 2 . Скриншоты из Bad News , Harmony Square , Go Viral! и игры Cranky Uncle .

Однако, хотя эти игры, как правило, достаточно эффективны для улучшения способности людей распознавать дезинформацию в течение нескольких недель , они также имеют ограниченную масштабируемость. Ведь не всем интересно играть в игры. Чтобы решить эту проблему, мы в партнерстве с Google Jigsaw разработали серию коротких видеороликов о прививках , каждый из которых посвящен определенной технике манипулирования, часто встречающейся в Интернете: язык эмоционального манипулирования; ложные дихотомии; непоследовательность; атаки ad hominem; и поиск козлов отпущения.

В недавнем исследовании , опубликованном в журнале Science Advances , мы проверили, насколько хорошо эти видео помогают повысить устойчивость к дезинформации. Сначала мы провели шесть лабораторных исследований с большой выборкой и обнаружили, что видео эффективно улучшают способность людей распознавать манипулятивный контент. Однако эффективность в лаборатории не всегда означает эффективность в реальных условиях. Поэтому мы запустили два видео в качестве рекламной кампании на YouTube и использовали YouTube BrandLift .возможность попросить людей, которые видели видео, определить методы манипуляции в заголовках новостей. Мы обнаружили, что люди, которые смотрели видео о прививках, справились с этим на 5-10% лучше, чем контрольная группа. Это очень обнадеживающее открытие, особенно потому, что пользователи YouTube могут пропускать рекламу, выключать звук или переключать вкладки.

Упреждающая борьба с дезинформацией в больших масштабах кажется осуществимой, в том числе в реальных социальных сетях.

Несмотря на эти обнадеживающие результаты, остаются некоторые ограничения: помимо ограниченной эффективности вмешательств на индивидуальном уровне, мы еще не изучали, влияет ли предварительная дезинформация на поведение людей (например, обмен дезинформацией с другими). Тем не менее, превентивная борьба с дезинформацией в масштабе представляется осуществимой, в том числе в реальных социальных сетях.

Посетите наш веб-сайт , чтобы посмотреть видео, поиграть в игры и узнать больше об исследованиях!

Источник:

https://www.oecd-forum.org/posts/prebunking-staying-ahead-of-the-curve-on-misinformation