В этом блоге Джим Фрухтерман — новатор в области ИИ, ставший лидером некоммерческой организации — исследует, как технология Retrieval-Augmented Generation (RAG) предлагает практичный и безопасный путь использования ИИ в социальном секторе. Подчеркивая опасности неконтролируемого использования ИИ в чувствительных общественных контекстах, он опирается на недавние успешные примеры использования RAG, чтобы показать его как многообещающий способ сочетания силы генеративного ИИ с достоверной информацией, специфичной для конкретной области.

Лидеры социального сектора постоянно спрашивают меня о советах по использованию ИИ. Как человек, который основал коммерческие компании машинного обучения (ИИ) в 1980-х годах, но затем перешел на управление некоммерческими социальными предприятиями, я часто оказываюсь первым человеком из Кремниевой долины, с которым встречаются многие лидеры некоммерческих организаций. Я шучу, что моя роль часто заключается в том, чтобы быть «антиконсультантом», отговаривая лидеров от создания приложения, блокчейна (улыбка) или увольняя половину их сотрудников из-за ИИ. В последнее время большая часть моей роли заключается в снижении чрезмерных ожиданий, которые высказываются относительно влияния ИИ на организации. Однако спустя два года после последней волны моды на ИИ, созданной ChatGPT и его коллегами LLM (большая языковая модель), все больше и больше лидеров описывают в высшей степени разумные применения LLM в своих программах. Наиболее частые из этих подходов можно описать как вариации «поисково-дополненной генерации», также известной как RAG. Я с большим энтузиазмом отношусь к использованию RAG для оказания социального воздействия, поскольку он отвечает реальной потребности и задает рамки для эффективного использования степеней магистра права.

Справочная информация о некоммерческих приложениях ИИ

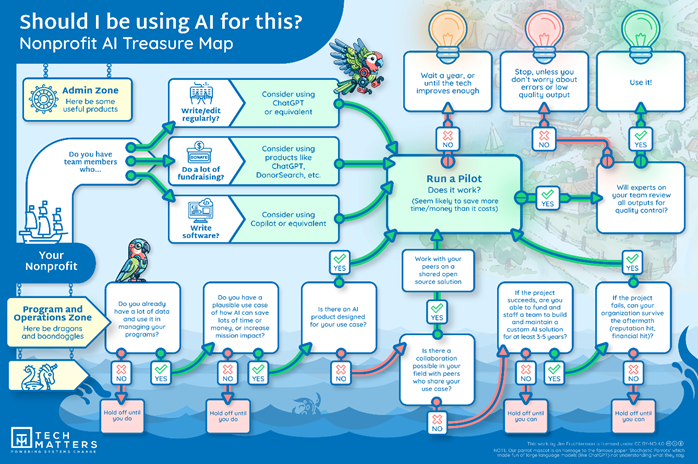

В связи с возросшим числом разговоров об ИИ за последние два года я создал Карту сокровищ ИИ для некоммерческих организаций (ниже), чтобы помочь нетехническим лидерам ориентироваться в сфере ИИ (а также написал сопроводительную статью « Стоит ли использовать ИИ для этого ?»).

Карта сокровищ делит мир на две половины: зону администрирования и зону программ и операций. Зона администрирования касается сотрудников некоммерческой организации и инструментов, которые они используют для выполнения своей работы. И поскольку инструменты ИИ склонны «придумывать всякое», что не является правильным, эти задачи всегда должны выполняться при активном участии людей. Зона администрирования — это то место, где большинство некоммерческих организаций наиболее активно используют продукты на основе LLM, такие как Gemini и ChatGPT.

Я гораздо более осторожен, когда дело касается развертывания ИИ в Программной и операционной зонах. Здесь люди, взаимодействующие с ИИ, не являются внутренними сотрудниками, а членами общественности, для обслуживания которых существует некоммерческая организация. Здесь ошибки технологии ИИ могут привести к серьезным последствиям. Поскольку у некоммерческих организаций есть центральная социальная миссия, простая экономия денег не является веской причиной для внедрения ИИ, если люди в обслуживаемых сообществах пострадают. Мы уже знаем о многочисленных случаях, когда инструменты ИИ вели себя ужасно неправильно, от предоставления неправильных советов людям, страдающим от расстройств, связанных с весом, до даже поощрения самоубийства (с трагическими результатами ). Некоммерческим организациям может быть даже сложнее безопасно внедрить ИИ, чем их коммерческим коллегам, потому что они с большей вероятностью будут работать с конфиденциальными данными об уязвимых людях, тогда как в коммерческих случаях использования ставки могут быть ниже (например, предоставление рекомендаций по продуктам).

Основная проблема генеративного ИИ (вроде LLM) заключается в том, что его работа заключается в том, чтобы придумывать всякую всячину. И когда вы просите совета у среднего человека в Интернете или спрашиваете, является ли определенный факт правдой, вы можете быть разочарованы тем, что получаете. Неудивительно, что инструмент генеративного ИИ для консультирования по вопросам веса, обученный в Интернете, может дать неправильный совет. Или что его ответ на математическую задачу может быть просто правдоподобным, но неверным. Открытая природа этих инструментов означает, что им не хватает основных защитных барьеров, необходимых для уверенного использования в приложениях общественного блага.

Я рекомендую некоммерческим организациям дождаться, когда инструмент ИИ станет доступен в виде продукта, который, скорее всего, будет иметь встроенные функции безопасности, а затем тщательно протестировать его в вашем варианте использования. В случаях, когда технология ИИ не справляется с задачей сегодня, я призываю лидеров просто подождать год. Технология развивается очень быстрыми темпами, и то, что не работает сейчас, может отлично работать через год или два.

Введите RAG

Центральным подходом к безопасности и эффективности в более продвинутых приложениях GenAI является ограничение контента, который инструменту ИИ разрешено генерировать. Таким образом, когда инструменту задают вопрос, он не просто генерирует ответ на основе огромного количества текста (из Интернета в целом), на котором обучалась модель. Эти широкие наборы данных могут быть полны неприятного контента, как, например, инструмент генерации изображений, который включал изображения сексуального насилия над детьми в свой обучающий набор. И эти общие наборы данных могут отсутствовать (и, вероятно, отсутствуют) наиболее релевантной информации для использования в социальном секторе. Генерация с дополненным поиском добавляет набор дополнительных знаний, специфичных для предметной области, которые используются для улучшения ответа. Отсюда и аббревиатура: сгенерированный ответ улучшается за счет дополнения путем извлечения надежных знаний, специфичных для предметной области. Короче говоря, ответы от системы RAG с гораздо меньшей вероятностью будут ложными или вводящими в заблуждение ответами, поскольку у нее есть доступ к надежному набору авторитетной информации, и системе ИИ предписано основывать свой ответ на этом надежном наборе информации. Как этот подход работает на практике?

Мой первый пример развернутой системы RAG — это IDR Answers , созданный проектом с открытым исходным кодом Apurva.AI в партнерстве с Indian Development Review, ведущей медиаплатформой Индии по благотворительности и социальному воздействию. IDR Answers основан на более чем 2000 статей, опубликованных Indian Development Review. Помимо ответа на вопрос, он также отображает статьи, на которых основывался ответ. Этот опыт очень похож на общение с экспертом, который знает весь контент IDR и может обобщить его в аккуратный и опрятный ответ на основе этой базы знаний. Теперь IDR Answers вряд ли станет отличным источником информации о том, что происходит в Замбии в сфере развития, хотя замбийский эксперт все равно может получить пользу от консультаций IDR Answers по поводу идей, которые сработали в Индии и могли бы быть перенесены в замбийский контекст.

Мой второй пример — Digital Green и их чат-бот с советами Farmer.CHAT. У Digital Green есть тысячи и тысячи видео-советов для фермеров на их родных языках. Эти видео стали исходным материалом для проекта RAG, проводимого Digital Green , некоммерческой организацией, действующей в Азии и Африке. До того, как Digital Green выпустила своего чат-бота на фермеров, они предоставили его правительственным агентам по распространению сельскохозяйственных знаний, которые обеспечили дополнительный раунд отзывов и улучшений. Теперь, когда фермер просит совета у сервиса Farmer.CHAT, он с большой вероятностью получит короткий видеофрагмент, где кто-то говорит на его языке и показывает, как решить его конкретную проблему, будь то террасирование поля или борьба с вредителями сельскохозяйственных культур.

Имейте в виду, что эти ранние последователи имели доступ к серьезным технологическим талантам и финансированию. Digital Green провела два года с командой из более чем двадцати технологов, разрабатывая Farmer.CHAT. А наследие Apurva.AI включает в себя некоторых ведущих лидеров технологий Индии. Но то, что было передовым год или два назад в технологиях, вероятно, станет доступным для все большего числа организаций. Например, я думаю, что новые реализации RAG в следующем году будут все более осуществимы с одним знающим технологом и высококачественным набором данных, который хорошо охватывает предметную область. Это потому, что будут продукты, которые поддерживают RAG и облегчают его применение в определенных контекстах.

То же самое уже относится к инструментам предиктивного ИИ. У Google и Facebook есть инструменты с открытым исходным кодом, такие как TensorFlow и PyTorch, которые могут передать создание решений ИИ в руки одного разработчика программного обеспечения с доступом к интересному набору данных. Такие ресурсы, как Hugging Face (да, именно так и называется!) также весьма полезны для практиков ИИ сегодня.

Наконец, обсуждение использования ИИ для приложений социального воздействия должно учитывать этический сбор и использование данных. Например, принципы, изложенные в Better Deal for Data, призваны заверить сообщества в том, что их данные не будут использованы против них.

Заключение

Это захватывающие времена для расширения использования ИИ в некоммерческих организациях. Однако, если организация хочет использовать ИИ в своей программной работе, где ИИ будет взаимодействовать с обслуживаемыми сообществами или поддерживать их, это будет зависеть по крайней мере от некоторых внутренних технических возможностей. Возможно, это не потребует разработчиков технологий, но внутри общественных организаций по-прежнему будет существовать потребность в хороших данных для эффективного использования ИИ. Во-первых, все упомянутые мной программные применения ИИ требуют интересного объема данных для их запуска. Эти данные также должны быть высокого качества. И важно отметить, что большинство языков мира в настоящее время не поддерживаются сегодняшними инструментами ИИ, что делает проекты на языках, отличных от английского и подобных высокоресурсных языков, более сложными.

Наконец, ваша команда должна знать достаточно о данных и социальном влиянии вашей работы, чтобы контролировать инструменты ИИ, настраивать их, чтобы они не сходили с пути. Решения ИИ всегда допускают ошибки: ваша команда отвечает за контроль качества, чтобы гарантировать, что решение ИИ действительно лучше альтернативы. Решения RAG по-прежнему не застрахованы от галлюцинаций LLM и по-прежнему нуждаются в тщательном тестировании и снижении рисков, хотя они существенно снижают риск галлюцинаций. Решая проблему номер один технологии генеративного ИИ, которая заключается в составлении неправильного ответа, решения RAG являются многообещающим способом использования этой технологии, предоставляя необходимую проверенную информацию и ограждения.