В «Докладе о глобальных рисках 2025» Всемирного экономического форума дезинформация занимает центральное место среди краткосрочных угроз, отражая её разрушительное воздействие на общественное доверие и стабильность. Дезинформация, наряду с вооружёнными конфликтами и экологическими рисками, рассматривается как одна из наиболее серьёзных проблем современности.

Согласно отчёту, дезинформация и её распространение продолжают подрывать социальную сплочённость и доверие к институтам, усугубляя разногласия внутри и между странами. Это подчёркивает необходимость разработки стратегий по противодействию дезинформации на глобальном уровне.

В краткосрочной перспективе дезинформация остаётся ведущим риском, что подчёркивает её устойчивую угрозу для общества. Респонденты отчёта выражают обеспокоенность тем, что дезинформация может способствовать дестабилизации и подрыву доверия к управлению, осложняя необходимость сотрудничества для решения общих кризисов.

В долгосрочной перспективе технологические риски, связанные с дезинформацией и негативными последствиями использования искусственного интеллекта, также вызывают серьёзные опасения. Это подчёркивает необходимость разработки этических норм и стандартов для предотвращения использования технологий в целях дезинформации.

В условиях растущей фрагментации и геополитической напряжённости дезинформация может усиливать недоверие и поляризацию в обществе. Это требует от лидеров приоритизации диалога и укрепления международных связей для противодействия распространению дезинформации.

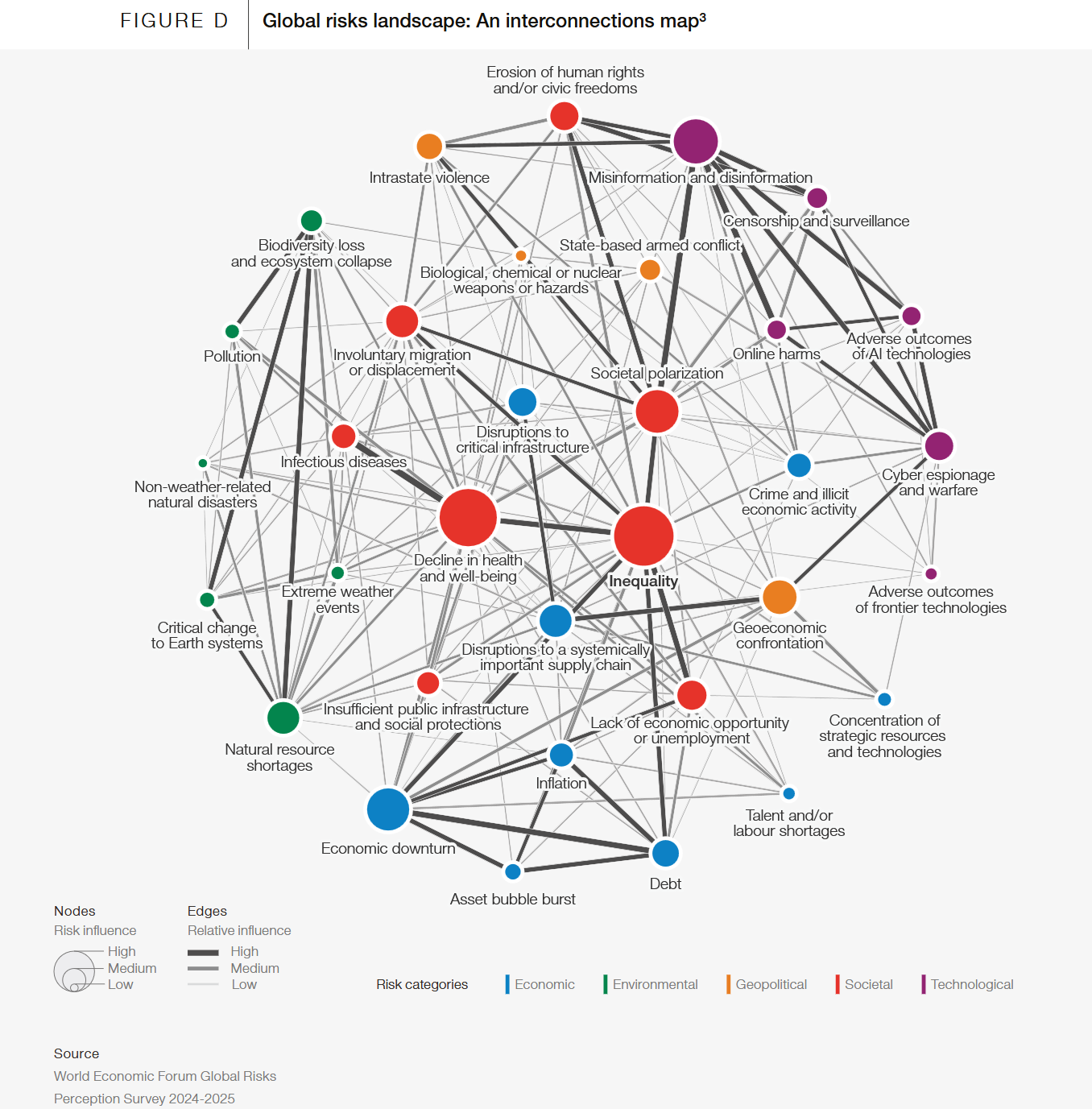

Доклад подчёркивает, что дезинформация является не только самостоятельной угрозой, но и фактором, усугубляющим другие глобальные риски, такие как вооружённые конфликты и экологические кризисы. Поэтому борьба с дезинформацией должна быть интегрирована в более широкий контекст управления глобальными рисками.

В целом, «Доклад о глобальных рисках 2025» акцентирует внимание на необходимости коллективных усилий и сотрудничества для эффективного противодействия дезинформации и связанных с ней угроз. Только через совместные действия можно укрепить доверие и обеспечить стабильное будущее для всех.

Текущая глобальная картина рисков

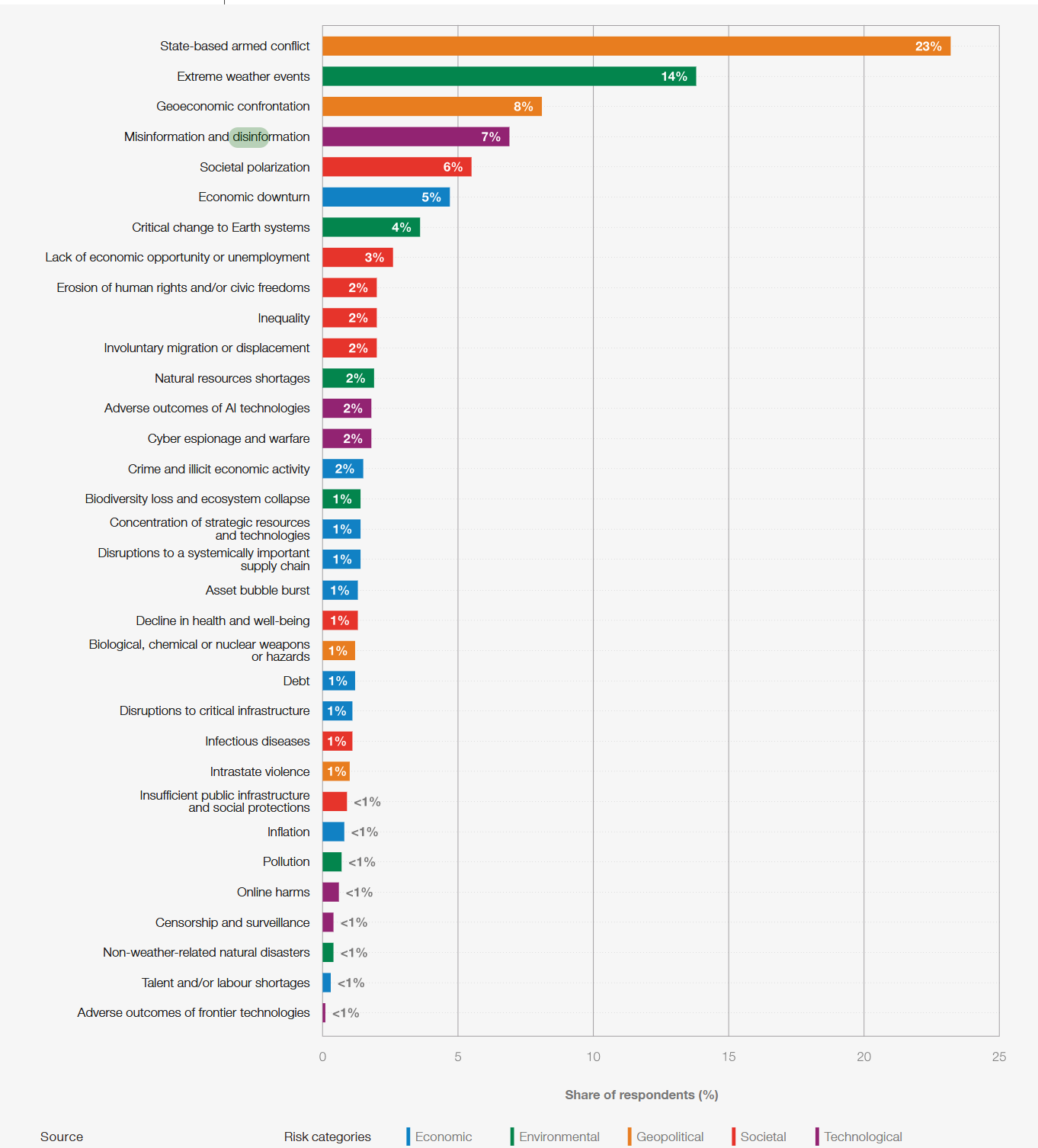

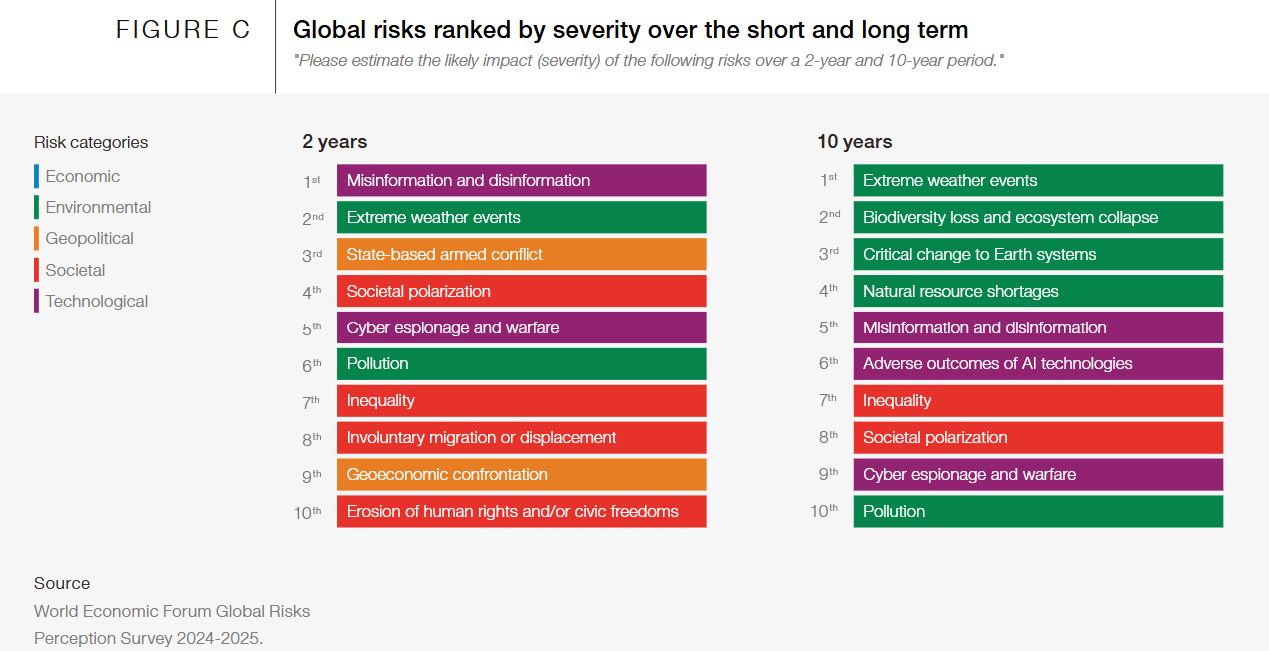

Глобальные риски, ранжированные по степени серьезности в краткосрочной и долгосрочной перспективе

Глобальный ландшафт рисков: карта взаимосвязей

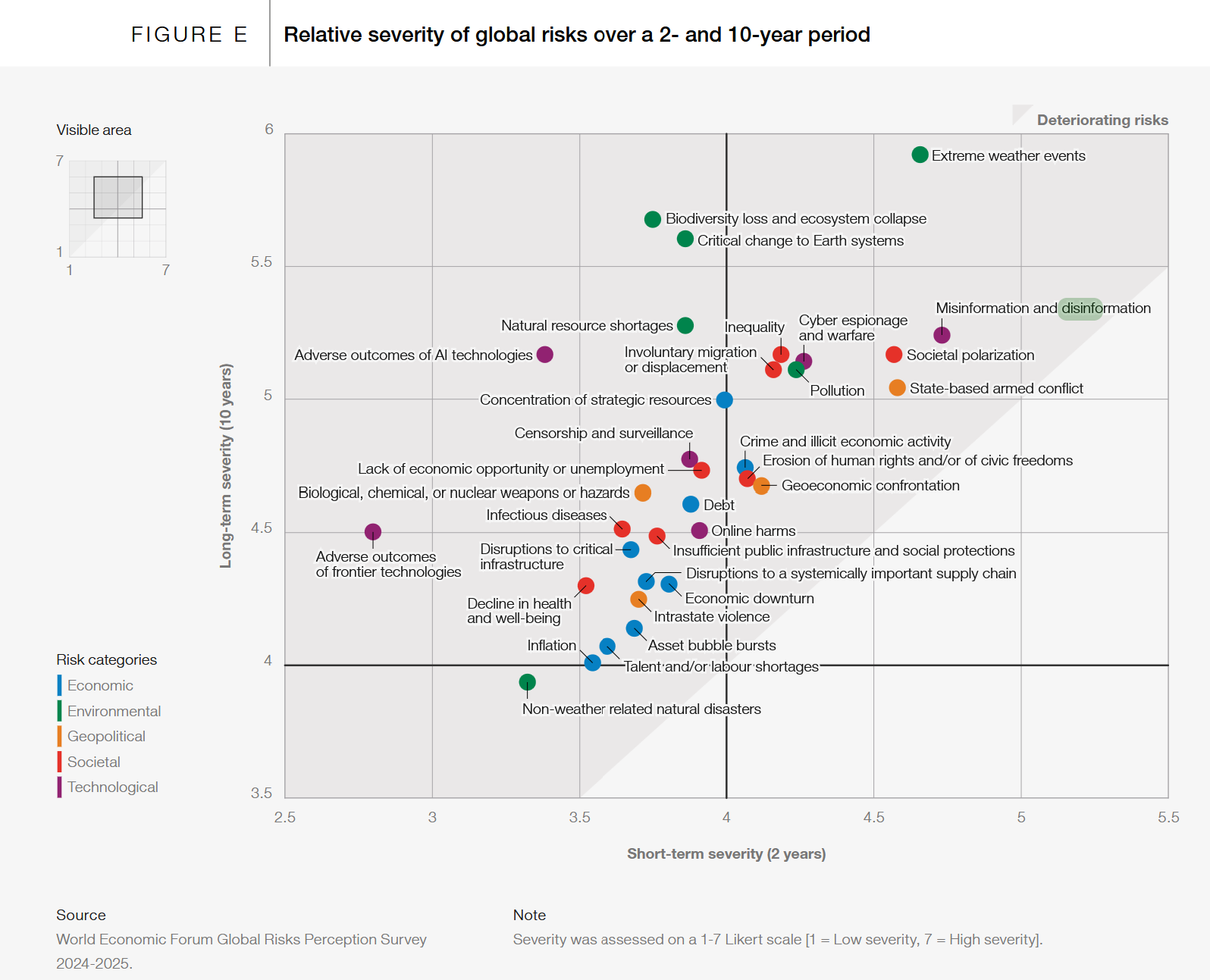

Относительная серьезность глобальных рисков за 2- и 10-летний период

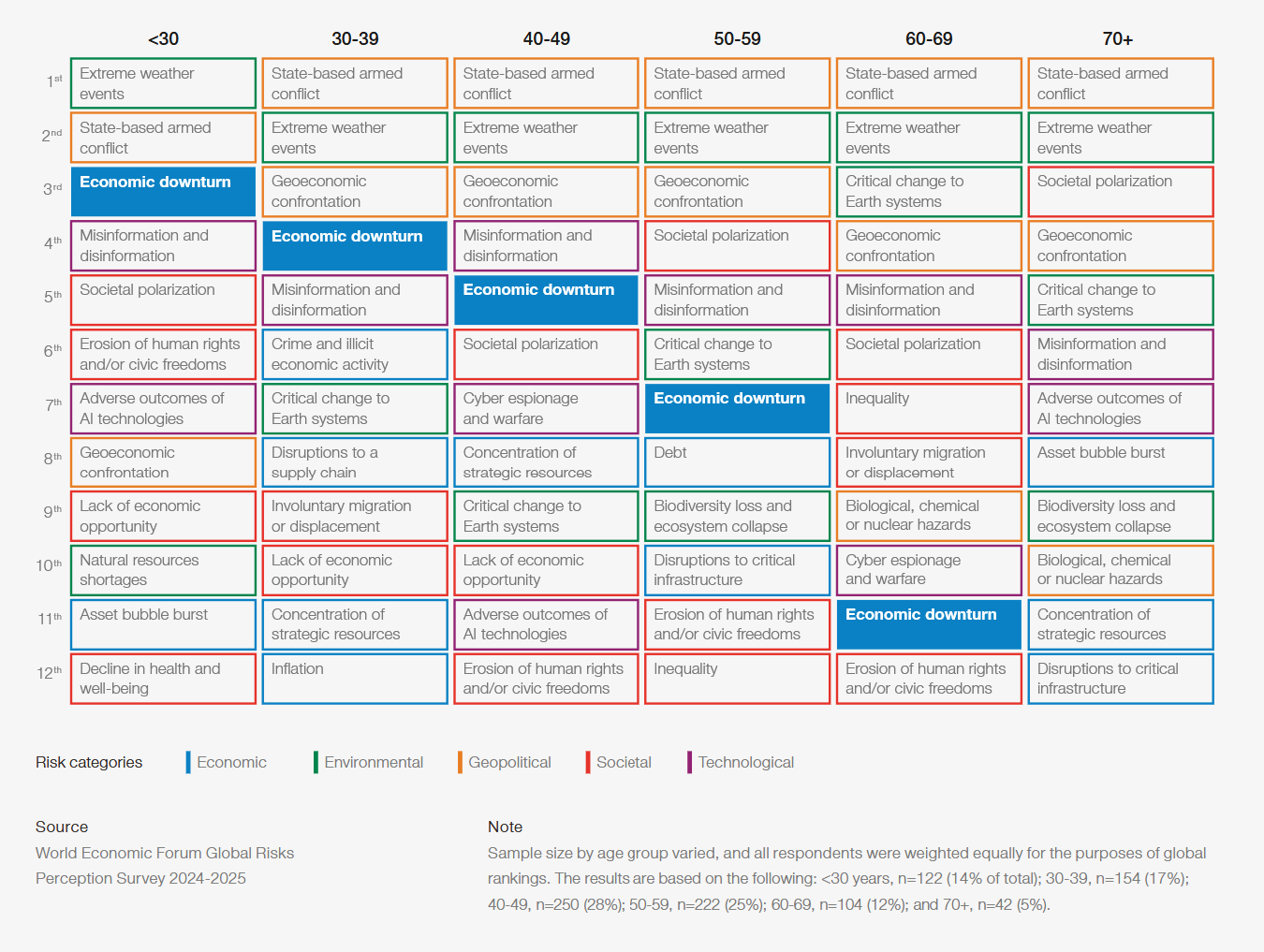

Глобальные риски, ранжированные по степени серьезности в краткосрочной и долгосрочной перспективе

Текущие глобальные риски по возрастным группам

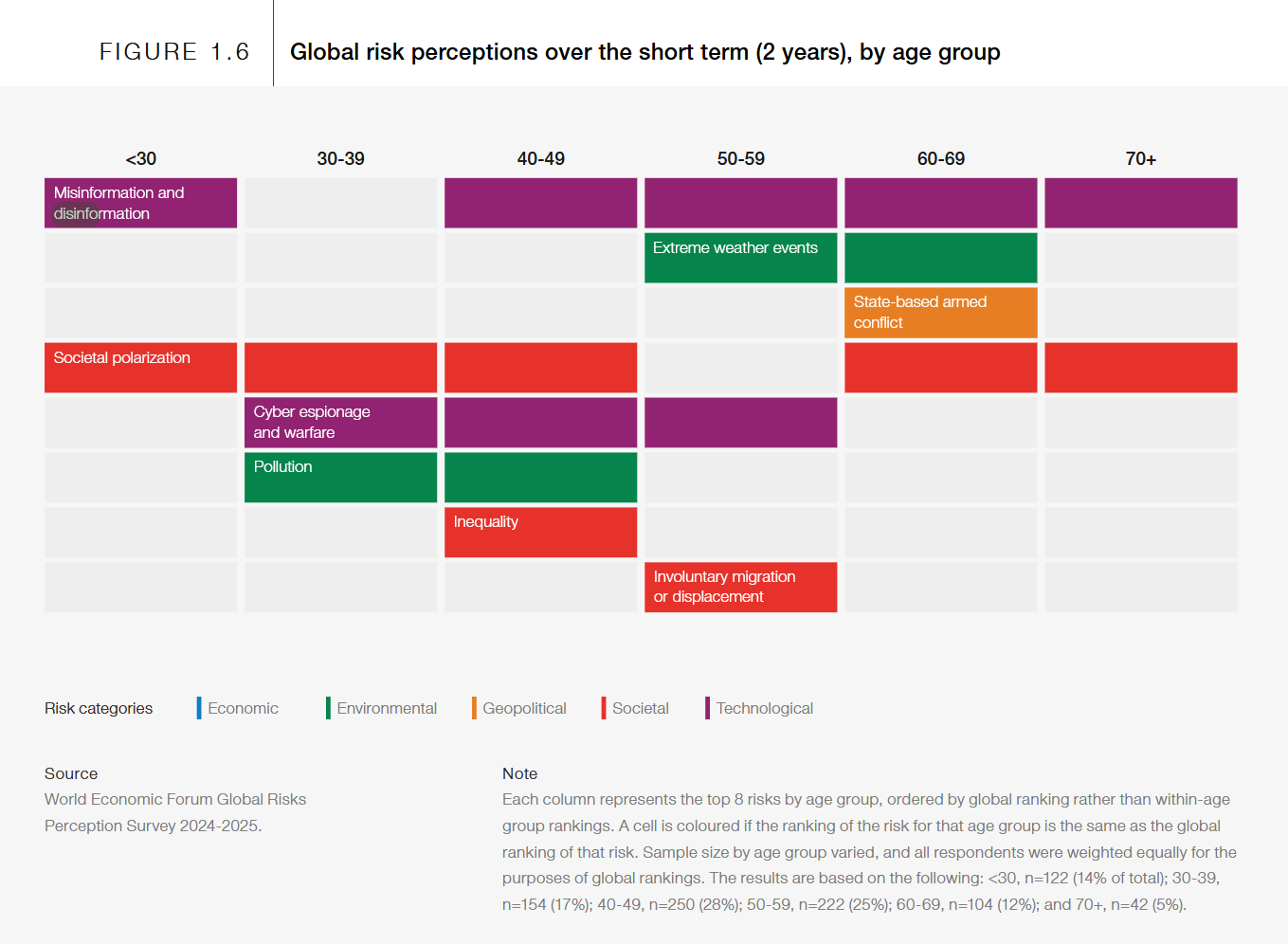

Глобальное восприятие риска в краткосрочной перспективе (2 года) по возрастным группам

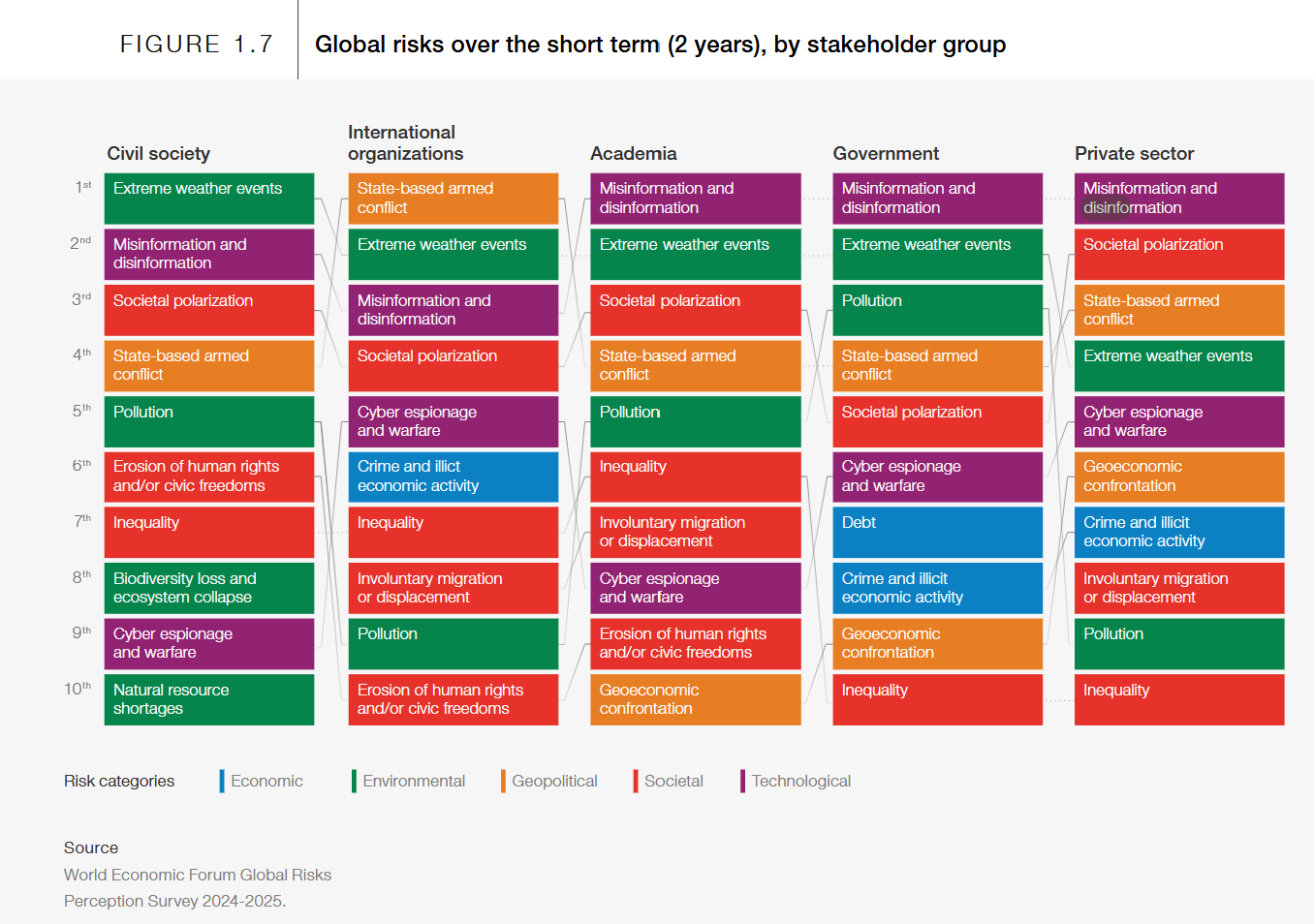

Глобальные риски в краткосрочной перспективе (2 года) по группам заинтересованных сторон

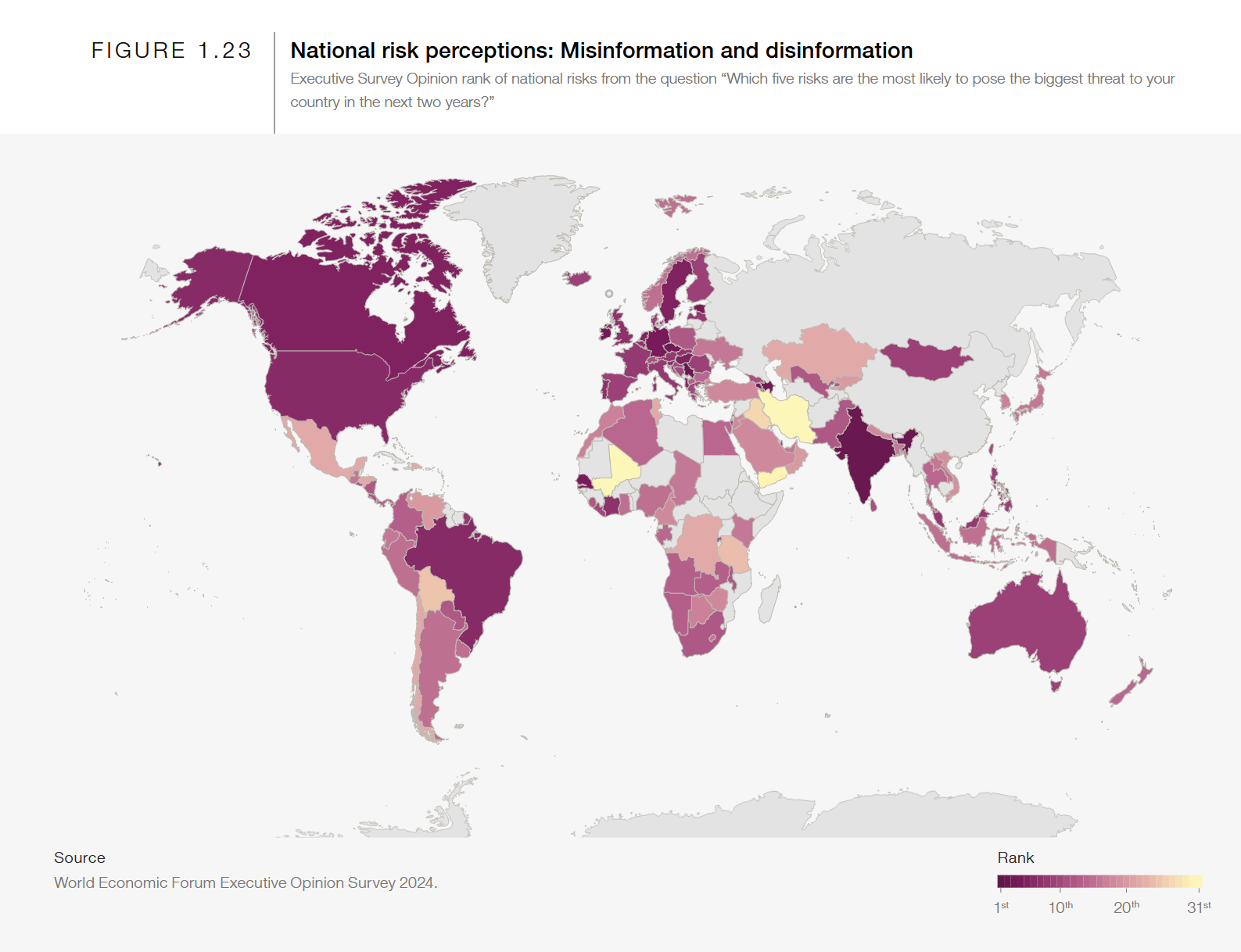

Дезинформация и дезинформация в поляризованном мире Появление новых технологий и увеличение платформ контента, создаваемого пользователями, приводит к соответствующему росту объема контента в Интернете. Потоки дезинформации и дезинформации от тех, кто ее создает, становится все сложнее обнаруживать и удалять в условиях все более фрагментированного медийного ландшафта. Различение ложного или вводящего в заблуждение контента, созданного ИИ и человеком, — в форме видео, Global Risks Report 2025 34 Национальное восприятие риска: дезинформация и дезинформацияРИС. 1. 2. 3 Источник Опрос мнения руководителей Всемирного экономического форума 2024 г. Рейтинг мнений руководителей национальных рисков по вопросу «Какие пять рисков, скорее всего, будут представлять наибольшую угрозу для вашей страны в ближайшие два года?» 1-е 10-е 20-е 31-е изображения, голос или текст — могут быть сложными. GenAI снижает барьеры для производства и распространения контента, и часть этого контента является неточной. Угрозы, государственные органы в некоторых странах,49 группы активистов и отдельные лица, которые могут или не могут иметь преступные намерения, могут автоматизировать и расширять кампании по дезинформации, значительно увеличивая их охват и воздействие.50 Дезинформация и дезинформация также могут быть результатом галлюцинированного ИИ контента или человеческой ошибки, и они тоже, вероятно, будут расти на фоне растущего объема контента. В результате становится все труднее знать, куда обратиться за истинной информацией. И политическая, и общественная поляризация искажают повествования и искажают факты, способствуя низкому и снижающемуся доверию к СМИ.51 В выборке из 47 стран только 40% респондентов заявили, что доверяют большинству новостей.52 По данным EOS, респонденты в странах с высоким уровнем дохода, как правило, более склонны выражать обеспокоенность по поводу риска дезинформации и недостоверной информации в течение следующих двух лет, чем респонденты в странах с низким уровнем дохода, за некоторыми исключениями. Этот риск входит в пятерку основных в 13 странах, включая Индию, Германию и Канаду, и входит в десятку основных в 30 дополнительных странах (Рисунок 1.23). Респонденты, идентифицирующие этот риск, часто также выделяют общественную поляризацию как один из самых серьезных рисков в тот же период времени. Низкое качество контента и отсутствие доверия к источникам информации продолжают представлять угрозу для общества.53 Алгоритмы, особенно сложные модели машинного обучения, также могут быть точкой входа для кибератак, использующих дезинформацию. Примером этого может быть атака с использованием структурированного языка запросов, в которой входные данные манипулируются для получения неверных результатов или компрометации обучающих наборов данных.54 Поскольку многие модели не прозрачны, либо намеренно, случайно, либо из-за внутренней непрозрачности, трудно выявить уязвимости и смягчить потенциальные угрозы. Кроме того, учитывая зависимость алгоритмов от сторонних источников данных, программных библиотек и сетевых инфраструктур, субъекты угроз могут поставить под угрозу цепочку поставок, чтобы манипулировать алгоритмами и нанести масштабный ущерб. Кроме того, поскольку алгоритмы начинают управлять или влиять на большее количество аспектов общества, растет потенциал для скоординированных кибератак с использованием автоматизированных систем. Global Risks Report 2025 35 Алгоритмическая предвзятость Алгоритмическая предвзятость может как зависеть от Дезинформации, так и от дезинформации, а также может быть ее причиной.55 Риски алгоритмической предвзятости повышаются, когда данные, используемые для обучения модели ИИ, сами по себе являются предвзятой выборкой. Иногда предвзятость может быть очевидной. Например, в процессе найма набор биографий, используемых в качестве примеров хороших кандидатов, может быть составлен из пула предыдущих кандидатов, все из которых могут иметь один и тот же пол, расу или национальность. В других случаях предвзятость может быть менее очевидной: например, модель может быть обучена на предыдущих расходах граждан на образование, без учета определенных групп меньшинств, обычно тратящих меньше на образование. Синтетические данные могут использоваться с целью устранения предвзятости, но это само по себе может внести новые предвзятости.56 Примеры предвзятости в отношении граждан включают время ожидания назначения в правительстве, назначаемое на основе сомнительного набора входных данных и критериев, или автоматизированные ответы, не отвечающие адекватно потребностям граждан. Когда алгоритмы применяются к чувствительным решениям, предвзятость в обучающих данных или предположениях, сделанные во время проектирования модели, могут увековечить или усугубить неравенство, еще больше лишая избирательных прав маргинализированные группы. Прогностическая деятельность полиции является одной из областей, где алгоритмическая предвзятость, основанная на расе, может быть проблемой. 57 Такие риски еще больше усиливаются, когда нет участия человека в принятии решений. Если нет четких рамок подотчетности, использование автоматизированных алгоритмов усложняет назначение ответственности, когда принимаются вредные или ошибочные решения, особенно когда участвует ИИ. Автоматизированные алгоритмы часто работают как «черные ящики», что затрудняет для людей понимание того, как принимаются решения. Это отсутствие прозрачности и ответственности может способствуют недоверию и скептицизму в отношении справедливости и точности принятых решений. Во многих случаях алгоритмическая предвзятость может быть результатом недостатка знаний, тестирования или достаточного надзора. То, как модель разрабатывается, применяется и управляется, является ключом к смягчению этих рисков. Независимо от используемого входного набора данных, личные предвзятости людей, проектирующих предположения модели, также могут играть роль в приведении к несправедливым результатам. Эти личные предвзятости могут быть случайными (например, результатом того, что те, кто вводит данные, имеют недостаточные технические знания) или преднамеренными, например, для достижения политических целей. Один риск, который может стать более заметным в течение следующих двух лет, — это алгоритмическая предвзятость против политической идентичности людей.58 Алгоритмическая политическая предвзятость может использоваться намеренно, например, для влияния на набор на должности в государственном секторе или на доступ к определенным государственным услугам или финансовым услугам. Что делает этот риск особенно опасным, так это то, что политические предубеждения отдельных лиц широко известны, и эти предубеждения могут легко найти свой путь в алгоритмах или наборах данных. Кроме того, политические взгляды отдельных лиц могут все чаще определяться, даже против их воли, по их действиям в Интернете.59 Подобно индивидуальным предубеждениям, общественные предубеждения также могут играть свою роль.60 Они, вероятно, станут более распространенными по мере углубления социальных разногласий. В GRPS, социальная поляризация занимает 4-е место в течение двухлетнего временного горизонта. В региональном плане, Латинская Америка и Карибский бассейн, Восточная Азия и Европа проявляют наибольшую обеспокоенность по поводу социальной поляризации в течение следующих двух лет, согласно EOS.

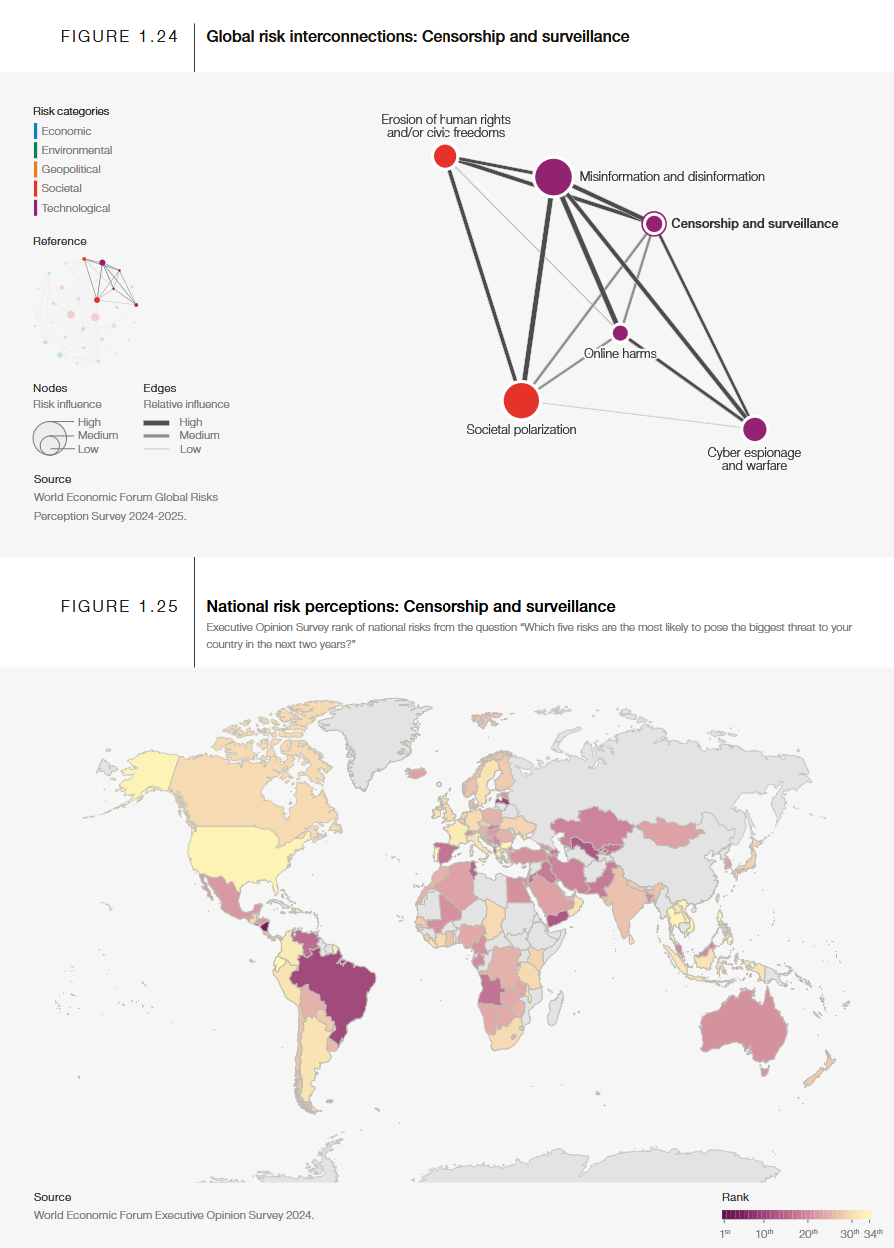

Глобальные взаимосвязи рисков: цензура и наблюдение

Национальное восприятие риска: Дезинформация

Источник:

https://www.weforum.org/publications/global-risks-report-2025/digest/